文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

大家一直在担心:AI越来越烧钱 , ChatGPT的订阅费会不会年年涨?

更让人头疼的 , 是用AI时越来越容易卡顿、掉链子 。

罪魁祸首 , 其实是芯片过热 。 随着新一代AI芯片疯狂堆算力 , 传统风冷和冷板都快压不住了 。

就在刚刚 , 微软CEO Satya Nadella在X上发声:

我们正在重新想象芯片的冷却方式 , 让未来的 AI 基础设施更高效、更可持续 。

这句话背后 , 是微软刚刚公布的一项「黑科技」——把冷却液直接送进芯片体内的微小通道 , 让散热效率最高提升三倍 。

它的出现 , 或许正是打破「热瓶颈」的关键 。

芯片体内的冷却液:微软的液体血管方案AI正在变得越来越「烫」 。

模型规模膨胀 , 算力需求暴涨 , 背后的芯片像一台台发动机在高温下狂奔 。

风冷、液冷、冷板 , 这些过去还能顶住的散热方式 , 如今都快被逼到极限 。

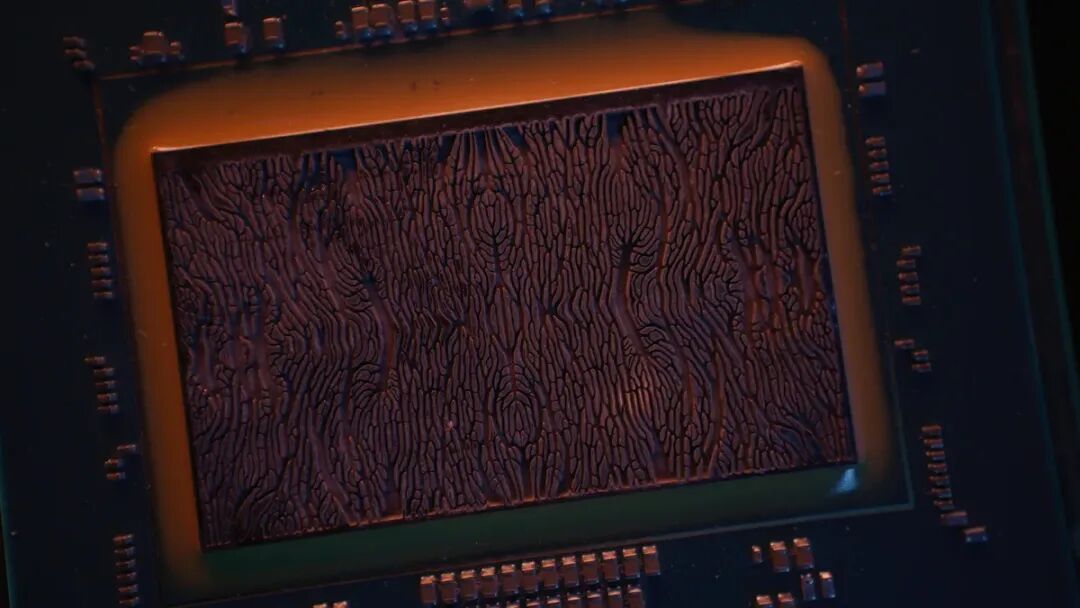

微软在最近公布的一项实验里 , 直接把冷却液送进了芯片体内 , 在硅片背面蚀刻出比头发丝还细的沟槽 , 让液体像血管一样流过 , 把热量从源头带走 。

这种听起来像科幻的「微流体冷却」 , 实验结果相当惊人 。

在微软披露的数据里 , 它的散热效率最高比冷板强三倍 , GPU内部的温升能下降65% 。

对工程师来说 , 这意味着在同样的硬件上 , 可以撑住更大的负载 , 而不会因为温度过高被迫降频甚至宕机 。

走到这一步并不容易 。

微软团队在一年里连续做了四轮迭代 , 才摸索出既不会堵塞又能保证芯片强度的微通道设计 。

微软Cloud Operations and Innovation的系统技术总监Husam Alissa直言:

开发微流体冷却 , 必须用系统思维来理解——硅片、冷却液、服务器、整个数据中心的交互 。

Husam Alissa , 微软云运营与创新系统技术总监 。

为了让冷却液更精准覆盖芯片热点 , 研究人员借助AI设计出仿生结构 , 像叶脉一样分支 , 效率远超直线通道 。

微软还与瑞士初创公司Corintis合作 , 解决了蚀刻、封装、防漏液等一系列工程难题 。

数据亮眼 , 但最终还要靠真实负载来验证 。

微软选择了自家Teams作为测试场景 。

每到整点或半点 , 会议量暴增 , 服务器瞬间高负载 。 传统散热方案下 , 要么堆更多闲置硬件 , 要么冒险让芯片持续高温 。

微流体冷却则让另一种可能出现:在关键时刻安全地「超频」 , 顶住需求高峰 。

【一年4次迭代,狂堆GPU成真,微软AI冷液灌芯,散热暴涨3倍】微软技术研究员Jim Kleewein总结道:

微流体冷却提升了成本、可靠性、速度、可持续性……几乎所有关键指标 。

当冷却液真正流进芯片「血管」 , AI的下一步扩展才有了新的底气 。

芯片越来越烫 , AI还撑得住吗?AI的「发烧」并不是比喻 , 而是真实的物理现象 。

每一代算力芯片都在推高功耗 , 从几百瓦到上千瓦 , 热量像滚雪球一样堆积 。

过去数据中心还能用风冷、冷板顶住 , 但在今天的AI峰值负载下 , 这些技术逐渐捉襟见肘 。

正如微软项目负责人Sashi Majety警告的那样:

在五年之内 , 如果你还主要依赖冷板技术 , 你就被困住了 。

背后的原因不难理解 。

以数据中心整体能耗为例 , 国际能源署(IEA)在报告中预测:全球为满足数据中心的用电需求 , 电力供给将从2024年的约460TWh增长 , 至2030年超过1000TWh 。

也就是说 , 数据中心整体的电力需求有可能在六年左右翻倍 。

再看美国本土的数据:据美国国会研究服务处(CRS)报告 , 2023年美国数据中心的用电量约为176TWh , 占当年美国电力总消耗的4.4% 。

若在未来几年按趋势继续扩张 , 那么支撑如此庞大规模的冷却系统 , 也将占据极大的基础设施能耗预算 。

冷板散热的问题在于热阻与传导损耗 。

芯片封装层和界面材料存在热阻 , 使得热量向外传递时效率大打折扣 。

随着芯片功率密度提升 , 这些「中间层」的阻碍越严重 , 热量往往被困在芯片里 。

结果就是:为了避免芯片因温度过高降频或损伤 , 厂商不得不在设计里留足余量 , 或者限制性能输出 。

更糟的是 , 为了让冷板工作得更好 , 数据中心不得不把冷却液温度压得更低 。

制冷所需的能耗自身就是一笔不能忽略的开销 。 比如有些大型数据中心用于制冷系统的电力消耗就占了整体能耗的显著比例 。

在这种规模下 , 效率的重要性被放大到了极致 。

微软Azure数据中心部门硬件系统与基础设施副总裁Rani Borkar在接受采访时直言:

当你达到那种规模时 , 效率非常重要 。

这句话 , 道出了整个行业的心声:谁能先把效率做上去 , 谁就能在下一个算力周期占据主动 。

从省钱到不卡顿:微软降温技术的真实影响听起来 , 微流体冷却像是工程师们的游戏 , 可它和我们每个人用AI的体验 , 其实都有影响 。

省下的电费 , 可能就是会员费

训练、运行大模型 , 本身就是一场烧钱的游戏 。

AI模型运行 , 尤其是在云端实时推理时 , 本质上是耗电的 。

一篇行业研究 , 就对比了不同规模大语言模型的推理能耗 , 揭示模型越大、推理越频繁 , 消耗越显著 。

如果散热效率上不去 , 数据中心就只能增加冷却系统或降频运行 , 这些成本最终会压到产品定价上 。

微软内部新闻稿里也曾提到 , 微流体冷却可让芯片内部温升下降65% , 散热效率最高比冷板提高三倍 。

这意味着在同等环境下 , 可以用更低成本维持性能 。

不再做耗电怪兽 , AI也能更绿色

AI的推广伴随着巨大的电力需求 。

MIT在一篇报道中列出 , 生成式AI的普及 , 让数据中心电力、用水等资源受到压力 。

数据中心曾经被比作「能耗怪兽」 , 在某些区域 , 它们的电力需求可相当于成千上万个家庭 。

如果冷却技术更高效 , 就可能让制冷系统的能耗不再占比那么大 , 从而减少总能耗和碳排放 。

更有意思的是 , 微软实验发现 , 即使冷却液温度高达70℃ , 微流体冷却依然能保持高效工作 。

这意味着它不需要像传统冷却方案那样把冷却液降到极低温 , 从源头上就节省了大量能耗 。

这对企业是ESG标签 , 对用户来说 , 就是每一次AI使用 , 都可能少点环境负担 。

从排队到秒出图:冷却液背后的体验升级

你肯定遇到过这样情况:视频会议突然卡顿 , AI图像生成慢得像乌龟 , 或者模型推理慢半拍 。

这些问题部分来源正是因为芯片过热后 , 被迫降频或延迟处理 。

微软在测试里 , 就选择了自家的Teams作为实验对象 。

有趣的是 , Teams的流量并不是平均分布的 。

大多数会议都在整点或半点开始 , 结果就是:在那前后几分钟 , 控制会议的服务器会被瞬间「挤爆」 , 负载陡然飙升 。

传统散热下 , 要么得额外堆很多硬件来对付短短几分钟的高峰 , 要么冒险让芯片长时间高温运行 。

微流体冷却给了另一种可能:在这些高峰时段安全地「超频」 , 让同样的硬件也能撑住需求暴涨 。

对用户来说 , 最直观的变化就是会议不卡了、响应快了 , 不必担心在关键时刻掉链子 。

微软的算盘:不只是降温 , 而是抢跑未来让「冷却液流进芯片」这种听起来科幻的技术落地 , 本身就足够震撼 。

但对微软来说 , 这不过是一场更大博弈中的第一招 。 微软真正的目标 , 其实是抢占AI基础设施的未来入口 。

从资本支出来看 , 它的野心毫不遮掩 。

微软2025财年第四季度的财报显示 , 单季资本支出就达到242亿美元 , 其中大部分直接投向云和AI基础设施 。

此外 , 有媒体报道微软计划在即将到来的季度投入超过300亿美元用于扩容云与AI基础设施 。

这已经不只是「砸钱」 , 而是在为未来二十年的算力格局修地基 。

到目前为止 , 微软已经推出了Cobalt 100和Maia两款自研芯片 , 分别用于通用计算和AI加速 。

如果说微流体冷却是解决「热」的手段 , 那么自研芯片就是把控制权牢牢抓在自己手里——既能减轻对英伟达的依赖 , 又能让冷却、架构和软件层级深度耦合 。

在网络层面 , 微软也没停下脚步 。

比如支持空心光纤 (hollow-core fiber) 的研究 , 让光信号传输损耗降到历史最低(约 0.091 dB/km) , 被视为光纤领域的一次突破 。

对普通用户来说这听起来抽象 , 但放在数据中心就是:服务器节点之间可以更快交流、更少能耗 , AI的反应也更及时 。

除了芯片和网络 , 微软还把目光放在了内存上 。

Borkar在采访中提到 , 高带宽内存(HBM)是当下AI计算的关键瓶颈之一 , 目前微软的Maia芯片仍依赖商业化HBM , 但未来它们也在探索更多自研和优化的可能性 。

这说明微软的棋局 , 远不止散热和芯片 , 还在悄悄补齐整个算力堆栈 。

把这些拼图放在一起看 , 我们会发现微软走的是「三线作战」:散热技术解决硬件的物理瓶颈 , 自研芯片降低外部依赖 , 网络革新打通节点之间的传输效率 。

它要建的不仅是一个更冷静的数据中心 , 而是一套能撑住下一代AI扩张的完整生态 。

放眼全行业 , 这是一场没有硝烟的军备竞赛 。

谷歌用液浸式冷却守住TPU , 亚马逊靠Graviton和Trainium争夺市场 , Meta在GPU堆砌上不惜血本 。

微软选择的切口 , 是在「热」这个大家都头疼的问题上先行一步 , 把优势转化为战略筹码 。

所以 , 当我们在前端用AI聊天、画画、开会时 , 其实背后是巨头们在拼命加码基础设施 。

微软这次的微流体冷却 , 并不是终点 , 而是它为未来抢跑的一次「降温起跑」 。

AI的未来 , 是一场与「热」的赛跑 。

模型越大 , 芯片越热 , 能耗越惊人 。

微软这次把冷却液送进芯片体内 , 不只是解决眼前的散热难题 , 更是在给整个行业探路:如果热量能被驯服 , 算力的天花板就能再抬高一层 。

从实验室到数据中心 , 从资本开支到自研芯片 , 微软已经把「冷静」写进了自己的基础设施战略 。

因为它很清楚——谁先跨过热的瓶颈 , 谁就更可能主宰下一阶段的算力格局 。

当AI越来越「发烧」 , 能让它冷静下来的 , 或许正是下一轮竞赛的分水岭 。

参考资料:

https://x.com/satyanadella/status/1970505474601820212

https://news.microsoft.com/source/features/innovation/microfluidics-liquid-cooling-ai-chips/

https://www.bloomberg.com/news/articles/2025-09-23/microsoft-msft-is-turning-to-the-field-of-microfluidics-to-cool-down-ai-chips?srnd=phx-technology

本文来自微信公众号“新智元” , 作者:新智元 , 编辑:倾倾 , 36氪经授权发布 。

推荐阅读

- 一年4次迭代,狂堆GPU成真!微软AI冷液灌芯,散热暴涨3倍

- ?一年卖出 10 个亿,这是年轻人真正的「户外神器」

- AI芯片独角兽一年估值翻番,放话“三年超英伟达”,最新融资53亿超预期

- 拿下超4亿融资,一年营收增长10倍!英伟达投了这家AI代码审查创企

- 量产半年即迭代,海信RGB-Mini LED直面全球竞争

- 对话联想德国业务负责人:一年月200亿营收背后的生意经

- 微信客服回应账号回收政策:超一年未登录账号将被清空所有数据

- 4.7英寸的小屏手机,蓝狐提前一年开启预热

- 一年就放弃!库克在iPhone16上,“创新”了一个最无用的功能?

- 产品力炸裂?红米Note15Pro+详细汇总,缝缝补补又是一年