文章图片

文章图片

文章图片

机器之心报道

机器之心编辑部

超节点架构重新定义大规模有效算力新范式 。

AI 算力正在迎来全新形态 , 革新的原点来自国内 。

在算力需求呈指数级增长的今天 , AI 基础设施的规模竞赛似乎陷入了一个怪圈:随着集群规模扩大 , 传统通过「服务器堆叠和以太网联接」的模式 , 会因服务器间带宽不足、时延大等问题 , 导致有效算力利用率反而越低 , 训练中断也愈发频繁 。

在昨天的华为全联接大会 2025 上 , 华为给出了自己的解法:基于自研的灵衢(UnifiedBus)互联协议 , 创新了超节点架构 。

这并非又一个单纯的硬件升级 , 而是华为在计算系统架构层的一次深度重构 。

要实现超节点架构 , 最难、也最关键的是突破互联瓶颈 。

在传统服务器架构中 , 我们可以将其理解为一个由无数独立「计算岛屿」(服务器)组成的群岛 , 岛屿之间依靠传统的网络「航线」(如以太网 / IB 网络)进行数据交换 。

在集群规模较小时 , 这种模式尚能应付;但当成千上万个计算单元需要为同一个庞大的训练任务进行高频、海量的数据同步时 , 这些「航线」就会迅速拥堵 。

其结果是 , 大量的计算单元不是在计算 , 而是在「等待」数据 。 节点间的通信延迟和带宽限制成为了整个集群的木桶短板 , 导致「1+12」的规模效应递减 , 算力利用率随规模扩大而下降 。 在万亿模型训练中 , 约有 40% 的时间 , 计算在空等通信 。

更致命的是 , 任何一个节点的故障都可能引发连锁反应 , 导致动辄耗时数周的训练任务中断 , 造成巨大的资源浪费 。 可以说 , 互联架构的能力 , 直接决定了 AI 集群规模的天花板 。

华为希望以超节点创新的形式 , 改变传统集群「堆叠」模式 , 解决当前大规模 AI 计算最核心的痛点:通信墙 。

互联技术的研发难度极大 , 正如业界关注的 NVL144 的上市时间已推迟到明年下半年 , 而华为的独特之处在于 , 基于灵衢互联 , 已经成功实现了超大规模的超节点部署 , 验证了该技术路线的成熟与领先 。

从「堆叠」到「融合」 , 深度互联推动 AI Scaling Up

「超节点」架构的核心思想 , 在于「融合」 。 超节点在物理上由多台机器组成 , 但逻辑和使用上可以看做是单一设备 。 它通过大带宽、低时延的互联网络 , 将计算单元、存储单元等组件平等互联 , 并统一通信协议与内存编址 , 实现全局资源池化 , 从根本上解决了传统集群的通信墙问题 。

基于这样的架构 , 能够将通信时延降低到百纳秒级 , 大幅提升集群利用率 , 降低通信成本 。 其最终目标是让有效算力随集群规模实现真正的线性拓展 , 并大幅提升系统的长效可靠性 。

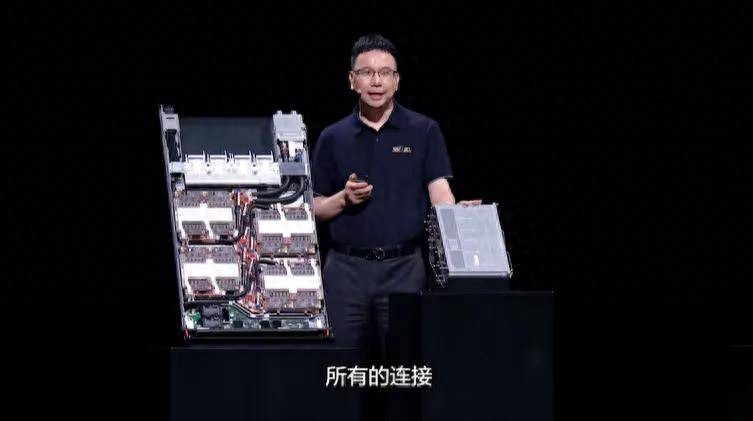

华为董事、ICT BG CEO 杨超斌在昨天的华为全联接大会上表示:「基于灵衢互联协议 , 华为创新了超节点架构 , 可将多台物理机器深度互联 , 实现逻辑层面像一台机器一样学习、思考与推理 , 重新定义了高效、稳定、可扩展的大规模有效算力新范式 。 」

华为董事、ICT BG CEO 杨超斌在华为全联接大会上 。

覆盖全场景的创新产品组合

随着 AI 基础建设的快速演进 , 超节点或许会很快成为 AI 基础设施的新常态 。

而超节点不仅仅应用于 AI 数据中心 , 更需要普惠千行万业的 AI 计算需求 。 为此 , 基于超节点架构 , 华为打造出满足大型数据中心、企业级数据中心到小型工作站等全场景算力需求的创新产品 。

旗舰标杆:Atlas 950 SuperPoD本次大会 , 华为发布 Atlas 950 SuperPoD 和 Atlas 960 SuperPoD 超节点 , 分别支持 8192 及 15488 张昇腾卡 , 在卡规模、总算力、内存容量、互联带宽等关键指标上全面领先 。

这是给顶级玩家(如云服务商、国家级智算中心)准备的「旗舰武器」 , 其采用的全液冷和零线缆电互联的正交架构设计 , 结合液冷接头浮动盲插等技术 , 不仅解决了超高密度下的散热和互联难题 , 更通过系统性创新解决了跨柜长距离、高可靠部署这一业界难题 , 更极大地提升了系统的长期运行可靠性和机房部署适应性 。

其 FP8 算力达到 8E FLOPS , 总互联带宽高达 16PB/s , 超过今天全球互联网峰值带宽的 10 倍有余 。

其创新的「UB-Mesh」递归直连拓扑 , 最大可支持 8192 卡无收敛全互联 , 这意味着在理论上 , 集群内的任意两个 NPU 都能实现最高效的通信 , 为万亿参数级别模型的训练扫清了障碍 。

基于超节点 , 华为同时发布了全球最强超节点集群 Atlas 950 SuperCluster 和 Atlas 960 SuperCluster , 算力规模分别为超过 50 万卡和百万卡 , 成为了全球最强算力集群之一 。

华为副董事长、轮值董事长徐直军在大会演讲中强调 , 基于中国可获得的芯片制造工艺 , 华为努力打造「超节点+集群」算力解决方案 , 可以满足持续增长的算力需求 。

企业普惠:Atlas 850这或许是本次发布中最具市场穿透力的产品 。 作为业界首个企业级风冷 AI 超节点服务器 , 它首次将超节点架构带入企业级风冷数据中心 , 极大地降低了企业部署超节点架构的门槛 。

这意味着 , 大多数企业无需对现有数据中心进行复杂的液冷改造 , 在大多数单柜供电能力为 20 千瓦以内的标准风冷机房内 , 也能构建起最大 1024 卡的超节点集群 , 这对于推动大模型在更广泛行业的「后训练」和多场景推理应用意义重大 。

杨超斌发布 Atlas 850 企业级风冷服务器 。

基础计算单元:Atlas 350 标卡基于最新的昇腾 950PR 芯片 , 这款标卡不仅自身性能大幅提升(如推荐推理场景性能提升 2.5 倍) , 更关键的是 , 它通过灵衢端口实现了多卡互联与资源池化 。

这意味着 , 即便是单个服务器内的多张标卡 , 也能「攒」出一个小型的超节点 , 让更大参数的模型和更低时延的应用得以在更小的单位上运行 。 同时 , 灵活扩展、可拆可合的特性 , 也让用户能够根据自己的需求 , 灵活组装 。

通用计算场景:TaiShan 950 SuperPoD这是华为超节点战略的延伸 , 也是一个值得关注的信号 , 华为将这一架构首次应用于通用计算领域 , 推出了业界首款通算超节点 。

其百纳秒级超低时延和内存池化能力 , 将直接利好数据库、虚拟化和大数据等对延迟极其敏感的场景 , 为传统 IT 架构的性能提升开辟了新的想象空间 。

值得一提的是 , 基于 TaiShan 950 超节点打造的 GaussDB 多写架构 , 无需改造即可平滑替代大型机、小型机上的传统数据库 , 为传统 IT 架构的性能提升开辟了新的想象空间 。

以「开源开放」构建护城河

在发布一系列「肌肉感」十足的硬件产品之余 , 华为反复强调的是「硬件开放、软件开源」的生态战略 。

在 AI 时代 , 单一厂商的技术再强 , 也无法包揽所有场景的应用创新 。 真正的壁垒 , 在于生态的繁荣度 。

硬件开放:华为将 NPU 模组、刀片、主板等基础硬件向伙伴开放 , 鼓励产业界进行二次开发 , 共同丰富基于灵衢协议的产品形态 , 为不同场景提供适配的算力底座 。

软件开源:将昇腾 CANN 和操作系统灵衢组件全面开源 , 代码将陆续合入 openEuler 等开源社区 , 并确保对 PyTorch、vLLM 等主流框架的优先支持 。 通过强化开源运作 , 华为致力于使能广大开发者和合作伙伴 , 让超节点走向普惠和协同创新 , 共建繁荣的 AI 生态 。

昨天的大会上 , 华为除了发布全球最强超节点 , 公布全新昇腾 950 芯片架构之外 , 还介绍了自研算力体系的落地情况:基于灵衢的 Atlas 900 A3 超节点当前已经累计部署了 300 多套 , 服务 20 余个客户 , 行业覆盖互联网、金融、运营商、电力、制造等 。 新一代超节点已在客户真实场景中兑现了价值 。

【华为超节点:用「一台机器」的逻辑,驱动AI万卡集群】算力的未来 , 在于打破边界 。 「超节点」架构的核心使命 , 就是构建一个统一、可扩展的算力基石 , 旨在将一致的、高性能的计算体验 , 无缝贯穿到每一个数据中心、企业和工作站 。

推荐阅读

- 华为新品官宣:9月26日,正式首销

- 华为384昇腾AI云服务已上线 未来超节点规格将升到8192卡

- 华为云:做厚算力“黑土地”,成就行业AI先锋

- 华为旗舰突然“变香了”!鸿蒙OS+卫星通信,512GB大降1500元

- 国内手机排行榜更新:华为第四,OPPO第二,第一名继续遥遥领先

- 这种材料,有望在先进节点取代铜和钨

- 华为Mate80系列再次被确认:双层OLED+新一代可控自研芯片,风扇待定!

- 一加15跑分与外观双曝光:超高跑分+超窄边框,或成行业新标杆!

- 聚焦2025年Q3前八周:手机销量有涨有跌,华为OPPO凭啥“独善其身”?

- 华为逆势增长2%排名第二,小米下滑2%排第四,荣耀跌幅最大排第五