文章图片

【LeCun力荐的JEPA杀入LLM,用CV的思路训练LLM,性能鲁棒性双丰收】

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

机器之心报道

编辑:+0

LeCun 这次不是批评 LLM , 而是亲自改造 。

当前 LLM 的训练(包括预训练、微调和评估)主要依赖于在「输入空间」进行重构与生成 , 例如预测下一个词 。

而在 CV 领域 , 基于「嵌入空间」的训练目标 , 如联合嵌入预测架构(JEPA) , 已被证明远优于在输入空间操作的同类方法 。

JEPA 的核心概念最早由 Yann LeCun 及其团队提出 , 旨在通过在抽象表征空间中预测未来或缺失的特征来高效学习世界知识 。 随后 , Meta AI 团队提出了具体实现 , 包括 I-JEPA(用于图像、自监督学习、CVPR 2023)和 V-JEPA(用于视频) , 验证了 JEPA 在视觉表征学习中的有效性 。

这就启发了一个新思路:语言模型的训练 , 能否从视觉领域获得一些启发?

此前 , 由于设计上的挑战 , 适用于语言任务的 JEPA 风格模型一直未能出现 。 主要原因是 LLM 的能力主要通过其生成文本来评判 , 这是一种输入空间的操作 , 使得非重构的 JEPA 思想难以直接应用 。

为填补这一空白 , Hai Huang、Yann LeCun 及 Randall Balestriero 提出了 LLM-JEPA 。 这项工作基于 JEPA 理念 , 首次将这种高效的自监督学习架构成功地从视觉领域扩展到了 LLM 。

该工作通过将(文本、代码)等数据对视为同一概念的多种视图 , 成功地将 JEPA 目标应用于 LLM , 作为标准「文本→代码」等生成任务的有效补充 。 这既保留了 LLM 强大的生成能力 , 又引入了 JEPA 在嵌入空间学习高质量表征的优势 。

论文标题: LLM-JEPA: Large Language Models Meet Joint Embedding Predictive Architectures 论文地址:https://arxiv.org/pdf/2509.14252v1 代码:https://github.com/rbalestr-lab/llm-jepa实验证明 , LLM-JEPA 的性能显著超越了标准的 LLM 训练目标 。 该方法不仅表现出色 , 还对过拟合问题显示出强大的鲁棒性 。

这些结论在 Llama3、OpenELM、Gemma2、Olmo 等多个主流模型系列以及 NL-RX、GSM8K、Spider、Rotten Tomatoes 等多样化的数据集上均得到了有力验证 。

JEPA-LLM:提升 LLM 的推理与生成能力

LLM 简介

当代 LLM 的构建大多遵循着相同的核心原则:即通过堆叠大量的非线性运算层与跳跃连接(即 Transformer 架构)来搭建 。

尽管各模型在细节上 , 如位置嵌入、初始化方法或归一化层上可能有所不同 , 但其性能表现的主要驱动力 , 依旧是预训练阶段所使用的高质量数据集 。 在训练目标上 , 现有方法也基本趋于统一 , 即自回归 token 空间重构 。

作者首先将特定任务和数据集下所使用的典型 LLM 目标函数定义为 。 在绝大多数情况下 , 该函数具体表现为一个交叉熵损失 , 用于衡量模型预测的 token 与需要重构的真实 token 之间的差异 。

值得注意的是 , 该研究提出的 LLM-JEPA 方法并不依赖于的具体形式 , 因此具有很强的通用性 , 能够适应多种应用场景 。

在此公式中 , Classifier 负责根据上下文 token 来预测下一个 token 的 logits 。 整个计算过程通过因果自回归机制一次性完成 。 根据训练阶段或任务的不同 , 该损失函数的输入与输出也会相应变化 。

LLM-JEPA 目标函数的设计

作者以「Text」(文本)和「Code」(代码)为例 , 来说明如何处理对同一底层知识的不同「视角(view)」 。 通过这个例子 , 读者可以清晰地理解 , LLM-JEPA 目标函数能够以统一的方式处理各种不同类型的视角 。

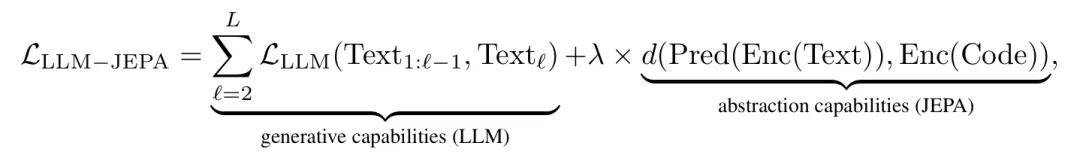

LLM-JEPA 目标函数的设计遵循两大原则:第一 , 必须保留 LLM 的生成能力 , 因此算法的起点是传统的损失 。 第二 , 旨在利用联合嵌入预测任务来增强 LLM 的抽象能力 。

基于此 , 研究团队在之上 , 引入了成熟的 JEPA 目标 , 构建了如下的完整损失函数 L:

其中 , λ≥0 是一个用于平衡两项损失权重的超参数;Pred 和 Enc 分别代表预测器和编码器网络;d 则是一个可选择的度量函数 , 例如 ?2 距离 。 下面将对各个组件进行详细说明 。

编码器: 编码器的实现方式沿用了 LLM 探查中的常见做法 , 即取模型最后一层最后一个 token 的 hidden_state 作为输入序列的嵌入向量 。 在实践中 , 研究团队指出 , 无法通过单次前向传播同时产出 Enc(Text) 和 Enc(Code) 。 一种看似高效的做法是将 [TextCode

拼接后输入 , 但这需要修改自注意力机制以避免跨视角信息泄露 , 从而导致方案与特定 LLM 架构绑定 。 为此 , 研究团队提出通过两次独立的前向传播来分别获取 Text 和 Code 的编码 。 这种方式虽然增加了训练成本 , 但并不影响推理效率 。

度量: 在嵌入向量的比较方面 , CV 领域已广泛采用余弦相似度 。 因此 , 该研究建议在 LLM-JEPA 中也采用相同的度量方式 。

预测: 该设计巧妙地利用了 LLM 的自回归特性和内部的自注意力机制 , 构建了一个权重绑定预测器 。 具体来说 , 通过在输入序列末尾添加一个特殊的 [PRED

token, 模型可以对输入信息进行进一步的非线性处理 , 并将最后一层 [PRED

token 对应的最终嵌入作为预测结果 。 由于预测任务复用了 LLM 的内部权重 , 这种设计极大地减少了额外的训练开销和架构设计的复杂性 。 实践中 , 通过在输入提示后附加 k 个预测器 token, 并取最后一个 token 的嵌入作为最终预测 。 当 k=0 时 , 预测器退化为恒等函数 , 即 。

与先前工作的关系: 研究表明 , 类似这样的输入空间重构损失(token 可视为原始文本的无损压缩)在视觉领域并非最优 。 受此启发 , 一些研究开始为 LLM 引入嵌入空间正则化器 。 然而 , 现有方案大多依赖对嵌入空间施加复杂的结构性约束(如层次结构、聚类等) , 这与 JEPA 的理念不同 。 作者同时指出 , 将(文本问题、代码差异)这类数据对视为不同「视角」并加以利用 , 在 LLM 微调中已有应用 , 但它们通常通过生成式任务(从一个视角生成另一个)来学习 , 并未采用 JEPA 风格的损失函数 。

实证验证:LLM-JEPA 性能优于传统 LLM

传统损失无法隐式优化 LJEPA 目标研究团队首先观察到一个关键现象(如图 4 所示):仅仅最小化传统的损失 , 并不会隐式地优化损失 。 这一发现直接说明了在训练中显式地加入损失项的必要性 。

LLM-JEPA 能够提升微调效果研究团队在多个主流预训练 LLM(包括 Llama-3.2-1B-Instruct、gemma-2-2b-it 等)及多种数据集(如 NL-RX-SYNTH、GSM8K 等)上展开了全面的微调实验 。

实验流程是 , 首先为每个(模型、数据集)组合搜索出最优学习率 , 然后在此基础上 , 通过网格搜索确定 LLM-JEPA 的两个关键超参数 k 和 λ 的最佳组合 。 评估指标根据任务特性而定 , 例如在 NL-RX 数据集上采用精确匹配准确率 。

实验结果(图 1 左)清晰地表明 , LLM-JEPA 能够在不同模型、不同数据集、不同训练时长和不同模型尺寸下全面提升性能 。

如表 3 所示 , 即使在不同的 LoRA 秩配置下 , LLM-JEPA 的性能优势依然稳固 。

此外 , 研究还提供了证据(图 6、7、10) , 证明 LLM-JEPA 能够学习到从 Text 编码到 Code 编码之间的一个近似线性变换 。

LLM-JEPA 同样能改进预训练过程为了验证其在预训练阶段的有效性 , 研究团队在一个数据集上从零开始训练 Llama-3.2-1B-Instruct 。 结果如表 1 所示 , 采用 LLM-JEPA 的模型在学习表示的质量上显著优于传统方法 。

在另一项对释义数据集的预训练实验中 , 使用 JEPA 预训练过的模型 , 在下游情感分类任务上进行微调时 , 也表现出更强的性能(表 4) 。 这证明了 JEPA 在预训练阶段带来的益处可以迁移到下游任务 。

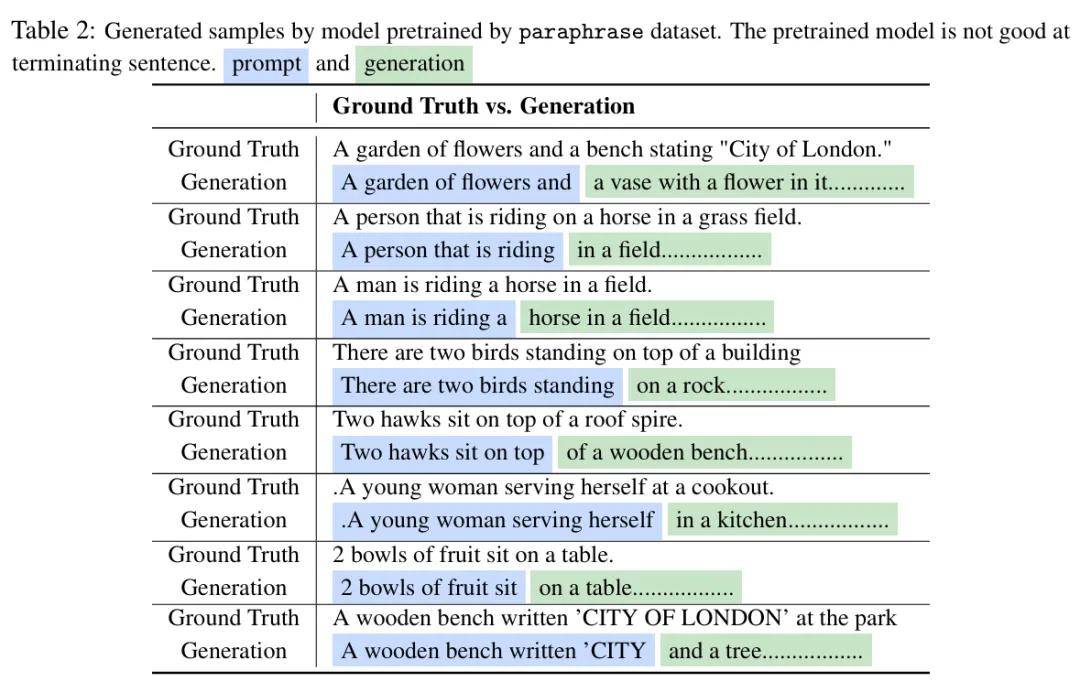

最后 , 表 2 的生成样本表明 , 经过 JEPA 预训练后 , 模型在遵循提示进行文本生成时 , 其原有的生成能力并未受到损害 。

研究团队表示 , 尽管当前实验主要聚焦于微调阶段 , 但初步的预训练结果同样展现了巨大潜力 , 研究团队计划在未来工作中对其进行更大规模、更全面的测试 。

关于该方法的局限性 , 当前最主要的瓶颈是训练过程中为获取多视角表示而导致的三倍计算开销 。

未来 , 研究团队计划探索通过掩码自注意力矩阵等方式 , 实现在单次前向传播中完成 LLM-JEPA 损失的计算 , 以降低训练成本 。

不过也有人指出 , 该方法因严重依赖「配对数据」而导致其泛化性不足 , 再加上高昂的训练成本 , 使其缺乏实际应用价值 。

对此你怎么看?

更多细节请参见原论文 。

推荐阅读

- iPhone17标准版挤爆牙膏!网友:是被华为三折叠逼的?

- 荣耀Magic 8 mini曝光:7K大电池+潜望长焦,小屏旗舰的最优解?

- 40年前的全球首个致命软件Bug:至少三人因100倍强辐射身亡

- 风口上的机器人,其实离“上班”还有点远

- 第四代 WOLED 显示器:从亮度到色彩的全面革新,玩家的终极归宿

- 智能世界的互联基座:一亿终端之后,星闪跨过银河

- 荣耀目前“价格跳水”的一款旗舰手机,从4999跌至3824,价格亲民

- 华为史上续航最长的智能手表来了,华为WATCH GT 6系列即将亮相

- 7000mAh+120w,采用矩阵Deco,一加旗舰新机的外观终于改了

- 从信号到续航的多维度升级 OPPO K13x到手价799元起