文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

大模型需要什么?

在硅谷举行的科技盛会Hot Chips 2025首日的主题演讲上 , 谷歌DeepMind的Noam Shazeer回答了这一问题 , 发表了题为《下一阶段AI的预测》的主题演讲 。

除了是Transformer论文《Attention Is All You Need》的作者之一 , 他还推动了许多技术创新 , 例如显著提升谷歌搜索中的拼写校正功能 。

早在2017年 , 他就发明了Transformer模型 , 至今已深耕LLM领域十年 。

后来 , 他开发了一款聊天机器人 , 但谷歌拒绝发布这项成果 , 这也促使他选择离职 , 创办了Character.AI 。

不久之后 , 谷歌意识到自身短板 , 最终以27亿美元的高价与Character.AI达成合作 。

如今 , Noam已回归谷歌 , 担任Gemini项目的联合负责人 。

正如他所展示的 , 大语言模型可以借助硬件等各方面资源的提升 , 不断改善性能与准确性 。

AI下一阶段

算力 , 算力 , 还是算力

Noam Shazeer主要分享了LLM的需求、个人的LLM研究之路以及硬件与LLM的关系 。

他强调几点关键内容 。

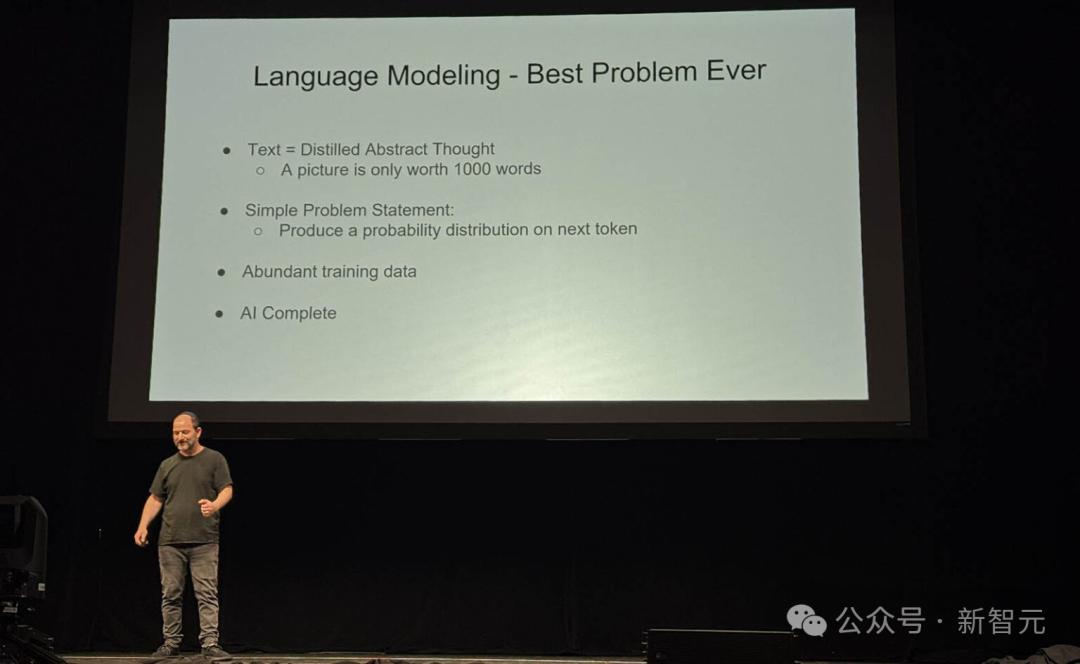

首先 , Noam认为语言建模是当前最重要的研究领域 。

他在演讲中用一张幻灯片专门阐释了这一点 , 可见他对该话题热情之高 。

然后他谈到了「LLM到底需要什么」(What LLMs want) 。

他更关注的是:更多的FLOPS意味着更好的性能 。

这非常重要 , 因为随着参数的增加、深度的增加、非线性以及信息流的增加 , LLM的规模也随之增加 。

这可能需要更多的计算资源 。 更多的优质训练数据也有助于创建更好的LLM 。

他还谈到了2015年时 , 在32个GPU上训练是一件大事;但十年后 , 可能需要数十万个GPU 。

另一个有趣的小细节是 , 他说在2018年 , 谷歌为AI构建了计算节点 。

这是一件大事 , 因为在此之前 , 谷歌工程师通常在一千个CPU上运行工作负载 。 但随后它们会变慢 , 另作他用 , 比如爬取网络 。

拥有专门用于深度学习/ AI工作负载的大型机器 , 使得性能有了巨大的提升 。

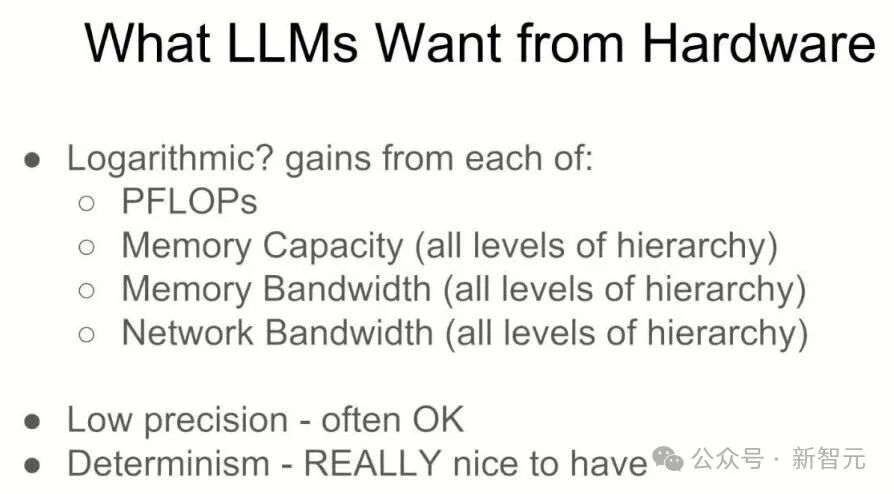

接着是芯片会议上的一大亮点 , 即LLM对硬件的需求 。

从这张幻灯片中 , 可以看到一个有趣的观点

更多的计算能力、内存容量、内存带宽和更多的网络带宽 , 对于推动未来AI模型的进步都至关重要 。

在「所有层级」上 , 这不仅仅是DDR5的容量和带宽 , 还包括HBM和芯片上的SRAM 。

降低精度以帮助更好地利用这四个方面 , 在很多情况下也被视为好事 。

确定性有助于更好地编程 。

演讲的信息归结为:在集群中拥有更大、更快的设备将导致LLM的增益 。

这对谷歌和其他一些公司来说可能是个好消息 。

大模型要什么硬件?

Noam是典型的「反向跨界者」:作为AI研究者 , 他对硬件充满好奇 , 总想知道这些机器如何运作 。

在Mesh-TensorFlow项目中 , 他对TPU的底层网络结构产生了极大兴趣 。

论文链接:https://arxiv.org/abs/1811.02084

他提出了很多让人耳目一新的问题:

你们的芯片居然是环形网络结构?

那数据包在里面怎么跑?

怎么映射到神经网络的张量计算里?

这种好奇心最终促成了谷歌在软硬件协同设计上的诸多突破 。

在这次演讲中 , Noam Shazeer深入剖析了LLM到底需要什么硬件 。

AI需要的硬件支持:不止GPU

毫无疑问 , 算力是LLM最需要的因素 。

当大家说「LLM想要什么」时 , 实际上也是在问:

为了让AI更聪明 , 我们的硬件系统需要如何变化?

Noam的答案清晰直接:越多越好 , 越大越好 。

1. 更多算力(More FLOPs)

算力越多越好 , 最好是数以千万亿次的浮点运算能力(petaflops) 。 它直接决定你能训练多大的模型 , 用多大的batch , 覆盖多少训练数据 。

2. 更大内存容量&更高内存带宽

Noam指出 , 内存带宽如果不足 , 会限制模型结构的灵活性 , 比如不能轻易加非线性层 。 而更高的带宽=更细粒度的控制 。

内存包括:片上存储(on-chip SRAM)、高带宽内存(HBM)、显存或DRAM等其他中高速缓存

内存容量方面 , 直接决定了:

能塞下多大的模型;

在推理时 , 能保留多少中间状态(比如长上下文、缓存、注意力头等) 。

3. 网络带宽(Network Bandwidth)

这个是很多人忽视但至关重要的一项 。

因为无论是训练还是推理 , LLM几乎一定会:模型被分到多个芯片 , 数据在它们之间来回传递 。

举个例子 , 大家现在都在追求「长思维链」(long chain of thought) , 也就是说模型要花更长的时间「思考」才能得出更强的答案 。

可这也意味着每一步推理要更快完成 , 否则响应就变慢了 。

这时候 , 瓶颈往往就在于你是否能迅速访问完所有模型参数——

不只是芯片上的那一份 , 而是分布在一整块计算网格中的所有部分 。

因此 , Noam总结说:

想推理得快 , 核心问题就是——你这一群芯片 ,总共能提供多少内存带宽?

AI加速发展 , 人类路在何方?

他补充了一些其他对硬件设计的「愿望清单」 。

1. 低精度(Low Precision)

在传统科学计算中 , 精度至关重要 。

但在LLM中 , 模型本身就具有一定「模糊性」 , 低位数往往影响不大 。

因此 , 低精度换算力完全合理 , 能用8-bit、甚至4-bit来换更多FLOPs , 值得如此做 。

行业确实在尝试越来越低的精度格式(FP8、INT4、二进制等)——只要能保持收敛 , 越低越好 。

当然 , 不能牺牲可重复性 。

核心挑战是「训练时精度够用」「推理时误差够小」 。

2. 可复现性(Determinism)

Noam认为这是关键 , 因为机器学习实验的失败率本就很高 。

很多时候你都不知道 , 某个结果失败 , 是因为模型结构不对 , 数据有问题 , 还是你代码里有bug 。

如果每次训练都跑出不同结果 , 那连「调试」都无从下手 。

他回忆早期在Google Brain做异步训练的时候 , 经常出现「这次跑通了 , 下次又崩了」的情况 , 工程体验极差 。

所以 , 他给硬件设计者的建议是:

除非你能给我10倍性能 , 否则请不要牺牲可重复性 。

3. 运算溢出与精度损失问题

有现场观众提问:低精度运算经常会溢出或出现不稳定 , 怎么处理?

Noam回答:

确保accumulator(累加器)使用更高精度;

或者进行裁剪(clipping) , 不要让数值爆掉;

最差的方案是「数值回绕」(wrap around) 。

主持人Cliff补充了一句俏皮话:

我们要的是 , 加载checkpoint后 , 机器要按原样崩掉 ——

这才算真正的可重复性 。

Waymo工程师提出的一个刁钻问题:如果今天起硬件就不再进步 , 我们还能搞出通用人工智能(AGI)吗?

Noam给出意外但坚定的回答:可以 。

【27亿美元天价回归!谷歌最贵叛徒、Transformer作者揭秘AGI下一步】他指出 , AI会加速自身发展 , 推动软件、系统设计持续进化 , 即使硬件原地不动 , 我们也能靠软件层面的革新继续进步 。

当然——他话锋一转:不过如果你能继续搞出更好的硬件 , 自然更好 。

如果AGI真的到来 , 人类又该何去何从?

AI是拯救还是终结人类?

在算力和数据的驱动下 , AI不断向更复杂的领域进发 。

「只要投喂足够的数据和算力 , 就有可能学习并揭示宇宙的内在结构 。 」

在最近的访谈中 , 微软AI的CEO Mustafa Suleyman如此说 。

他指出 , 当前的LLM(大语言模型)还只是「单步预测引擎」 , 尚处于AI发展的早期阶段 。

但随着持久记忆和长期预测能力的加入 , LLM将有望发展为具备完整规划能力的「行动型AI」:

不仅能像人类一样制定复杂计划 , 还能持续执行任务 。

这一飞跃可能在2026年底前实现 。

Suleyman用「breathtaking」(惊艳)来形容这一未来 , 并强调 , 我们还只是刚刚起步 , 一切都将很快发生深刻变化 。

25岁豪赌未来AI , 如今预测AI失业潮

时间回到2010年 , 智能手机才刚刚普及、应用商店尚在萌芽 , AI更像是科幻小说的陈词滥调 , 而非严肃的科学课题 , 即使是顶尖学者也对此不屑一顾 。

当时年仅25岁的Mustafa Suleyman与两位「勇敢而有远见的」联合创始人Demis Hassabis和Shane Legg , 却笃信一个革命性的理念:

如果能创造出真正理解人类的智能 , 那将是改善人类状况的最佳机会 。

Suleyman尖锐地指出 , 历史上充满了带来「净伤害」的发明 。

因此 , 在AI这项「有史以来最强大的通用技术」面前 , 从价值观出发 , 将人类福祉置于首位 , 不是一句空洞的口号 , 而是一个必须时刻坚守的起点 。

但Suleyman直言 , 在未来20年内 , 将面临大规模的失业潮 。

今天许多白领从事的「认知上的体力劳动」 , 如数据录入、邮件处理等 , 将被AI高效替代 。

他直言 , 这些恐惧「非常真实」 , 并强调政府必须强力介入 , 通过税收等再分配机制来缓冲这一社会巨变 。

在此基础上 , 他提出了自己著作《即将到来的浪潮》中的核心概念——「遏制困境」(The Containment Problem) 。

他指出 , 技术的趋势是让权力被小型化、集中化 , 并以极低的成本普及给每个人 。

当AI成为一个可以代表你打电话、写代码、执行计划的智能体时 , 每个人执行自己想法的成本和时间都将趋近于零 。

这将带来巨大的创造力爆发 , 但同时也埋下了冲突的种子 。

「如果我能点击一个按钮执行我疯狂的想法 , 你也能 , 那将引起大量的冲突 。 」

「摩擦对于维持和平与稳定很重要 , 」Suleyman一针见血地指出 。 当执行一件事情的阻力(摩擦)消失时 , 混乱就可能接踵而至 。

如何「遏制」这种以零边际成本扩散的力量 , 是我们时代最严峻的考验 。

何时应该「拔掉电源」

在所有对AI的担忧中 , 最令人恐惧的莫过于「失控」 。

对此 , Suleyman明确划出了四条不可逾越的红线 。

一旦一个AI同时具备以下能力 , 它将成为一个需要「军事级别干预」才能阻止的系统:

- 递归式自我改进(能修改自己的核心代码)

- 自主设定目标

- 获取自身资源

- 在世界上自主行动

答案是肯定的 , 因为AI存在于物理的数据中心里 。

但真正的挑战在于 , 我们如何识别那个时刻的到来 , 以及如何集体做出关停的决定 。

重新定义「你的饭碗」

对于AI引发的失业恐慌 , Suleyman提供了一个更为乌托邦的视角 。

他引用瑞典的理念——「我们不关心工作岗位 , 我们关心工人」 , 并将其推向极致 。

他认为 , 社会的任务不应是为人们创造「饭碗」 , 而是创造一个和平、支持性的环境 , 让人们找到自己的激情 , 过上充实的生活 。

「我梦想一个人们可以自己选择做什么并拥有真正自由的世界 。 」

他相信 , 如果技术应用得当 , 产生的巨大价值足以让社会资助人们去追求这些真正有意义的事情 。

这将释放巨大的创造力 , 但也会带来深刻的存在主义问题:「我是谁?我为什么在这里?」

参考资料:

https://youtu.be/v0beJQZQIGA

https://youtu.be/tQ5wO1lznCQ

https://www.servethehome.com/thank-you-for-the-supercomputers-google-predictions-for-the-next-phase-of-ai-at-hot-chips-2025/

推荐阅读

- 英特尔将会为NVIDIA打造X86 CPU:不用自家工艺,进军百亿美元市场

- 又来一单?甲骨文、Meta商谈200亿美元云计算协议

- 英伟达斥资超9亿美元,吸纳了Enfabrica的人才和技术

- NVIDIA宣布投给英特尔50亿美元:双英联合开发PC芯片

- 英伟达50亿美元下赌注,给CPU和GPU「修高速」

- 微软签署62亿美元挪威AI基建协议

- 人形机器人公司Figure AI融资10亿美元,加速AI数据收集与生产

- 华为Mate80系列定档11月:星环回归+麒麟9030,直屏版本终于香了

- 390亿美元,全球具身智能第一估值来了,英伟达持续加注中

- Nothing完成2亿美元C轮融资,估值达13亿美元|最前线