文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

物理学正在走向人工智能——

Meta开源发布V-JEPA 2世界模型:一个能像人类一样理解物理世界的AI模型 。

图灵奖得主、Meta首席AI科学家Yann LeCun亲自出镜宣传 , 并称:

我们相信世界模型将为机器人技术带来一个新时代 , 使现实世界中的AI智能体能够在不需要大量机器人训练数据的情况下帮助完成家务和体力任务 。

那什么是世界模型呢?

简单说 , 就是能够对真实物理世界做出反应的AI模型 。

它应该具备以下几种能力:

理解:世界模型应该能够理解世界的观察 , 包括识别视频中物体、动作和运动等事物 。

预测:一个世界模型应该能够预测世界将如何演变 , 以及如果智能体采取行动 , 世界将如何变化 。

规划:基于预测能力 , 世界模型应能用于规划实现给定目标的行动序列 。

V-JEPA 2(Meta Video Joint Embedding Predictive Architecture 2 )是首个基于视频训练的世界模型(视频是关于世界信息丰富且易于获取的来源) 。

它提升了动作预测和物理世界建模能力 , 能够用于在新环境中进行零样本规划和机器人控制 。

V-JEPA 2一发布就引起了一片好评 , 甚至有网友表示:这是机器人领域的革命性突破!

62小时训练即可生成规划控制模型V-JEPA 2采用自监督学习框架 , 利用超过100万小时的互联网视频和图像数据进行预训练 , 不依赖语言监督 , 证明纯视觉自监督学习可以达到顶尖表现 。

上图清晰地展示了如何从大规模视频数据预训练到多样化下游任务的全过程:

输入数据:利用100万小时互联网视频和100万图片进行预训练 。

训练过程:使用视觉掩码去噪目标进行视频预训练 。

下游应用分为三类:

理解与预测:行为分类、物体识别、行为预测;

语言对齐:通过与LLM对齐实现视频问答能力;

规划:通过后训练行动条件模型(V-JEPA 2-AC)实现机器人操作 。

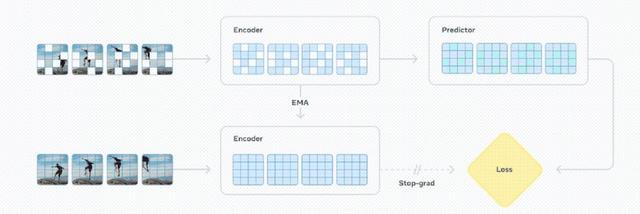

V-JEPA 2采用联合嵌入预测架构(JEPA) , 主要包含两个组件:编码器和预测器 。

编码器接收原始视频并输出能够捕捉有关观察世界状态的语义信息的嵌入 。

预测器接收视频嵌入以及关于要预测的额外上下文 , 并输出预测的嵌入 。

研究团队用视频进行自监督学习来训练V-JEPA 2 , 这就能够在无需额外人工标注的情况下进行视频训练 。

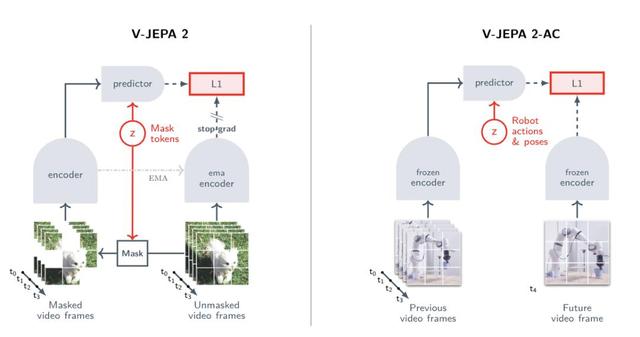

V-JEPA 2的训练涉及两个阶段:先是无动作预训练(下图左侧) , 然后是额外的动作条件训练(下图右侧) 。

经过训练后 , V-JEPA 2在运动理解方面取得了优异性能(在Something-Something v2上达到77.3的 top-1准确率) , 并在人类动作预测方面达到了当前最佳水平(在Epic-Kitchens-100上达到39.7的recall-at-5) , 超越了以往的任务特定模型 。

此外 , 在将V-JEPA 2与大型语言模型对齐后 , 团队在8B参数规模下多个视频问答任务中展示了当前最佳性能(例如 , 在PerceptionTest上达到84.0 , 在TempCompass上达到76.9) 。

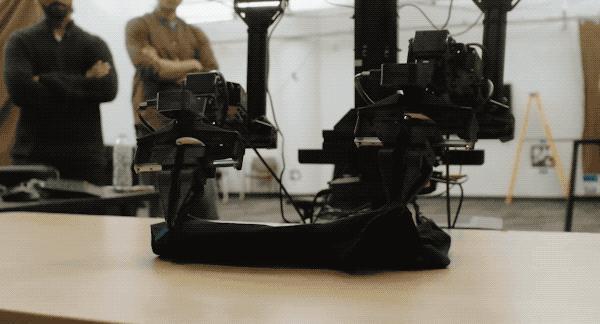

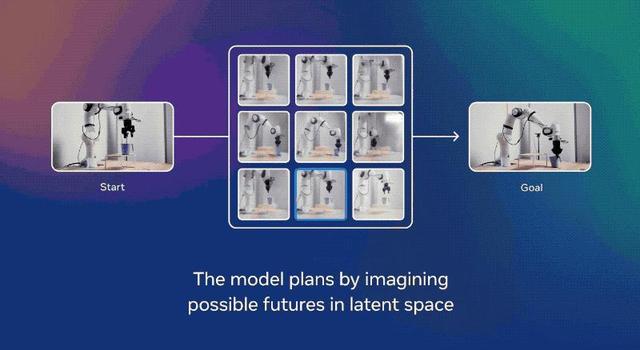

对于短期任务 , 例如拾取或放置物体 , 团队以图像的形式指定目标 。

使用V-JEPA 2编码器获取当前状态和目标状态的嵌入 。

从其观察到的当前状态开始 , 机器人通过使用预测器来想象采取一系列候选动作的后果 , 并根据它们接近目标的速度对候选动作进行评分 。

在每个时间步 , 机器人通过模型预测控制重新规划并执行朝向该目标的最高评分的下一个动作 。

对于更长期的任务 , 例如拾取物体并将其放置在正确的位置 , 指定一系列机器人试图按顺序实现的视觉子目标 , 类似于人类观察到的视觉模仿学习 。

通过这些视觉子目标 , V-JEPA 2在新的和未见过的环境中拾取并放置新物体时 , 成功率达到65%–80% 。

物理理解新基准Meta还发布了三个新的基准测试 , 用于评估现有模型从视频中理解和推理物理世界的能力 。

虽然人类在所有三个基准测试中表现良好(准确率85%–95%) , 但人类表现与包括V-JEPA 2在内的顶级模型之间存在明显差距 , 这表明模型需要改进的重要方向 。

IntPhys 2是专门设计用来衡量模型区分物理上可能和不可能场景的能力 , 并在早期的IntPhys基准测试基础上进行构建和扩展 。

团队通过一个游戏引擎生成视频对 , 其中两个视频在某个点之前完全相同 , 然后其中一个视频发生物理破坏事件 。

模型必须识别出哪个视频发生了物理破坏事件 。

虽然人类在这一任务上在多种场景和条件下几乎达到完美准确率 , 但当前的视频模型处于或接近随机水平 。

Minimal Video Pairs (MVPBench)通过多项选择题测量视频语言模型的物理理解能力 。

旨在减轻视频语言模型中常见的捷径解决方案 , 例如依赖表面视觉或文本线索以及偏见 。

MVPBench中的每个示例都有一个最小变化对:一个视觉上相似的视频 , 以及相同的问题但答案相反 。

为了获得一个示例的分数 , 模型必须正确回答其最小变化对 。

CausalVQA测量视频语言模型回答与物理因果关系相关问题的能力 。

该基准旨在专注于物理世界视频中的因果关系理解 , 包括反事实(如果……会发生什么)、预期(接下来可能发生什么)和计划(为了实现目标下一步应该采取什么行动)相关的问题 。

虽然大型多模态模型在回答视频中“发生了什么”的问题方面能力越来越强 , 但在回答“可能发生了什么”和“接下来可能发生什么”的问题时仍然存在困难 。

这表明在给定行动和事件空间的情况下 , 预测物理世界可能如何演变方面 , 与人类表现存在巨大差距 。

One More ThingMeta还透露了公司在通往高级机器智能之路上的下一步计划 。

目前 , V-JEPA 2只能在单一时间尺度上学习和进行预测 。

然而 , 许多任务需要跨多个时间尺度的规划 。

所以一个重要的方向是发展专注于训练能够在多个时间和空间尺度上学习、推理和规划的分层次JEPA模型 。

【LeCun世界模型出2代了,62小时搞定机器人训练,开启物理推理新时代】另一个重要的方向是多模态JEPA模型 , 这些模型能够使用多种感官(包括视觉、音频和触觉)进行预测 。

项目地址:GitHub:https://github.com/facebookresearch/vjepa2Hugging Face:https://huggingface.co/collections/facebook/v-jepa-2-6841bad8413014e185b497a6

参考链接:

[1

https://ai.meta.com/blog/v-jepa-2-world-model-benchmarks/

[2

https://x.com/AIatMeta/status/1932808881627148450

[3

https://ai.meta.com/research/publications/v-jepa-2-self-supervised-video-models-enable-understanding-prediction-and-planning/

推荐阅读

- 坚持免费!夸克发布行业首个“高考志愿大模型” 还有张雪峰专栏

- 杨立昆亲自发布:Meta最强世界模型开源

- 全球每卖2台100吋就有1台是海信!Omdia揭晓世界第一统治力

- 淘宝跑步进入三维世界

- 硅谷AI圈变天,OpenAI弃微软转投谷歌,LeCun被边缘小扎组队血战复仇

- Mistral的首个强推理模型:拥抱开源,推理速度快10倍

- OpenAI发布新推理模型o3-pro,并下调o3价格

- 端侧模型向开发者开放,AI在iPhone上无处不在

- OpenAI推理大模型再度上新 o3-pro已经上线

- 字节跳动推出豆包大模型1.6和视频模型Seedance 1.0