文章图片

【7B模型搞定AI视频通话,阿里最新开源炸场,看听说写全模态打通】

文章图片

深夜重磅!阿里发布并开源首个端到端全模态大模型——通义千问Qwen2.5-Omni-7B , 来了 。 仅靠一个一体式模型 , 就能搞定文本、音频、图像、视频全模态 , 并实时生成文本和自然语音 。 堪称7B模型的全能冠军 。 你的iPhone搭载的很可能就是它!现在打开Qwen Chat , 就能直接和它实时进行视频或语音交互:

话不多说 , 先来看一波能力展示 。 在大街上同它视频通话 , 它能正确识别周围环境 , 按照你的需求为你推荐餐馆

走进厨房 , 它又化身“智能菜谱” , 一步步指导你变成大厨

在多模态任务OmniBench评测中 , Qwen2.5-Omni表现刷新记录拿下新SOTA , 远超谷歌Gemini-1.5-Pro等同类模型 。 在单模态的语音识别、翻译、音频理解、图像推理、视频理解、语音生成任务中 , Qwen2.5-Omni的全维度表现也都优于类似大小的单模态模型以及闭源模型 。 在seed-tts-eval语音生成基准中 , Qwen2.5-Omni展现出与人类水平相当的语音合成能力 。

这意味着Qwen2.5-Omni-7B能很好地和世界进行实时交互 , 甚至能轻松识别音视频情绪 。 再来敲重点:模型非常轻量 , 手机等终端都可轻松部署运行 , 且开源用的是宽松的Apache2.0协议 , 开发者、企业现在都可免费在魔搭社区或Hugging Face下载商用 。 Qwen2.5-Omni-7B一开源 , 网友直呼这才是真正的OpenAI(doge) 。

网友纷纷表示可以直接拿来装到智能眼镜上了:这可能是智能眼镜的完美模型 。

7B模型的新纪录!

目前 , 在Qwen Chat上即可体验该模型支持的AI语音和视频通话功能 。 更多实例 , 一起来看~实测效果惊艳首先 , Qwen2.5-Omni-7B能胜任免费的数学家教 。 它能像人类老师一样 , 看到题目、听懂问题 , 并且一步一步耐心讲解 。 更复杂的论文它也看得懂 。 只需共享屏幕 , 然后将论文从上至下滑动 , “给它看一遍” 。 它就能通俗解释论文内容 。 比如PPT、网页资料等 , 也能找它做讲解 。

而且它还有一定艺术见解 , 比如可以陪着你画画 , 然后给出指导建议 。

或者听你演奏的音乐 , 给出更好的改进建议 。

我们还进行了一手实测 , 在Qwen Chat上每天可使用语音和视频聊天10次 。

实测中 , 模型能很好地理解商品界面和优惠政策 。 响应速度也很快 , 并且会引导人类继续问下去、很有耐心 。 需要注意的是 , 当前视频通话还只是Beta测试版 , 每次通话限时3分钟 。

Hugging Face的产品负责人Jeff Boudier也第一时间上手试玩 。 模型的英文能力一样出众 , 而且它不仅回答看到了杯子 , 还细致描述了杯子上的笑脸花纹 。

首创Thinker-Talker双核架构目前官方已放出Qwen2.5-Omni技术Blog和论文 。 Qwen2.5-Omni采用通义团队首创的全新架构——Thinker-Talker双核架构 。 其中 , Thinker就像“大脑” , 负责处理和理解来自文本、音频、视频等多模态的输入信息 , 生成高层语义表征以及对应的文本内容 。 Talker则更像“嘴巴” , 以流式的方式接收由Thinker实时输出的语义表征与文本 , 并流畅地合成离散语音tokens 。 具体来说 , Thinker基于Transformer解码器架构 , 融合音频/图像编码器进行特征提取 。 而Talker采用双轨自回归Transformer解码器设计 , 在训练和推理过程中直接接收来自Thinker的高维表征 , 并共享Thinker的全部历史上下文信息 。 因此 , 整个架构作为一个紧密结合的单一模型运行 , 支持端到端的训练和推理 。 与此同时 , 团队还提出了一种新的位置编码算法TMRoPE(Time-aligned Multimodal RoPE)以及Position Embedding (位置嵌入)融合音视频技术 。 TMRoPE编码多模态输入的三维位置信息 , 即多模态旋转位置嵌入(M-RoPE) , 并结合绝对时间位置 , 通过将原始旋转嵌入分解为时间、高度和宽度三个部分实现 。

另外值得一提的是 , 从技术层面来看 , Qwen2.5-Omni和一般的视频/语音理解模型以及其相应的视频/语音对话的AI功能 , 也有本质性区别 。 在传统语音理解大模型的人机交互场景里 , 一般运用 ASR(Automatic Speech Recognition , 自动语音识别)技术 , 把人类语音转换为文字文本 , 随后将其交给大语言模型处理 , 最终生成的内容借助 TTS(Text-to-Speech , 语音合成)技术转化为语音反馈给用户 。 而视频理解模型是基于图片、视频进行大模型理解 , 并以文字形式输出反馈 。 这两种模型均属于相互独立的单链路模型 。 在一些AI应用中 , 甚至会串联多个模型来实现类似功能 , 如此一来 , 链路变得更长 , 效率大打折扣 。 Qwen2.5-Omni-7B的特点在于 , 它原生支持视频、图片、语音、文字等多模态输入 , 并能原生生成语音及文字等多模态输出 。 也就是说 , 一个模型就能通过“看”、“听”、“阅读”等多种方式来综合思考 。

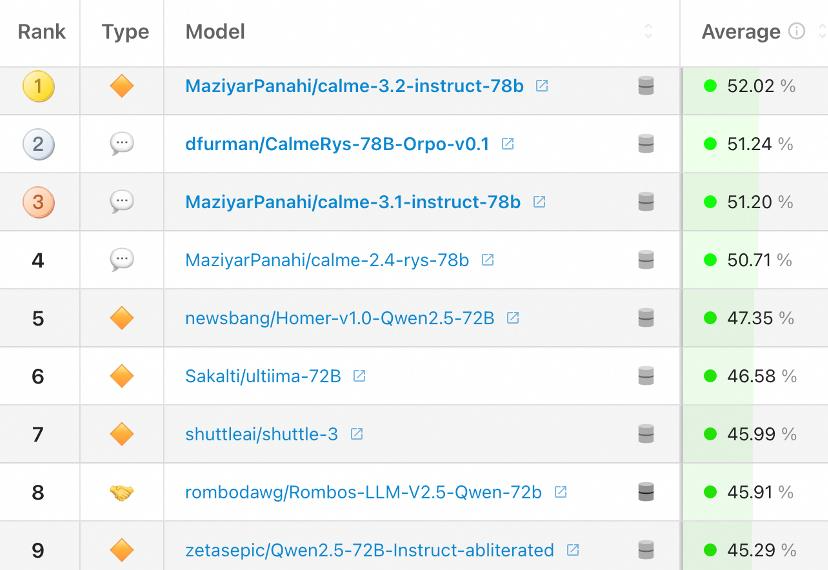

所以Qwen2.5-Omni得以在一系列同等规模的单模态模型权威基准测试中 , 拿下最强全模态性能 , 在语音理解、图片理解、视频理解、语音生成等领域的测评分数 , 均领先于专门的音频(Audio)或视觉语言(VL)模型 。 抢先看到Apple Intelligence?一个月前 , 阿里公开确认与苹果合作 , 宣布通义千问将为国行iPhone用户提供AI功能 , 此消息一经披露 , 便在科技圈引发热议 。 而这次Qwen2.5-Omni开源 , 就是奔着端侧部署来的 , 7B尺寸使其具备直接嵌入手机的可行性 , 仿佛提前看到了Apple Intelligence , 让大家看到多模态大模型上手机都能有哪些效果 。 不只是苹果 , 据量子位了解 , 这种端侧部署能力已吸引超90%国产手机品牌接入通义千问 , 包括OPPO、vivo、荣耀、传音等 , 还有众多汽车品牌、AI硬件产品选择与之携手 。 为啥都选通义千问?梳理通义千问的最新发展动态 , 答案便不难理解 。 首先 , 通义千问Qwen目前已稳居全球最大AI大模型族群 。 仅在最近一个月的时间里 , 就接连推出了一系列具有竞争力的模型:推理模型Max旗舰版QwQ-Max-Preview、视频生成模型Wan 2.1、推理模型QwQ-32B、视觉语言模型Qwen2.5-VL-32B-Instruct……实际上 , 2023年至今 , 阿里通义团队已累计开源200多款模型 , 涵盖从0.5B到110B全尺寸范围 , 模型类型覆盖文本生成、视觉理解与生成、语音理解与生成、文生图及视频模型等全模态领域 , 应用场景也极为丰富 。 在海内外开源社区中 , 通义千问Qwen衍生模型数量更是一路飙升 , 现已超过10万 , 超越Llama系列 。 根据Hugging Face 在2月10日发布的最新全球开源大模型榜单 , 排名前十的开源大模型无一例外 , 全部是基于通义千问Qwen开源模型二创的变体模型 。

其次 , 阿里巴巴通过开源等一系列积极举措 , 成功构建起一个丰富且活跃的大模型生态 。 阿里不仅将开源进行到底 , 更向大模型公司提供了全方位的服务支持 , 其中包括算力资源以及开发工具等 , 阿里云已成为中国大模型领域的公共AI算力底座 。 截至2025年2月中旬 , 阿里魔搭社区ModelScope的模型总量已超4万个 , 服务超1000万开发者 。 那么通义千问Qwen团队下一步要干啥?期待听到您的反馈 , 并看到您使用Qwen2.5-Omni开发的创新应用 。 在不久的将来 , 将着力增强模型对语音指令的遵循能力 , 并提升音视频协同理解能力 。 还将持续拓展多模态能力边界 , 发展全面的通用模型 。

推荐阅读

- iPhone 17 系列曝光:支持 8K 视频录制

- DeepSeek低调发布V3新模型

- 证件照尺寸怎么改?一篇教程带你轻松搞定

- DeepSeek逼出谷歌新推理模型:40分优势超GPT4.5登顶竞技场

- 谷歌史上最强推理模型全面屠榜!击败DeepSeek断层第一,“人类最后考试”暴碾OpenAI,免费可用

- 为YU7能6月上市?劳模雷军今晨6:00闪现武大录视频

- DeepSeek 发布 V3 模型更新:除了编程能力大幅提升,还有更宽松的开源协议

- 英媒:中国的AI大模型技术,撕下了美国用AI赚钱的最后一块遮羞布

- 李开复点名:中国AI大模型或只剩3家!DeepSeek能笑到最后?

- 腾讯混元自研「T1」正式发布,混合Mamba架构无损应用于推理模型