文章图片

文章图片

智东西

作者 | 李水青

编辑 | 云鹏

智东西9月5日消息 , 今天 , 谷歌开源一款全新的开放式嵌入模型EmbeddingGemma 。 该模型以小博大 , 拥有3.08亿个参数 , 专为端侧AI设计 , 支持在笔记本、手机等设备上部署检索增强生成(RAG)、语义搜索等应用程序 。

EmbeddingGemma的一大特征是能生成隐私性良好的高质量嵌入向量 , 即使在断网情况下也能正常运行 , 且性能直追尺寸翻倍的Qwen-Embedding-0.6B 。

Hugging Face开源页面截图

Hugging Face地址: https://huggingface.co/collections/google/embeddinggemma-68b9ae3a72a82f0562a80dc4

据谷歌介绍 , EmbeddingGemma具有以下几大亮点:

1、同类最佳:在海量文本嵌入基准(MTEB)上 , 在500M以下的开放式多语言文本嵌入模型中 , EmbeddingGemma排名最高 。 EmbeddingGemma基于Gemma 3架构打造 , 已针对100多种语言进行训练 , 并且体积小巧 , 经过量化后可在不到200MB的内存上运行 。

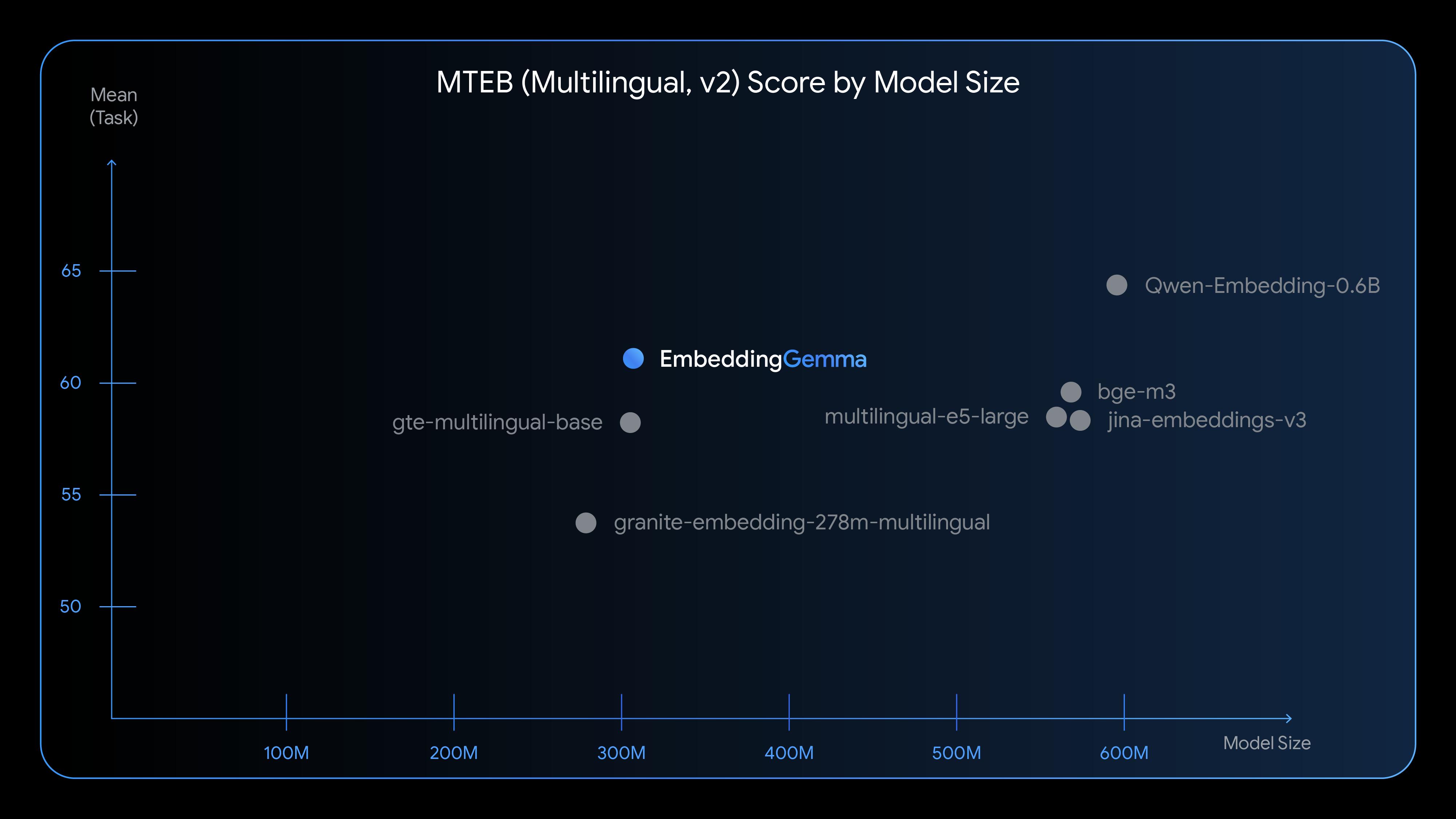

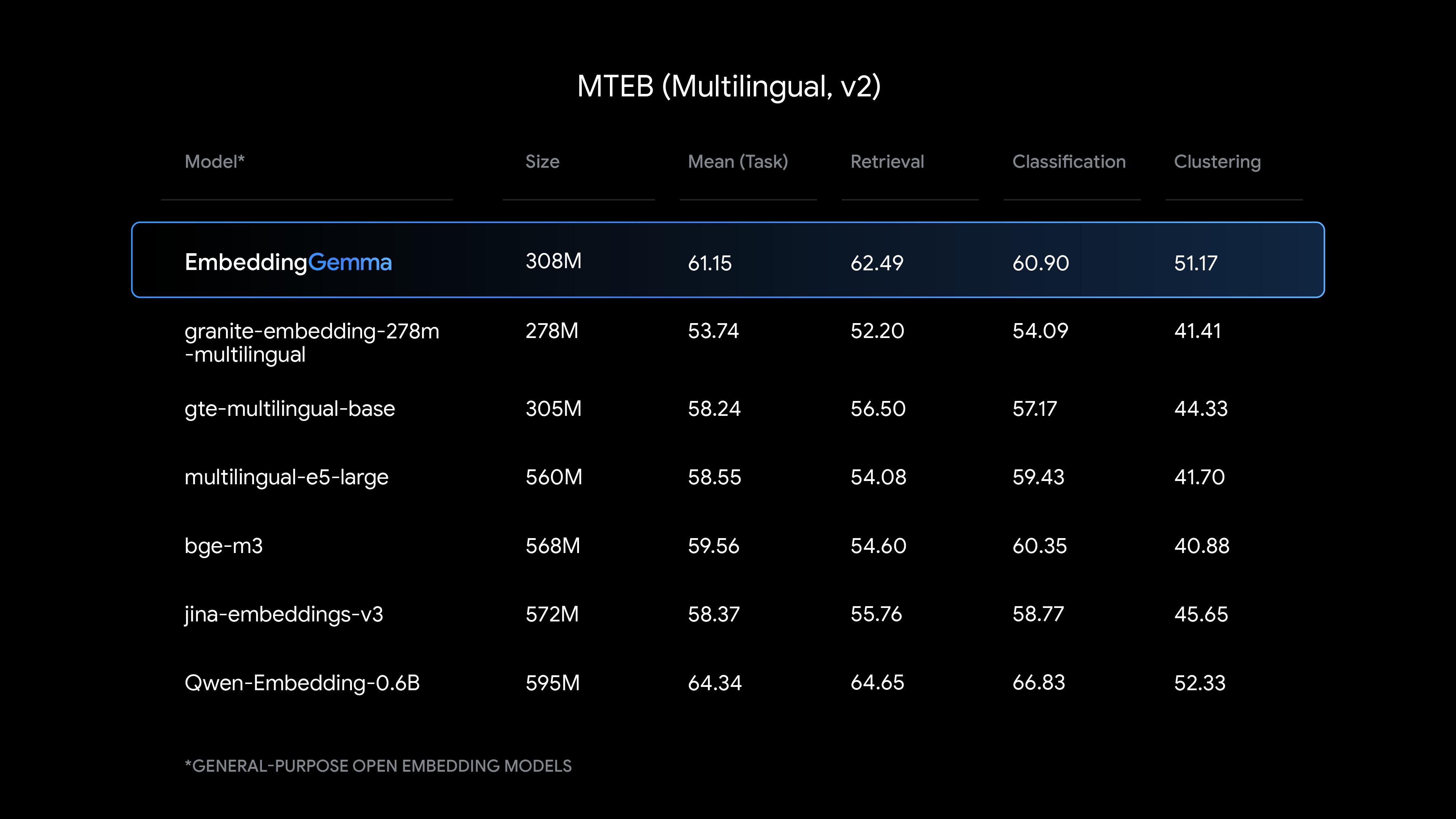

MTEB评分:EmbeddingGemma性能比肩比起尺寸大一倍的顶尖模型

2、专为灵活离线工作而设计:小巧、快速、高效 , 提供可自定义的输出尺寸 , 以及2K令牌上下文窗口 , 可在手机、笔记本电脑、台式机等日常设备上运行 。 它旨在与Gemma 3n配合使用 , 共同为移动RAG管道、语义搜索等解锁新的用例 。

【0.3B!谷歌开源新模型,手机断网也能跑,0.2GB内存就够用】3、与流行工具集成:为了让用户轻松开始使用EmbeddingGemma , 它已经可以与用户喜欢的工具一起使用 , 例如sentence-transformers、llama.cpp、MLX、Ollama、LiteRT、transformers.js、LMStudio、Weaviate、Cloudflare、LlamaIndex、LangChain等 。

一、可生成优质嵌入向量 , 端侧RAG生成答案更准确EmbeddingGemma会生成嵌入向量 , 在本文语境中 , 它能将文本转换为数值向量 , 在高维空间表征文本语义;嵌入向量质量越高 , 对语言细微差别与复杂特性的表征效果越好 。

EmbeddingGemma会生成嵌入向量

构建RAG流程存在两个关键阶段:一是根据用户输入检索相关上下文 , 二是基于该上下文生成有依据的答案 。

为实现检索功能 , 用户可以先生成提示词的嵌入向量 , 再计算该向量与系统中所有文档嵌入向量的相似度——通过这种方式 , 能够获取与用户查询最相关的文本片段 。

随后 , 用户可将这些文本片段与原始查询一同输入生成式模型(如Gemma 3) , 从而生成符合上下文的相关答案 。 例如 , 模型能理解你需要联系木工的电话 , 以解决地板损坏的问题 。

要让这个RAG流程切实有效 , 初始检索步骤的质量至关重要 。 质量不佳的嵌入向量会导致检索到不相关的文档 , 进而生成不准确或毫无意义的答案 。

而EmbeddingGemma的性能优势正体现于此——它能提供高质量的(文本)表征 , 为精准、可靠的端侧应用提供核心支持 。

二、以小博大 , 性能接近尺寸翻倍的Qwen-Embedding-0.6BEmbeddingGemma提供了与其规模相适应的最先进的文本理解能力 , 在多语言嵌入生成方面具有特别强大的性能 。

与其他流行嵌入模型的比较 , EmbeddingGemma在检索、分类和聚类等任务上表现出色 。

EmbeddingGemma在Mean(Task)、Retrieval、Classification、Clustering等测试中全面赶超了同等尺寸的gte-multilingual-base模型 。 其测试成绩也已接近尺寸达到其两倍的Qwen-Embedding-0.6B 。

EmbeddingGemma的测评情况

EmbeddingGemma模型拥有308M参数 , 主要由大约100M模型参数和200M嵌入参数组成 。

为了实现更高的灵活性 , EmbeddingGemma利用Matryoshka表征学习(MRL) , 在一个模型中提供多种嵌入大小 。 开发者可以使用完整的768维向量以获得最佳质量 , 也可以将其截断为较小的维度(128、256或512) , 以提高速度并降低存储成本 。

谷歌在EdgeTPU上将嵌入推理时间(256个输入token)缩短至

利用量化感知训练(QAT) , 谷歌在保持模型质量的同时 , 显著将RAM使用量降低至200MB以下 。

三、断网可用 , 可在不到200MB内存上运行EmbeddingGemma支持开发者构建灵活且注重隐私的设备端应用 。 它直接在设备硬件上生成文档嵌入 , 帮助确保敏感用户数据的安全 。

它使用与Gemma 3n相同的分词器进行文本处理 , 从而减少RAG应用的内存占用 。 用户可使用EmbeddingGemma解锁新功能 , 例如:

无需联网即可同时搜索个人文件、文本、电子邮件和通知 。

通过RAG与Gemma 3n实现个性化、行业特定和离线支持的聊天机器人 。

将用户查询分类到相关的函数调用 , 以帮助移动智能体理解(用户需求) 。

下图为EmbeddingGemma的交互式演示 , 它将文本嵌入在三维空间中可视化 , 该模型完全在设备上运行 。

EmbeddingGemma的交互式演示(图源:Hugging Face团队的Joshua)

Demo体验地址: https://huggingface.co/spaces/webml-community/semantic-galaxy)

结语:小尺寸大能力 , 加速端侧智能发展EmbeddingGemma的推出标志着谷歌在小型化、多语言和端侧AI上的新突破 。 它不仅在性能上接近更大规模的模型 , 还兼顾了速度、内存和隐私的平衡 。

未来 , 随着RAG、语义搜索等应用不断下沉至个人设备 , EmbeddingGemma或将成为推动端侧智能普及的重要基石 。

推荐阅读

- 谷歌TPU业务将独立,估值高达9000亿美元?

- TPU突围,谷歌积极推销自研芯片

- 谷歌无需拆分Chrome,可代价却是安卓用户支付

- 法国监管机构对谷歌公司处以3.25亿欧元罚款

- 143亿美金买来一场空,小扎向谷歌OpenAI低头,史上最大AI赌注失速

- 自研SoC成为性能笑话,谷歌却是在“端水”下大棋?

- 通义实验室开源Mobile-Agent-v3刷新10项GUI基准SOTA

- AI读网页,这次真不一样了,谷歌Gemini解锁「详解网页」新技能

- 手机内存也有“公摊”,谷歌新机搞了个“AI专用”

- 又一国产多模态大模型开源,复杂声音一耳朵分辨,多测试SOTA,还能聊哲学