文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

面对AI淘汰焦虑 , 大量职场人出于生存焦虑主动自费购买AI工具 , 无数职场人正「自费上班」 , 从而开启一场「自我拯救」运动 。 这种现象催生出区别于传统To B和To C的全新赛道「To P」——To Professional 。

你每个月花多少钱买AI工具?

你们公司有统一购买AI服务吗?

你是每月花20美元买ChatGPT Plus , 还是「白嫖」免费的豆包和DeepSeek?

当隔壁工位的同事已经能用AI在半小时内生成一份你得写好几天的专业报告 。

那种「再不跟上就要被淘汰」的焦虑感 , 会让你感到恐慌吗?

当软件巨头IgniteTech的CEO , 因为团队拥抱AI的速度「不够快」而换掉80%的员工时 , 一个残酷的现实摆在了每个职场人面前:要么用AI武装自己 , 要么被会用AI的人淘汰 。

这种打工人的恐慌就像是AI版本的「黑暗森林」和「工具爆炸」:

怕被AI替代、怕被用AI的同事替代、怕被用AI用得特别好的同事替代 。

一场职场人的「赛博续命」就在最近 , 全网爆火的那份MIT报告便描述了这一AI时代独有的现象:

90%员工开始「偷用」ChatGPT续命 , 他们都在频繁地使用个人AI工具!

数据上更加夸张 , 虽然只有40%公司宣称帮助员工订阅了统一的官方服务 , 但受访的90%公司员工都表示 , 他们都在频繁地使用个人AI工具 。

员工使用AI频率 , 是企业采纳率的2倍多 , MIT将这种现象被称为「影子AI经济」 。

前AI时代 , 持续繁荣了30年的互联网时代最喜欢的To B和To C的叙事体系似乎已经无法描述这种新型商业现象 。

这种影子AI经济 , 正对应着如今AI创业中一条独有的赛道 。

当下的AI创业热点藏在一条更隐秘、更迅猛的赛道:

To P(To Professional) , 一场由无数职场人发起的「自我拯救」运动 。

俗称「自费上班」只要分析一下当前比较火爆的创业公司 , 比如AI编程 , AI营销等 , 你就会发现——他们既不是To B , 也不是To C 。

【90%打工人「自费买AI上班」,开启To P革命,每月花20刀效率翻倍】而是To P 。

全球AI独角兽前30和全球AI产品能力前20

以Cursor和ChatGPT为例 。

说他们是To B吧 , 也对 , 因为主要是企业内的一些员工为工作目的使用 。

说是To C吧 , 好像也对 , 因为大部分使用和购买行为都是个人决定的 。

考虑到这种情况 , 我们提出To P的这个赛道:

和To B相比 , 相同点是用户使用AI服务 , 用于商业目的;不同点是 , 使用者是为了提升自己的工作效率 , 因此自己便可以做出购买决定 。 和To C相比 , 相同点是付费行为都是个人决策;但使用服务的目的不同:To C的最终目的是为了自己(比如淘宝买东西 , 抖音看视频) , 而To P的最终目的是为了工作/商业 , 为了别人 , 但自己从中能有收获(大部分时候是金钱 , 也可能是名誉) 。

这钱交的 , ROI太高了为什么是To P模式走得最快?

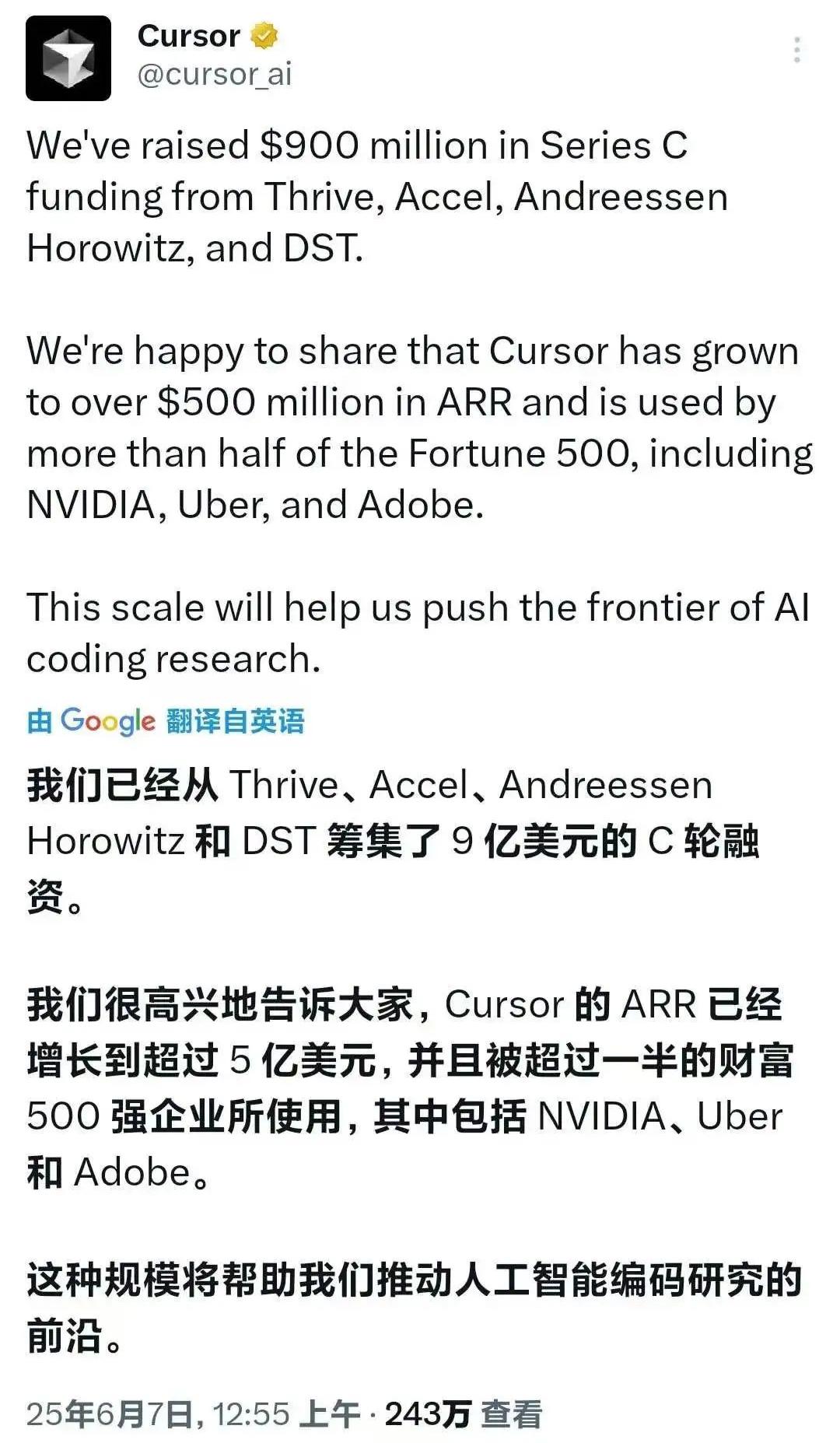

让我们看看Cursor的增长历史 。

Cursor在2024年创造了1 亿美元的收入 , 相比2023年的100万美元增长极为显著 。

到2025年6月 , Cursor的ARR已经超过5亿美元!

Cursor的估值也达到99亿美元 , 进入百亿俱乐部只有一步之遥 。

这让Cursor成为历史上增长最快的SaaS公司 。

为何打工人「愿意」为Cursor付费?

让我们做一个简单的算术题 。

以编程为例 , 程序员买AI编程会员每月花20美元 , 可以使工作效率提高一倍 。

如果他的工资每月是5000美元 , 如果他用同样的工作时间 , 那么他就可以挣到10000美元 。

也就是投入20美元 , 收益10000美元 , 投入产出比500倍!

当然 , 这种计算过于「粗暴」的 , 但这正是用户很容易做出购买AI产品决策的原因 。

这也是当前编程软件增长速度极快的原因 。

这就是To P赛道的特点:用户可以明确地计算投入产出 。

打工人的「反向渗透」为何AI产品在To B和To C赛道上没有快速发展?

To B太慢 , 慢到等不起To B而言 , 需要企业一组人都用 , 需要企业管理者做决策 。

自上而下的决策牵涉到很多问题 , 比如意见不一致 , 预算审批周期等 , 为了这些事情 , 很多企业都需要到年的单位了 。

因此 , 即便理论上是好东西 , 也需要很长时间才能说服B端去采用 。

而对于To P而言 , 就快多了 , 用户自己觉得好就可以支付 , 这个行为和To C是一致的 。

既然个人决策很容易 , 那么为什么To C这条赛道暂时也没有动静呢?

To C太难算账 , 太烧钱To C而言 , 因为消费者就是自己 , 所以不容易算账 。

比如看抖音 , 如果AI使得你更开心(也不容易衡量) , 你会愿意付款吗? 愿意付多少?

从互联网时代而言 , 我们发现To C的服务 , 大部分都走了免费路线 , 其中一小部分走免费+增值收费(视频网站) , 因为免费无法覆盖成本 , 但大部分用户还是不愿意付款的 。

全球付费用户高达3亿的流媒体龙头Netflix , 营收一度陷入停滞

要改变To C产品的用户心智是比较难的 , 用户不愿意付钱 。 那我们干脆不收费不就行了吗?

这个真不行 , AI产品背后的token成本 , 是无法忽略的(不像现在云服务和带宽费用 , 平均到每用户非常低) , 如果没有一定的收费机制 , 用户越多 , 亏损越大 , 进而没有持续性 。

举个例子 , OpenAI用3年时间就达到了120亿美元的ARR , 这在软件历史上前无古人 , 后也很难说有没有来者 。

根据最近的报告 , ChatGPT全球每周活跃用户已达7亿。

很多人会说ChatGPT增长这么快 , 这应该都是To C了吧 。

其实不然 , 虽然都是用户 , 但我们要分析用户使用ChatGPT的目的是什么 。

仔细分析下来 , 其中一部分为了工作(To P) , 一部分为了自己的日常需求(To C) 。

但再深入一步 。

当我们认真思考 , 其实用户购买ChatGPT , 主要还是为了To P部分的需求的 , 比如写工作报告 , 调研报告 , 整理素材等等 。

对于自己的To C部分 , 其实用户是不愿意付钱的 。

尤其是现在免费版的GPT-5等工具 , 已经足够To C用户完成自己的日常任务了 。

那么未来呢?当然了 , To B和To C这两条赛道也都会陆续发展起来 。

对于To B而言 , 当越来越多的「P」(专业人士)在企业内部用个人工具证明了AI的巨大价值后 , 企业层面的采购需求就会被真正激活 。 AI需要进一步在解决跨部门、团队协作等复杂问题上证明其能力 , 届时To B市场就会全面爆发 。

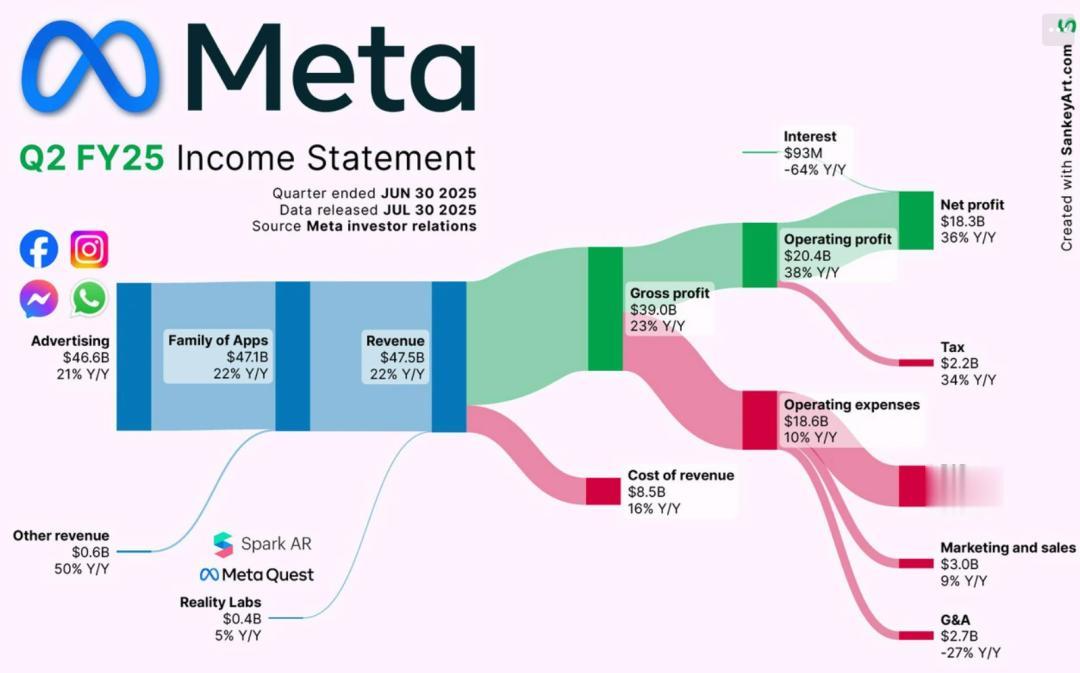

其实 , To B这块已经有非常成功的例子 , 那就是Meta的广告业务 。

在2023 年 , Meta广告收入达到了1319.5亿美元 , 同比增长16.1%。

广告业务几乎占据了Meta整个营收的绝大部分 。

2024年 , Meta的广告收入增长至1606.3亿美元 , 同比增长22% , 这主要得益于广告展示次数(增长11%)和平均广告价格(增长10%)的双重提升 。

然而 , 其成功的真正驱动力在于AI 。

到2025年 , Advantage+Campaigns和Andromeda等AI驱动的工具 , 已将每条合格销售线索的成本降低了10% , 并将Instagram的广告转化率提升了5% 。

这些效率的提升 , 使得采用Meta AI工具的美国广告商 , 其广告支出回报率(ROAS)提高了22%;相比之下 , 未使用AI工具的用户的ROAS仅为3.71美元 。

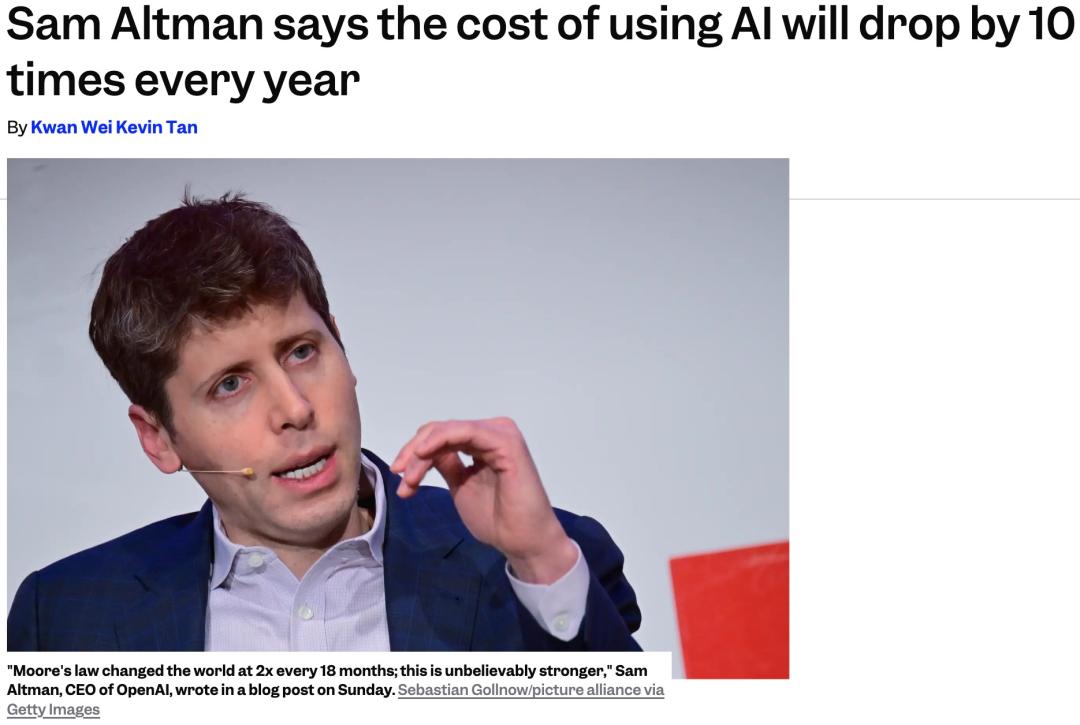

对于To C而言 , 其爆发的关键在于token成本的下降 。

在过去的两年里 , 每token的成本已经降低了几百倍 。

在下面的对数图中 , 可以看到每百万token每年成本都下降10倍 。

在2025年2月 , OpenAI的奥特曼接受采访时曾说 , AI的成本每年将下降10倍 。

同样佐证了这个观点 。

如果未来1-3年 , 成本能继续以每年几十倍的速度下降 , 直到与云计算、网络带宽成本相媲美 , 那么互联网的广告、游戏等免费模式就能支撑起AI应用 。

问题是 , LLM的价格会继续以这样的速度下降吗?

这很难预测 。

在个人电脑革命中 , 成本的大幅下降主要归功于摩尔定律 。

只要这些定律仍然有效 , 晶体管数量和频率持续增加 , 价格下降就很容易预测 。

具体来说 , LLM推理成本的下降是由多个独立因素造成的:

相同运算下更优的GPU成本/性能 。 这是摩尔定律(即芯片上晶体管数量的增加)以及结构改进的结果 。 模型量化 。 最初 , 推理是在16位下进行的 , 但对于Blackwell GPU , 预计4位将成为常态 。 这将带来至少4倍的性能提升 , 但由于所需的数据传输减少且算术单元复杂度降低 , 实际提升可能更大 。 软件优化可减少所需的计算量 , 同样重要的是 , 还可降低所需的内存带宽 。 内存带宽以前是一个瓶颈 。 更小的模型 。 如今 , 一个参数量仅为10亿的模型 , 其性能就超过了仅仅三年前参数量为1750亿的模型 。 更优的指令调优 。 在预训练阶段之后 , 还有更多改进模型的方法 , 其中包括人类反馈强化学习(RLHF)和直接偏好优化(DPO)等技术 。 开源 。 DeepSeek、通义千问和其他公司推出了开源模型 , 这些模型可以由竞争的低成本模型即服务平台托管 。 这减少了整个价值链上的利润空间 , 从而降低了价格 。毫无疑问 , 其中某些领域已经看到快速的进展 , 但在其他领域 , 情况尚不明确 。

到那时 , 才是AI To C创业的黄金时代 。

但至少在目前 , AI的革命是在以To P这种更务实的方式 , 在每一次的ChatGPT对话中 , 在每一个职场人的键盘上 , 悄然取得成功 。

作者介绍 雷鸣 百度七剑客、酷我创始人、Al Basis Fund创始合伙人、北京大学Al创新中心名誉主任、斯坦福大学商学院顾问委员会理事 。

本文来自微信公众号“新智元” , 作者:雷鸣 , 36氪经授权发布 。

推荐阅读

- 800纳米专克西方封锁!俄罗斯打造全周期自主芯片工厂

- 在美国,打工人越老越吃香,22-25岁新人最先被AI淘汰

- 廉价版小米16Pro!红米K90Pro配置曝光,2K+潜望+7000mAh

- 4000元起售?华为8英寸“超大屏手机”官宣!采用麒麟9020处理器

- RTX 5090刚炸没几天:RTX 5070又出现电容爆炸!发出巨响散发焦味

- 华为“大号手机”再次被确认:麒麟9020+66W快充,基础规格也已没悬念

- Android桌面模式都来了,iPhone为何还在“画中画”打转?

- 告别模糊与色淡!一文解决打印不清晰的烦恼

- 红米K90 Pro再次被确认:潜望长焦+无线充,2K普及计划也来了

- 苹果官方配件斜挎带曝光:专为iPhone 17系列打造