让RAG真正读懂“言外之意”!新框架引入词汇多样性,刷新多基准

文章图片

文章图片

文章图片

RAG准确率提升10.6% , 多项基准拿下新SOTA!

ACL 2025最新研究提出Lexical Diversity-aware RAG (DRAG) 框架 , 首次系统性地将词汇多样性引入RAG的检索与生成过程 , 提供了一个轻量、通用且易扩展的解决方案 。

在多项基准任务中 , 该方法带来了显著性能提升 , 尤其在HotpotQA上刷新了当前最优结果 。

在大语言模型的浪潮下 , Retrieval-Augmented Generation(RAG)已经成为提升模型事实性和时效性的重要手段 。 然而 , 现有方法普遍忽视了一个看似细微却极为关键的问题——词汇多样性(lexical diversity) 。

同一个问题 , 不同的表达方式 , 往往让检索模型“晕头转向” , 最终导致错误答案 。

由此 , 来自北航、北大、中关村实验室的研究团队提出了这项最新工作 , 他们首次将“词汇多样性”引入检索增强生成的相关性评估过程 , 并通过新颖的风险稀疏校准机制解决了生成阶段被无关信息干扰的问题 。

团队认为 , 该方法对信息检索、问答系统、专业领域大模型应用都具有重要价值 。 未来 , 他们计划进一步拓展该方法到更多专业场景 , 让大模型不仅能“读懂” , 更能“理解”复杂的人类语言表达 。

词汇多样性:RAG的隐形痛点研究团队指出 , 现有RAG方法大多通过“单一标准”判断检索文档是否相关 , 但现实情况要复杂得多 。 如图所示 , 以问题“What is Hattie McDaniel’s occupation?”为例 , 其中的语义成分表现出不同程度“词汇多样性”:

不变词(Invariant):人名“Hattie McDaniel”一般不会变形; 可变词(Variant):词语“occupation”可以对应“profession”“actress”甚至“Academy Award”; 补充信息(Supplementary):答案可能依赖“American celebrity”等扩展语境 。

这种词汇多样性往往导致模型错误地将部分相似但无关的文档判为相关 , 或者忽略了真正有用的信息 。

两大关键创新为解决“词汇多样性”带来的挑战 , 研究团队提出了该框架 , 核心在于两个互补模块:

1、Diversity-sensitive Relevance Analyzer (DRA)

传统检索相关性评估往往“一刀切” , 把整体查询和检索文档进行比较 。 该方法则进一步拆解查询语义 , 针对不同成分采用差异化策略:

不变成分:如人名、地名等必须精确匹配的关键词 , 该方法强调其检索文档应与该成分严格匹配; 可变成分:如“occupation”—“profession” , DRA借助LLM的语义扩展和分析能力 , 在检索时允许一定语义灵活性; 补充成分:如“American celebrity” , 该方法通过检索需求的明确程度来判断是否需要真正提供有用的补充证据 。在此基础上 , 该方法通过该模块对相似度检索结果进行重排序 , 输出一个更细粒度、多维度的相关性评分 , 避免检索时存在的“假阳性”和“假阴性”的常见问题 。

2. Risk-guided Sparse Calibration

即使有了更精准的检索 , 生成阶段仍然可能“被干扰” 。 Risk-guided Sparse Calibration的设计灵感来自“风险控制”:它会实时监控每个生成token的“被误导风险” , 并在必要时进行解码校准 。

词汇风险 (Lexical Risk):检测生成内容是否过度依赖低相关的词汇; 注意力风险 (Attention Risk):评估模型注意力是否集中在无关段落; 预测风险 (Prediction Risk):衡量当前预测是否与检索证据存在冲突 。RSC的独特之处在于它的稀疏性 (sparse calibration):只对高风险token动态干预 , 而不会对全局输出强行重写 , 从而保证了生成质量与效率的平衡 。

最终 , DRA负责“挑选更靠谱的材料” , RSC负责“防止模型走偏” , 形成了检索与生成环节的双保险 , 让RAG更稳健、更准确 。

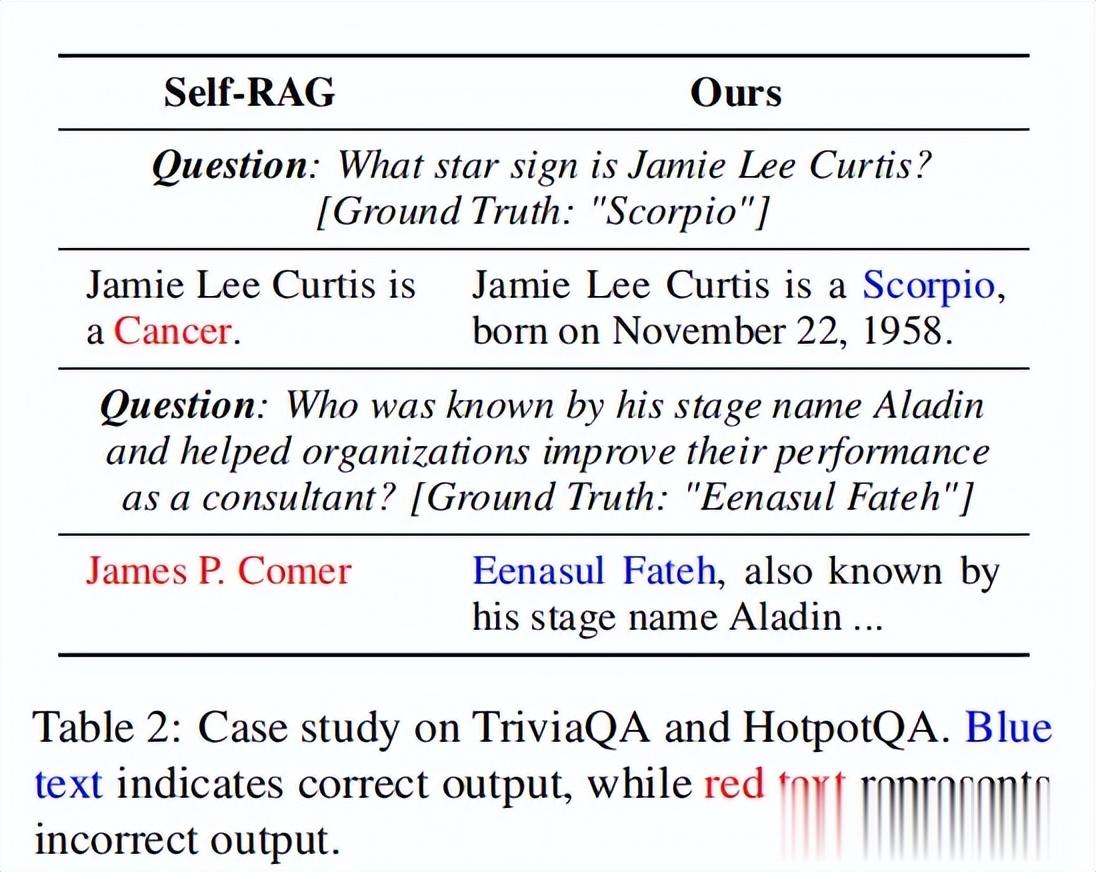

实验结果:显著超越现有方法团队在多个开放域问答基准上验证了该方法:

其中 , 该方法在PopQA/TriviaQA(短文本问答):准确率分别提升4.9%和4.4%;HotpotQA/2WikiMultiHopQA(多跳问答):准确率均提升10.6% , 展现出强泛化性;在ASQA(长答案生成):在str-em、QA-F1等指标上刷新SOTA 。

不仅如此 , 该方法在不同类型、大小的模型上均表现出显著增益 , 如Llama2-7B ,Llama2-13B Qwen2-7B Alpaca-7B和Mistral-7B等 。

论文链接:

https://aclanthology.org/2025.acl-long.1346/代码(即将开源):

https://github.com/Zhange21/DRAG

— 完 —

量子位 QbitAI

【让RAG真正读懂“言外之意”!新框架引入词汇多样性,刷新多基准】关注我们 , 第一时间获知前沿科技动态

推荐阅读

- 6个MCP服务器让智能体AI赋能IT运维工作

- 谷歌让AI更易获取真实世界数据

- 超精辟!1000元的手机怎么选?如何让自己不吐槽

- AI 到底会不会做生意?1688 的答案让人惊喜

- 小米17 VS iPhone 17:参数碾压≠体验完胜,安卓能否真正媲美苹果?

- 几何图片写标题就能让AI更聪明,UIUC发布高质量可泛化几何数据集

- 假期不想人挤人?华为手机“右滑一下”的负一屏,让宅家比旅游还爽

- 华为FreeClip 2 耳夹耳机:让「戴着不摘」成为新的使用习惯

- 越来越让人咂舌,追觅计划开拓小行星探索、采矿业务

- 天玑9500抢先体验:旗舰的新标杆,在于真正的体验跃升