文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

昨晚 , AI 界又来了一波小连招 。

【以前累到吐血造的3D世界,现在一句话就行了?】前有 Claude 编程更强的 Opus 4.1 , 中有谷歌突破性拉满的 Genie 3 。 奥特曼一看也坐不住了 , 赶紧上了个 GPT-OSS , 是 OpenAI 第一次开源 。

然而 , Claude 编程咱可能没啥实感 , OSS 的开源好像也没啥诚意 。 毕竟不是满血版 GPT , 现在效果好的 , 能本地部署的大模型有的是 , OSS 也没强到哪里去 , 甚至被嘲还不如国产同参数量的 GLM-4.5-Air 。。。

相比起来 , 谷歌 DeepMind 这个 Genie 3 , 着实是有些惊艳得吓人了 。 江江这就带大伙儿看看 , Genie 3 是怎么造出一个能玩能动 , 有 “ 记忆力 ” 的高清 3D 世界的 。

作为一个世界模型 , 它延续了 Genie 1 和 2 的技术和概念 , 能通过文字提示词 , 实时生成一个高质量 , 可用上下左右键交互的物理环境 。

话不多说 , 咱先给大伙儿看看效果 。

说实话 , 下面这个视频 , 单拿出来说是哪个游戏录屏我都信 。 视角可以摆动 , 还能用方向键控制运动 , 小车速度快不说 。 甚至会顺着地形颠簸 , 对物理世界的理解拉满 。

再看看水上开船 , 转向丝滑无比 , 连灯笼被船头推开的碰撞效果都特别真实 。

视觉上能这么清晰顺畅 , 是因为 Genie 3 的实时帧率达到了每秒 24 帧 , 分辨率能到 720p , 从这些参数上来看 , 真跟普通视频没啥区别了 。

之前搞世界模型、实时生成的玩法咱也见过 , 不过那体验实在是差得有点多了 。 经常卡顿不说 , 场景一致性也做得稀碎 , 比如眼前本来有个人 , 转个头就没了( 害怕 ) 。 甚至只是站在那里不动 , 场景也肉眼可见的在变 。。。

来自 Dynamics Lab , 试玩链接已放在文末

而 Genie 3 , 前后一致性好得可怕 , 保证一分钟前你在墙上刷的蓝色油漆是啥样 , 一分钟后回头来看还是啥样 。

即使用 prompt 随时加东西 , 也不用担心画面会崩 。

DeepMind 还试了试 Genie 3 和他们自己的 SIMA agent 相结合 。 开局一张图和一条指令 , 剩下的中间 prompt 全靠 agent 编 。

比如给 Genie 3 一个面包房的照片 , 目标是移动到面包冷却架跟前 , agent 就得知道啥是冷却架 , 还得知道按方向键往前走 。

看了这么多例子 , Genie 3 对物理的理解和一致性做得这么好 , 如此迅速流畅 , 江江一开始还以为它生成的是类似 Unity 那样完整的 , 遵循物理规律的 3D 场景建模 。

然而 , 实际上它就是一帧一帧拼出来的 。 在单纯视频生成一致性都很难保证的情况下 , Genie 3 是咋做到上蹿下跳还能不崩?这实在很让人好奇 。。。

但由于自从 Genie 2 就没有技术报告 , 咱只能从蛛丝马迹里抠出来点信息 , 偷窥一下他们是咋施展这个魔法的 。

作为 Genie 系列的第三代 , Genie 3 和其它模型一样 , 都是踩着前浪长大的后浪 。 而说起它的前辈们 , 其实个个也不普通 , 都有不少创新闪光点 。

比如 Genie 1 最先开创了上上下下左左右右的玩法 。 根据它的论文来看 , 为了让生成的内容连续可控 , Genie 1 当年就是一个自回归模型 , 简单来说 , 每生成下一帧 , 都要记得回顾一下所有历史 。

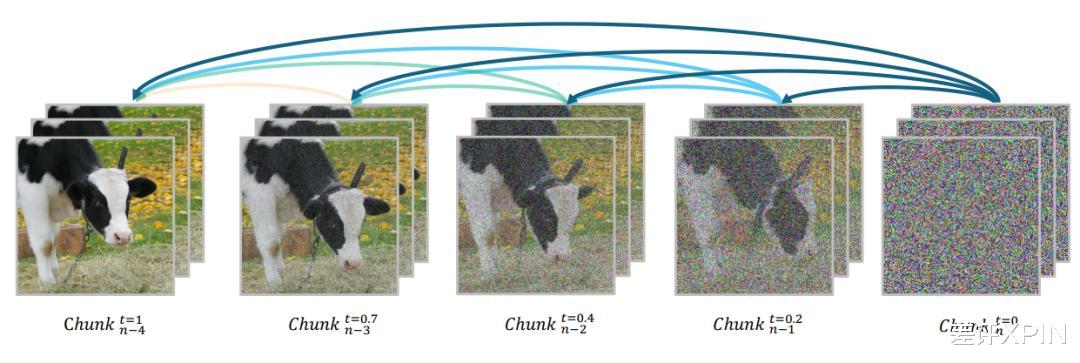

自回归示意图 , 来源:自回归视频模型 Magi-1 技术报告

Genie 1 还额外搞了个模块 , 专门关注空间和时间之间的关系 , 也就是时空建模 。

到了训练阶段 , 因为大部分互联网视频都没动作标签 , 根本不知道视频里按了哪个键 , 会让人跑多远 , 所以他们选择直接用模型预测下一帧会干啥 , 逼模型自己学出每个动作的隐含意义 , 这也就是无监督潜在动作学习 。

Genie 1 是生成 2D 场景

可惜 , Genie 2 之后就没有技术报告了 , 从结果上看 , 它从 2D 进化到了 3D , 能保持一致性的时长也达到了最多一分钟 。

最后到了 Genie 3 这里 , 已经能做到长时间、强一致性的实时生成了 。 从一代的论文来猜 , 它们背后的一些技术像自回归、时空建模、无监督潜在动作学习等等 , 很可能是代代相传的 。

而从 1 到 3 , 进步这么大 , 其实 DeepMind 也只花了一年半 。。。 未来可期啊 。

不过 , 虽然效果很不错 , DeepMind 也很诚实地表示 , Genie 3 还是有很多不足的 。 比如环境里的行动空间还是会受到限制、对提示词要求很高、交互也只能持续几分钟等等 。

要是这些问题都能解决 , 感觉离一键生成 3D 风景游戏啊、在超真实的环境里训练具身智能机器人啊、甚至小扎念念不忘的元宇宙都更近了一步 。

总的来说 , DeepMind 这波确实搞了个好玩的东西 , 比起隔壁卷参数、卷性能的大模型可有意思多了 。

咱可能感觉不出来一个模型回答问题有没有更精准 , 但 Genie 3 这个视觉冲击、实时交互玩法可是实实在在的不一样了 。

原来搞游戏开发 , 用各种引擎软件大伙儿累到吐血才能抠出来的游戏场景 , 现在用世界模型就能迅速做出来同样的效果 , 这性价比简直拉满 。

不过唯一的问题 , 是 DeepMind 没开放过任何试用版本 , 希望他们不要在 Demo 里超神 , 试用里超鬼就好 。。。

推荐阅读

- 高通联发科旗舰Soc即将干到2500元以内:核心体验已接近旗舰

- 百镜出道,C位依旧:WAIC顶流Rokid是怎么做到的?

- 16+1TB版本,从4999到2600出头!小米14能不能闭眼冲?

- 轻薄续航兼顾!曝三星Galaxy S26 Edge电池升级到4400mAh

- 对话韶音:从骨传导先锋到开放聆听生态的全面布局

- 从科幻到现实:脑机接口实现意念操控iPad

- RDNA4到此为止了吗!AMD RX 9060显卡悄悄发布:可惜不零售

- 骁龙8 Gen5突然曝光,小米未抢下首发,友商超猛新机杀到!

- 直击CJ2025:骁龙如何从游戏芯到全能王?

- 体验三星 Galaxy Z Fold7:翻折进化,从优雅到强大