文章图片

文章图片

文章图片

文章图片

本文第一作者唐飞 , 浙江大学硕士生 , 研究方向是 GUI Agent、多模态推理等 。 本文通讯作者沈永亮 , 浙江大学百人计划研究员 , 博士生导师 , 研究方向包括大模型推理、多模态大模型、智能体等 。

1. 研究背景和方法亮点

在人工智能飞速发展的今天 , GUI 智能体(GUI Agent)正在成为下一个技术风口 。 这些 \"数字助手\" 能够像人类一样 , 通过自然语言指令自动操控电脑、手机等设备界面 , 从发邮件到编辑文档 , 几乎无所不能 。 想象一下 , 你只需说一句 \"帮我在地图上添加个标记\" , AI 就能自动找到按钮并完成操作 —— 这就是 GUI 智能体的魅力所在 。

但要实现这一切 , 有一个关键技术环节不能忽视:GUI Grounding(图形界面定位) 。 这是 GUI 智能体的 \"眼睛\" 和 \"手\" , 负责将自然语言指令精确映射到屏幕上的具体像素位置 。 就像人类看到 \"点击保存按钮\" 时能迅速定位并操作一样 , GUI Grounding 让 AI 能够 \"看懂\" 界面并知道该点击哪里 。

然而 , 这个看似简单的任务实际上充满挑战 。 现有的 GUI Grounding 方法普遍存在一个致命缺陷:它们把复杂的空间交互简化成了 \"非黑即白\" 的二元判断 。

具体来说 , 当前主流方法采用的是二元奖励机制 —— 要么完全正确(奖励 = 1) , 要么完全错误(奖励 = 0) 。 这就像用 \"及格 / 不及格\" 来评价射击成绩:只要没打中靶心 , 哪怕子弹擦边而过 , 也和完全脱靶一样被判为 \"0 分\" 。

这种评判标准带来了三大问题:

学习信号稀疏:模型在训练初期很难获得有效反馈 , 就像蒙着眼睛射箭 , 根本不知道朝哪个方向改进 。 ; 忽视空间连续性:界面交互本质上是连续的空间过程 , 距离目标 1 像素和距离 100 像素理应得到不同的评价 , 但二元机制完全忽略了这种差异 。 ; 与人类点击行为不符:作者通过分析 AITW 数据集发现 , 人类点击行为天然地遵循以目标为中心的高斯分布模式 , 而现有方法完全背离了这一自然规律 。更关键的是 , GUI 界面元素具有天然的二维空间属性 —— 它们是有面积、有边界的区域 , 而不是抽象的点 。 用户可以在按钮的任意位置成功点击 , 只要在边界内即可 。 但传统的二元奖励机制完全忽略了这种空间特性 , 将丰富的几何信息简化为单一的 \"中心点命中判断\" 。

正是在这样的背景下 , 一个关键问题摆在了研究者面前:

“GUI Grounding 是否有更适合该任务特性的奖励机制?”

来自浙江大学的研究团队提出新方法 ——GUI-G2(GUI Gaussian Grounding Rewards) , 一个将 GUI 交互从离散的 \"打靶游戏\" 转变为连续的 \"空间建模\" 的全新方案 。

论文地址: https://arxiv.org/pdf/2507.15846 项目主页:https://zju-real.github.io/GUI-G2 GitHub:https://github.com/ZJU-REAL/GUI-G2 Huggingface Paper: https://huggingface.co/papers/2507.158462.GUI-G2 框架:让 AI 学会 \"人性化\" 点击

面对传统二元奖励的局限性 , 研究团队提出了 GUI-G2(GUI Gaussian Grounding Rewards)框架 , 核心思想是:既然人类的点击行为遵循高斯分布 , 为什么不让 AI 也这样学习?

GUI-G2 的创新之处在于将 GUI 元素建模为二维高斯分布 , 而非简单的点或矩形框 。 这一设计带来了三个关键突破:

1. 双重高斯奖励机制:

a) 高斯点奖励(Gaussian Point Rewards):评估定位精度 , 奖励值随着预测中心与目标中心的距离呈指数衰减 。 就像射击比赛中 , 越靠近靶心得分越高 。

b) 高斯覆盖奖励(Gaussian Coverage Rewards):评估空间重叠度 , 通过测量预测分布与目标区域的重叠程度 , 确保模型理解元素的完整空间范围 。

2. 自适应方差机制:不同界面元素的尺寸差异巨大 —— 从几像素的小图标到全屏的面板 。 GUI-G2 引入自适应方差机制 , 根据元素实际尺寸动态调整高斯分布的 \"容错范围\":(1)小图标:要求精确定位(小方差)(2)大按钮:允许更大的空间误差(大方差) 。 这就像人类的点击习惯 —— 对小目标更加小心 , 对大目标相对宽松 。

3. 连续空间优化:与传统方法在目标框边界处出现 \"奖励悬崖\" 不同 , GUI-G2在整个界面平面提供平滑的梯度信号 。 模型在任何位置都能获得有意义的反馈 , 大大提升了学习效率 。

3、实验结果

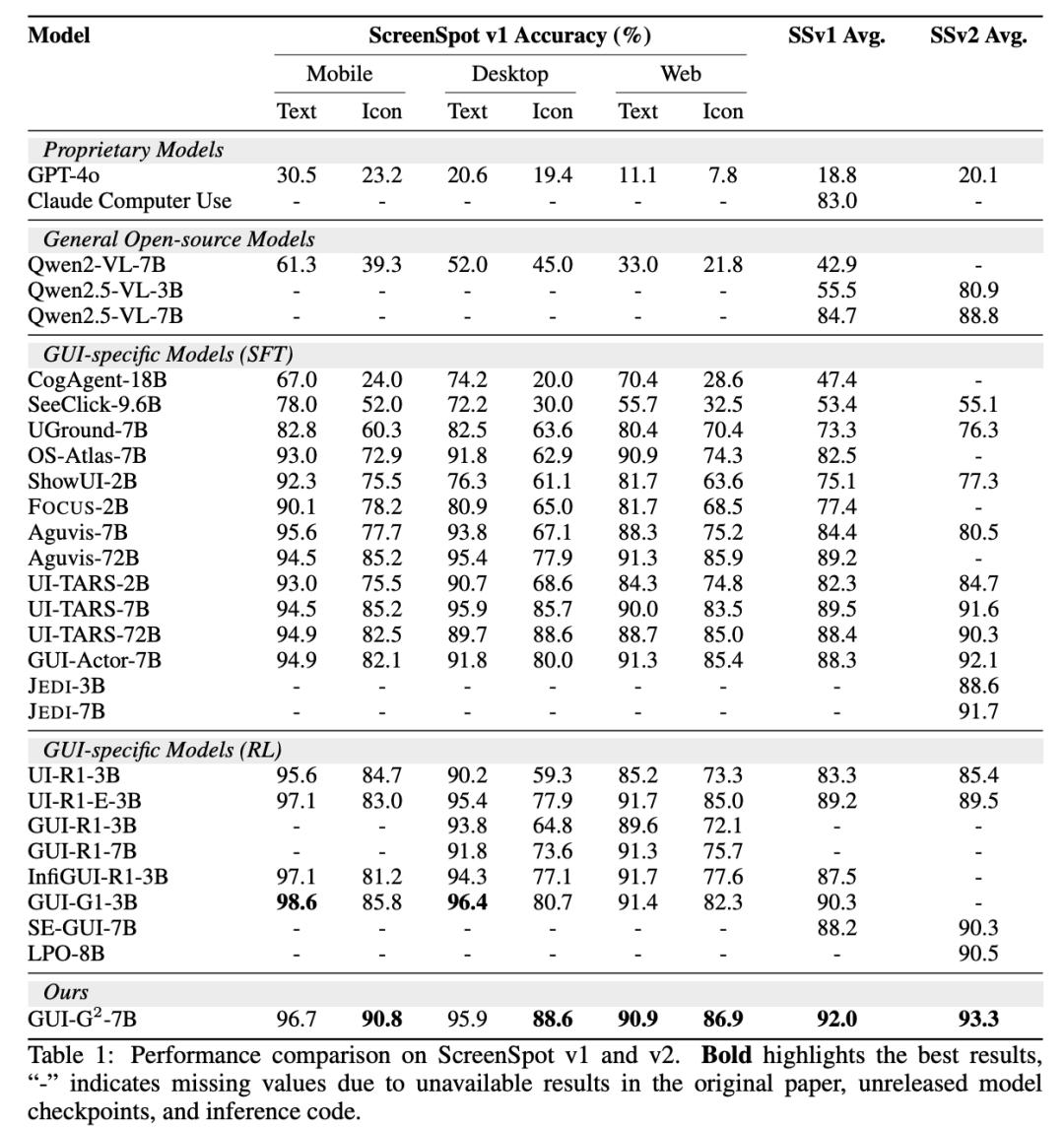

研究团队在三个主流 GUI 定位基准上进行了全面评估 。 性能表现亮眼 ScreenSpot: 92.0% 准确率;ScreenSpot-v2: 93.3% 准确率;ScreenSpot-Pro: 47.5% 准确率 , 比 UI-TARS-72B 提升 24.7% 。 特别值得注意的是 , GUI-G2-7B 仅用 7B 参数就超越了 72B 参数的大型模型 , 展现了惊人的效率优势 。

4、训练动态分析

对比实验显示 , 传统稀疏奖励在训练过程中表现出严重的不稳定性 —— 奖励值剧烈波动 , 距离目标中心的收敛过程杂乱无章 。 而 GUI-G2 展现出单调平滑的收敛曲线 , 从 290 像素逐步优化到 150 像素 , 学习过程清晰可控 。

5、消融研究证实设计合理性

移除覆盖奖励:性能下降至 92.1%(-1.2%) 移除点奖励:性能下降至 90.2%(-3.1%) 限制奖励范围:仅在目标框内提供高斯奖励 , 性能下降 4.9% 固定方差机制:使用统一方差参数 , 性能仅 87.8% , 比自适应机制低 5.5 个百分点

这些结果证实了双重奖励机制的必要性 , 以及全空间连续反馈的重要作用 。

6、虚假奖励实验:验证方法的本质有效性

【浙大团队提出GUI-G2,显著提升GUI智能体定位性能】为了证明 GUI-G2 的提升并非来自于强化学习的 \"虚假刺激效应\" , 研究团队特意设计了对照实验 —— 使用完全随机的奖励信号进行训练:

连续随机奖励 U (01):从 90.6% 逐步下降至 87.9%(-2.7%) 二元随机奖励 {01:从 88.6% 快速跌至 84.5%(-4.1%)实验结果表明 , 虚假的随机奖励只会让性能持续恶化 , 这有力证明了 GUI-G2 的性能提升源于其科学的空间建模机制 , 而非强化学习过程中的偶然因素 。

7、GUI-G2总结

GUI-G2通过三个核心创新重新定义了GUI交互的本质:引入双重高斯奖励机制 , 同时优化定位精度和空间覆盖;设计自适应方差机制 , 根据元素尺寸动态调整容错范围;实现连续空间优化 , 为模型提供平滑的全域梯度信号 。 这一框架将GUI定位从稀疏的二元优化转变为密集的连续奖励反馈 , 在三个基准测试中均取得显著提升 。

推荐阅读

- 960颗类脑芯片,浙大“悟空”出世

- Zoom团队:AI推理新突破提升ChatGPT效率80%

- 全国产智能体MasterAgent:一句话造专属AI团队,专业协同交付

- VLA-OS:NUS邵林团队探究机器人VLA做任务推理的秘密

- 教AI学会犯错——加州大学伯克利分校团队揭示编程教育新思路

- 多模态大模型学会回头「看」:中科院自动化所提出GThinker模型

- 清华大学团队让AI学会识别表情背后的真实感受

- 复旦联合南洋理工提出基于视觉Grounding的多轮强化学习框架MGPO

- Meta出走华人创业团队,种子轮800万美元,要打造视觉AI记忆大脑

- 夸克、浙大开源OmniAvatar,一张图+一段音,就能生成长视频