文章图片

文章图片

文章图片

文章图片

近期 , 夸克技术团队和浙江大学联合开源了OmniAvatar , 这是一个创新的音频驱动全身视频生成模型 , 只需要输入一张图片和一段音频 , OmniAvatar即可生成相应视频 , 且显著提升了画面中人物的唇形同步细节和全身动作的流畅性 。 此外 , 还可通过提示词进一步精准控制人物姿势、情绪、场景等要素 。

OmniAvatar已开源:

- Model:https://huggingface.co/OmniAvatar/OmniAvatar-14B

- Code:https://github.com/Omni-Avatar/OmniAvatar

- Arxiv:https://arxiv.org/abs/2506.18866

- Project Page:https://omni-avatar.github.io/

以下 , 是OmniAvatar在播客、唱歌、交互、动态背景等场景下的部分案例 。

https://mp.weixin.qq.com/s/kSuN83WsDsQYmNs89e_wdg

实验表明 , OmniAvatar在唇形同步、面部及半身视频生成、文本控制等多个维度上 , 均取得领先表现 , 并更好地平衡了视频质量、准确度、审美三要素 。

此外 , OmniAvatar专门针对长视频生成进行了优化 , 可以更好地保持人物一致性和时间连贯性 。

【夸克、浙大开源OmniAvatar,一张图+一段音,就能生成长视频】模型能力

图片+音频=全身视频

当前 , 音频驱动人体运动的技术已取得显著进展 , 但大多数方法仍集中在面部运动 , 缺乏全身驱动的能力 , 且难以进行精确的提示词控制 。

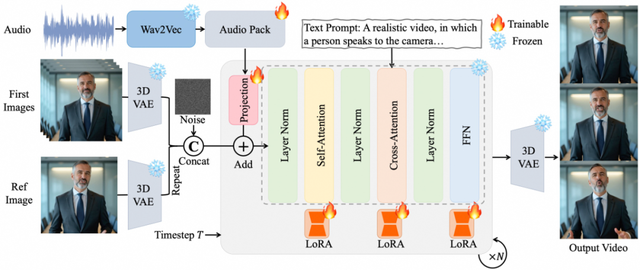

OmniAvatar以Wan2.1-T2V-14B为基础模型 , 利用LoRA方法进行微调 , 有效地引入了音频特征 。 这种结合不仅保留了Wan2.1-T2V-14B在视频生成方面的强大能力 , 还提高了模型对音频输入的适应性和生成质量 。

OmniAvatar架构图

接下来 , 我们将通过一些具体案例 , 更详细地展示模型在多种场景下的能力 。

OmniAvatar能够根据输入的音频和提示词 , 生成虚拟人物视频 , 其中 , 人物的唇形运动与音频内容吻合 , 场景则反映了提示词内容:

通过调整提示词 , 还可实现对人物情绪的精确控制:

在带有镜头运动的场景中 , OmniAvatar仍能够保持面部、动作和背景的自然流畅 , 展现了模型在动态场景下的强大适应能力:

对于长视频生成 , OmniAvatar通过参考图像嵌入策略和帧重叠技术 , 确保了视频的连贯性和人物身份的一致性:

像素级多层次音频嵌入策略

精准唇部运动+自然肢体动作

大多数现有方法通常依赖交叉注意力机制来引入音频特征 , 虽然效果良好 , 但会引入大量额外的计算开销 , 并且容易过度关注音频与面部特征之间的关系 。

针对这一问题 , 团队提出了一种基于像素的音频嵌入策略 , 使音频特征可以直接在模型的潜在空间中以像素级的方式融入 。 通过这一方法 , 不仅可以自然地将唇部运动与音频内容对齐 , 还能够确保音频信息在整个视频像素中均匀分布 , 从而使模型生成更协调、更自然的身体动作来匹配音频 。

该策略首先使用Wav2Vec2模型提取音频特征 , 然后对这些特征进行分组打包和压缩 , 再通过音频打包模块映射到视频的潜在空间中 。

接下来 , 为了确保模型在深层网络中能有效地学习和保留音频特征 , OmniAvatar采用了一种多层级音频嵌入策略 , 将音频信息嵌入到DiT模块的不同阶段中 。 为防止音频特征对潜在空间产生过度干扰 , 音频嵌入仅应用于模型的第二层至中间层之间的模块。 此外 , 这些层的权重不共享 , 使模型能够在不同层次上保持独立的学习路径 。

基于LoRA的优化策略

平衡微调 , 兼顾质量与细节

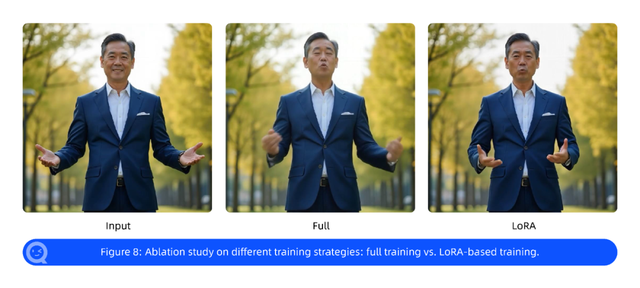

目前 , 针对音频条件扩散模型的方法主要遵循两种策略:一种是训练完整的模型 , 另一种是仅微调特定层 。

在进行完整训练时 , 团队发现更新所有层反而会导致模型生成的连贯性和视频质量下降 。 具体来看 , 由于模型过度拟合人类语音数据集 , 导致泛化能力差 , 容易生成不切实际或静态的内容 , 难以捕捉细节 。 但另一方面 , 仅微调和音频特征相关的层会导致音频和视频之间的对齐效果差 , 唇形同步性能受损 。

效果对比

为了解决这些挑战 , 团队提出了一种基于LoRA的平衡微调策略 。 该策略不同于以上两种方法 , 而是使用LoRA策略高效地适应模型 。 LoRA通过在注意力和前向传播(FFN)层的权重更新中引入低秩矩阵 , 使模型能够在不改变底层模型容量的情况下学习音频特征 。

长视频生成

身份保留+时间一致性

长视频连续生成是音频驱动视频生成的难点 , 也是一项关键挑战 。 为此 , 团队提出了参考图嵌入和重叠帧策略 , 以实现人物的身份保留和时间一致性 。

代码示例

身份保留 。 OmniAvatar引入了一个参考帧 , 作为人物身份的固定指导 。 具体来看 , 首先需提取参考帧的潜在表示;然后将这些表示多次重复 , 使其长度与视频帧数匹配;接下来 , 再在每个时间步 , 将这个重复的参考帧潜在表示与视频潜在表示进行连接 。 因此 , 通过参考帧设计 , 可有效锚定人物身份 , 确保在整个长视频序列中的人物一致性 。

时间一致性 。 为了实现无缝的视频连续性 , OmniAvatar采用了一种潜在重叠策略 。 首先 , 在训练时使用单帧和多帧前缀潜在变量的组合进行训练;其次 , 在推理过程中 , 对于第一批的帧 , 参考帧既作为前缀潜在变量 , 又作为身份指导;对于后续批次 , 则用前一组的最后帧作为潜在变量 , 参考帧仍保持固定用作身份指导 。

One More Thing

OmniAvatar是团队在多模态视频生成上的初步尝试 , 并在实验数据集上得到了初步验证 , 但尚未达到产品级应用水平 。 未来 , 团队还将在复杂指令处理能力、多角色交互等方面进一步探索 , 扩大模型在更多场景中的应用 。

推荐阅读

- 六月单品销量Top20,OPPO Reno14、小米15大亮

- MOVA Z60 Pro评测:清洁、越障、自清洁都超强,妥妥扫地机新王?

- 漫步者蓝牙音箱音质怎么样?西圣、漫步者、小米音箱真实横评对比

- 史上最贵光刻机、30亿/台!中国被卡脖,ASML表态:中国可能买不到

- 杀入对方腹地 大疆、影石要干起来了

- 5G、新能源汽车,美国输给中国了,在6G、AI上,美国可能也会输?

- 性价比第一,又要迭代了,天玑9400+芯片、8000mAh加持

- 光纤入户后,网线没换等于白装?超五类、六类线的区别

- 首发即巅峰:7410mAh、天玑9400+芯片、独显D2,仅2209元

- 到底谁在挤牙膏!AMD、NVIDIA显卡代际提升对比:平均差了12%