文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

想让 AI 能 「看着你的自拍就生成一致且自然的短视频」 吗?这就是 Subject-to-Video(S2V)生成要解决的问题:让视频生成不仅对齐文本 , 还能准确保留指定人物或物体的特征 , 让生成的视频既 「像」 又 「自然」 。 这一能力对于短视频生成、虚拟人、AI 剪辑等都有巨大意义 。

然而 , 要训练和评价这样的模型 , 过去一直缺少公开可用的大规模数据集和细粒度评测基准 , 限制了 S2V 技术的快速突破 。

为此 , 北大团队推出了全新的开源套件 OpenS2V-Nexus , 专为 S2V 生成打造:

OpenS2V-Eval:全球首个面向主体一致性、自然度和文本对齐的 S2V 细粒度评测基准 , 让不同模型在主体一致性上真正可比 。

OpenS2V-5M:全球首个公开的 500 万条高质量 720P 人物文本视频三元组数据集 , 覆盖真实和合成数据 , 帮助研究者快速训练更强大的生成模型 。

北大团队还在 18 个代表性 S2V 模型上进行了系统评测 , 首次揭示了目前主流模型在保持主体一致性和自然度方面的真实能力差距 。

通过 OpenS2V-Nexus , 未来做 AI 视频生成不再盲人摸象 , 让训练更高效、评测更科学 , 让真正可控、自然且保持人物一致的 AI 视频生成技术更快落地到你的应用里 。

该工作带来三大核心贡献:

- 构建 OpenS2V-Eval:领域最全面的 S2V 评测基准 , 构建了 180 个多领域提示词 + 真实 / 合成双类别测试数据 。 提出了 NexusScore、NaturalScore 和 GmeScore , 精准量化模型在主体一致性、自然度、文本对齐三大维度的能力 。

- 同步开源 OpenS2V-5M 百万计数据集:包含 540 万 720P 高清「图片 - 文本 - 视频」三元组 , 通过跨视频关联分割 + 多视角合成技术 , 实现主题多样性与高质量标注 。

- 提供 S2V 模型选择的新见解:基于全新评测框架 , 团队对 18 个主流 S2V 模型展开全面测评 , 揭示不同方法在复杂场景下的优劣差异 。

- 论文地址:

- https://arxiv.org/abs/2505.20292

- 项目地址:

- https://pku-yuangroup.github.io/OpenS2V-Nexus/

- 数据集地址:

- https://huggingface.co/datasets/BestWishYsh/OpenS2V-5M

- 评估基准地址:

- https://huggingface.co/datasets/BestWishYsh/OpenS2V-Eval

(1)泛化能力不足:当遇到训练中未见过的主体类别时 , 模型的生成效果往往显著下降 。 例如 , 仅在西方面孔上训练的模型 , 在生成亚洲人主体时通常表现更差 。

【500万视频数据集+全新评测框架!北大开源OpenS2V-Nexus】(2)“复制粘贴” 问题:模型在生成视频时 , 往往会直接照搬参考图像中的姿势、光照和轮廓 , 导致生成结果缺乏自然感 。

(3)人物一致性不足:相比于生成非人类主体 , 现有模型在保持人物身份一致性方面仍存在明显不足 。

一个有效的评测基准理应能够揭示并量化这些问题 。 然而 , 即便生成的视频主体看起来不自然或身份一致性较差 , 现有评测基准往往仍给出较高的分数 , 阻碍了 S2V 领域的进一步突破和改进 。

北大团队通过 OpenS2V-Eval 揭示了现有模型在这三个方面的缺陷 , 并提出 OpenS2V-5M 从数据层面解决这些问题 。

OpenS2V-Eval 评测基准

现有的视频生成评测基准大多聚焦于文本生成视频(text-to-video)任务 , 典型代表包括 VBench 和 ChronoMagic-Bench 。 虽然 ConsisID-Bench 可用于 S2V 任务 , 但其评测范围仅限于面部一致性 。 Alchemist-Bench、VACE-Benchmark 和 A2 Bench 支持对开放域 S2V 模型进行评测 , 但它们主要采用的是全局、粗粒度的评测方式 。 例如 , 这些基准未能对生成视频中主体的自然度进行有效评估 。

为应对这一挑战 , 团队提出了 OpenS2V-Eval , 这是领域内首个全面的 Subject-to-Video(S2V)评测基准 。 具体而言 , 团队定义了七大类别(见图示):① 单人脸生成视频 , ② 单人全身生成视频 , ③ 单实体生成视频 , ④ 多人脸生成视频 , ⑤ 多人全身生成视频 , ⑥ 多实体生成视频 , ⑦ 人物与实体混合生成视频 。 针对每个类别 , 设计了 30 个富含视觉内容的测试样本 , 用于全面评测模型在不同主体上的泛化能力 。

并且 , 针对现有自动化评测稳健性不足的问题 , 团队首先提出 NexusScore , 结合图像检测和多模态检索模型 , 用于精准评估主体一致性 。 其次 , 团队提出基于 VLM 的 NaturalScore , 填补了当前评测中对主体自然度评价的空白 。 最后 , 团队提出 GmeScore , 相比传统方法能更准确地评估文本相关性 。

OpenS2V-5M 百万级数据集

此外 , 当社区尝试将基础模型扩展到下游任务时 , 现有数据集在支持复杂任务方面仍存在明显不足(见表格对比) 。 为弥补这一限制 , 团队提出了 OpenS2V-5M , 这是首个专为 Subject-to-Video(S2V)设计的百万级规模数据集 , 同时也可用于文本生成视频等任务 。

以往方法通常直接从训练视频帧中裁剪出主体图像 , 着可能导致模型倾向于学习捷径而非真正的内在知识 。 为了解决这一问题 , 团队在数据层面引入了 Nexus Data , 具体包括:(1)通过跨视频关联构建丰富的配对信息;(2)在原始帧上使用多模态大模型生成多视角表示 , 以丰富数据的多样性和泛化能力 , 从而有针对性地应对前述的三大核心挑战 。 常规数据与 Nexus 数据之间的比较如下图 5 所示 , 可见 OpenS2V-5M 具有更高的质量 , 有望解决 S2V 模型面临的三大核心挑战 。

评估实验

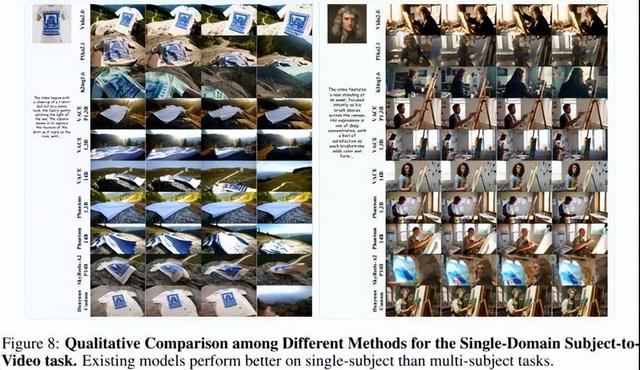

团队评估了几乎所有的 S2V 模型 , 包括四个闭源模型和十二个开源模型 。 这些模型涵盖了支持所有类型主体的模型 , 以及仅支持人物身份的模型 。 结果如下图所示 , 总体而言 , 闭源模型在整体能力方面表现出明显优势(例如 Kling) 。 以 Phantom 和 VACE 为代表的开源模型正在逐步缩小这一差距;然而 , 这两种模型都存在以下三个共同问题:(1)泛化能力差:某些主体的保真度较低 。 例如 , 在下图 6 的案例 2 中 , Kling 生成了错误的操场背景 , 而 VACE、Phantom 和 SkyReels-A2 生成了保真度较低的人物和鸟类;(2)复制粘贴问题:在图 7 中 , SkyReels-A2 和 VACE 错误地将参考图像中的表情、光照或姿态复制到生成视频中 , 导致输出不自然;(3)人类保真度不足:图 7 显示所有模型都未能准确渲染人物侧脸 。 此外 , 还观察到:(1)随着参考图像数量的增加 , 保真度逐渐下降;(2)初始帧可能模糊或直接被复制;(3)保真度随时间逐渐下降 。

验证实验

团队还通过人工交叉验证验证指标和数据集的有效性 。 显然 , 所提出的三个指标与人类感知一致 , 能够准确反映主体一致性、主体自然性和文本相关性 。 并且数据集能有效解决 S2V 的三大核心问题 。

推荐阅读

- 华为极简全闪数据中心Pro+登场,为千行万业数智化转型赋能

- REDMI K90系列现身GSMA数据库:处理器尘埃落定

- 尼康Z5II拍人像怎么样?全画幅配置加持,对焦精准且视频性能出色

- 数据治理0-1阶段:数据治理运营机制与文化培育

- WAIC特别企划视频栏目《AI面对面》,讲出你的「热AI」故事

- 如何用DeepSeek做数据分析?这套方法超神!

- PICO视频本周上新:穿越旗袍古韵、海底疗愈与星际哲思

- 从蓝图到地基:政府企业数据治理0-1的顶层设计与核心框架搭建

- 安克与ATL达成战略合作!锁定4500万片高能量密度电芯

- 用 AI 赋能数据可视化,让数据讲故事