文章图片

文章图片

文章图片

【理解帮助生成?RecA自监督训练让统一多模态模型直升SOTA】

文章图片

文章图片

谢集 , 浙江大学竺可桢学院大四学生 , 于加州大学伯克利分校(BAIR)进行访问 , 研究方向为统一多模态理解生成大模型 。 第二作者为加州大学伯克利分校的 Trevor Darrell , 第三作者为华盛顿大学的 Luke Zettlemoyer , 通讯作者是 XuDong Wang Meta GenAl Research Scientist , 博士毕业于加州大学伯克利分校(BAIR 实验室) , 这篇工作为他在博士期间完成 。

背景:统一多模态理解与生成模型的挑战

统一多模态模型(Unified Multimodal Models UMMs)旨在将视觉理解和生成统一于单一模型架构 。 UMM 继承了多模态大语言模型 (Multimodal Large Language Models MLLMs) 可以很轻松地辨别物体的左右、颜色、种类 。 但是很多生成模型连「一只黑色的猫和白色的狗」 , 「黄色西兰花」都无法生成 。 这体现了当前统一多模态模型在视觉理解和生成能力上的不平衡:它们往往在理解图像内容方面表现出色 , 但在根据文本描述生成图像时却力不从心 。 这是为什么呢?

实际上 , 图片是一个「稠密」的模态 , 文字是一个「稀疏」的模态 , 从一个稠密的信息里提取稀疏的信息(VQA , Image Captioning)是相对轻松的 , 但是要从稀疏的信息去构建稠密的信息则更为困难 。 传统的文生图训练依赖大规模的图像 - 文本对数据 , 这些文本描述 (text caption) 无法完整的表述图片里的所有信息 。 比如物体位置关系、几何结构 , 物体的纹理和风格等 。 这可能导致图像生成模型学到不完整甚至有偏差的视觉概念(例如 , 将「西兰花」与「绿色」联系在一起 , 导致模型无法生成「黄色西兰花」) 。 我们称这种文本监督为「稀疏监督」(sparse supervision) 。

方法:重建对齐 (Reconstruction Alignment RecA)

有没有「稠密监督」(Dense Supervision) , 可以让模型学到更完整的视觉概念呢?答案是有的 。 图片本身正是最好的信息载体 。 UMM 提供了一个将图片作为「提示词」(prompt) 输入的机会 。 现在的 UMM 的视觉理解编码器 (Visual Understanding Encoder) , 如 CLIP SigLIP , 已经可以把图片映射到了 LLM 的语义空间 (language-aligned semantic space) 。

以此为动机 , 我们提出了一种简单而有效的后训练方法 —— 重建对齐(Reconstruction Alignment RecA) 。 RecA 并非对模型架构本身做出改动 , 而是在模型常规训练完成后 , 额外进行一阶段自监督的后训练 。

Arxiv:https://alphaxiv.org/abs/2509.07295 代码:https://github.com/HorizonWind2004/reconstruction-alignment 项目主页:https://reconstruction-alignment.github.io/

具体来说 , 在 RecA 训练过程中 , 模型首先利用其视觉理解编码器从输入图像提取出语义嵌入特征(例如采用预训练的 CLIP、DINO 等模型获取图像的高维语义表示) , 与一个模板文本嵌入相融合 , 再送入统一多模态模型 , 使其以此为条件试图重建出原始输入图像 。 根据生成的图像与原图像之间的差异计算自监督重建损失 , RecA 将视觉理解分支中蕴含的细节知识有效对齐到生成分支 。

值得一提的是 , RecA 的训练不需要任何的图像 - 文本对 , 只需未标注的图像即可完成训练 。 训练完成后 , 模型在推理时并不需要额外输入这些视觉嵌入 , 仍然像普通生成模型一样 , 仅通过文本提示即可工作;换言之 , RecA 是一种纯训练阶段的对齐策略 , 不会增加推理阶段的开销或改变使用方式 。

实验结果

通用性(Generality)

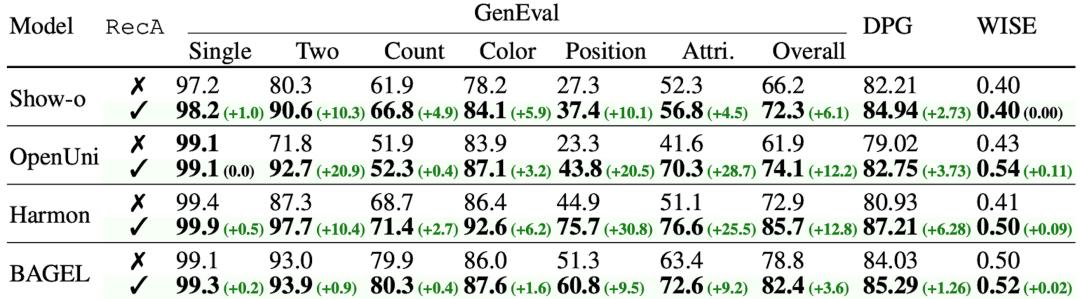

为了验证 RecA 的有效性 , 我们在四种代表性的统一多模态模型上进行了实验 。 1. Show-o (AR) Harmon (AR+MAR) OpenUni (AR+Diffusion Metaqueries 开源版) BAGEL (AR+Diffusion) 等模型 , 涵盖了当前的主流架构 。 可以发现 , RecA 在所有模型上均带来了显著的性能提升 , 显示出其方法的通用性和稳健性 。

SOTA 结果(State-of-the-art Results)

我们使用 RecA 后训练得到的 Harmon-1.5B 模型展现出了极强的提高 , 在不使用 GPT-4o-Image 蒸馏数据和 RLHF 的情况下 , 在 GenEval 和 DPGBench 上达到了 0.86 和 87.21 的成绩 。 如果使用 GPT-4o-Image 蒸馏数据 BLIP3o-60k , 通过两阶段策略(先进行有监督微调 SFT , 再进行 RecA 无监督训练) , Harmon 模型的性能进一步提升到 GenEval 0.90 , DPGBench 88.15 , 全面刷新了现有记录 。

对于 BAGEL , 我们发现其在图像编辑任务上也取得了显著提升 。 在 ImgEdit 基准上的评分从 3.38 提升至 3.75 , GEdit 评分从 6.94 上升到 7.25 。 经过 RecA 的 BAGEL 模型在某些编辑能力上超越最新的 SOTA 模型 , 如 Black Forest Labs 推出的 12 亿参数图像编辑模型 FLUX.1 Kontext 。

可视化效果

生成能力展示:

编辑能力展示:

训练前后的生成能力对比:

训练前后的编辑结果对比:

推荐阅读

- 质疑小米,理解小米,成为小米!

- 快手可灵团队MIDAS:压缩比64倍、延迟低于500ms,交互生成新突破

- 用光学生成图像,几乎0耗电,浙大校友一作研究登Nature

- MiniMax上线新一代音乐生成模型可生成整首歌曲 记者实测

- SOTA对话生成模型FireRedTTS-2来了,轻松做出AI播客!

- 英伟达新GPU,超长上下文/视频生成专用

- 基于通义万相 美图多款APP上线动漫特效、AI变身等视频生成功能

- ST-Raptor框架发布,实现复杂半结构化表格的精准理解与信息抽取

- 拍照直接生成讲视频,小艺深度解题Agent的可视化解题功能太神了

- 首个接入GPT-5的视频Agent!一句话生成广告大片,分镜配音全包了