文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

编辑:元宇

【新智元导读】苹果研究人员发现 , 在大模型中 , 极少量的参数 , 即便只有0.01% , 仍可能包含数十万权重 , 他们将这一发现称为「超级权重」 。 超级权重点透了大模型「命门」 , 使大模型走出「炼丹玄学」 。

0.01%参数定生死!

在删掉极少量参数后 , 大模型立刻变得胡言乱语起来 , 在零样本任务中只会瞎猜 , 原来的那股聪明劲儿全没了 。

【0.01%参数定生死!苹果揭秘LLM「超级权重」,删掉就会胡说八道】但是 , 如果保留这些极少量参数 , 即使删掉成千上万其他参数 , 大模型的智力依然在线 , 几乎看不出有什么影响 。

如果拿一棵树比喻 , 剪掉树(大模型)的几千片叶子(冗余参数)不会伤筋动骨 , 但只要砍掉树干上的一个关键节点(核心参数) , 整棵树可能就死掉了 。

这个核心参数 , 就是大模型中存在的极少数关键性/高敏感度参数 。

有时甚至只需一个 , 就能对大模型的整体功能产生巨大影响 。

论文地址:https://arxiv.org/abs/2411.07191

近日 , 苹果研究人员在论文《大语言模型中的超级权重》(The Super Weight in Large Language Models)中 , 将上述现象 , 称为「超级权重现象」 。

如上图1左侧显示 , 带有超级权重的原始Llama-7B , 能顺利接着生成合乎逻辑的内容 。

而在图1右侧 , 当超级权重参数被剪枝后 , Llama-7B就开始胡言乱语 , 生成的全是毫无意义的文本 。

这生动诠释了什么叫「打蛇打七寸」:

剪枝一个「超级权重」的特殊参数 , 就可以完全破坏大模型的能力 。

让大模型「科学瘦身」

「超级权重」的发现 , 为大模型在端侧部署 , 扫清了道路 。

在实际应用中 , 大模型庞大的体格(动辄数十亿甚至数千亿参数) , 想要部署在移动端等一些低预算、资源受限等环境中 , 就像把大象塞进冰箱 , 往往会面临巨大挑战 。

如果只是简单粗暴的等比压缩或简化 , 就好比削足适履 , 只会导致模型质量显著下降 。

更为合理的做法 , 是让大模型「科学瘦身」 , 比如缩小模型的规模和计算复杂度 , 从而降低内存与功耗 。

这时 , 超级权重就显得至关重要 。

在模型压缩和简化过程中 , 要避免碰到这些数量虽小 , 却牵一发而动全身的「命门级」参数 , 避免它们被显著修改(通过压缩)或被完全移除(剪枝) 。

即使它们的比例可以小到0.01% , 但对于拥有数十亿参数的模型 , 仍然意味着有数十万个单独权重 。

苹果研究人员发现 , 如果动了它们 , 就可能破坏LLM生成连贯文本的能力 , 比如让困惑度上升3个数量级 , 这样大模型就几乎「读不懂」语言了 。

又或者使大模型的零样本学习准确率降低到「瞎猜」的水平 , 这意味着大模型的智能也几乎废掉了 。

如何定位「超级权重」?

许多研究都显示出:少量最大幅值的异常值对模型质量至关重要 。

对于拥有数十亿参数的模型 , 极少量的参数 , 即便是只有0.01% , 仍可能包含数十万权重 。 苹果研究人员将称这个单标量权重为超级权重(super weight) 。

超级权重 , 会放大某个特征 , 产生超级激活 。

超级权重 , 会诱发相应稀有且幅度巨大的激活离群值 , 研究人员将之称为super activations(超级激活) 。

所谓激活 , 是指模型在前向传播时 , 每一层神经元的输出值 。

它们通常是在超级权重之后出现 , 并在随后的层中以一种恒定的幅度和位置持续存在 , 而不受输入提示词的影响 。

比如 , 一旦某个超级权重参与计算 , 它会把输入信号放大成异常大的数值 , 于是紧接着的层中就出现超级激活 。

并且 , 超级激活与超级权重所在通道一致 。

于是 , 研究人员就提出了一种高效定位超权重的方法:

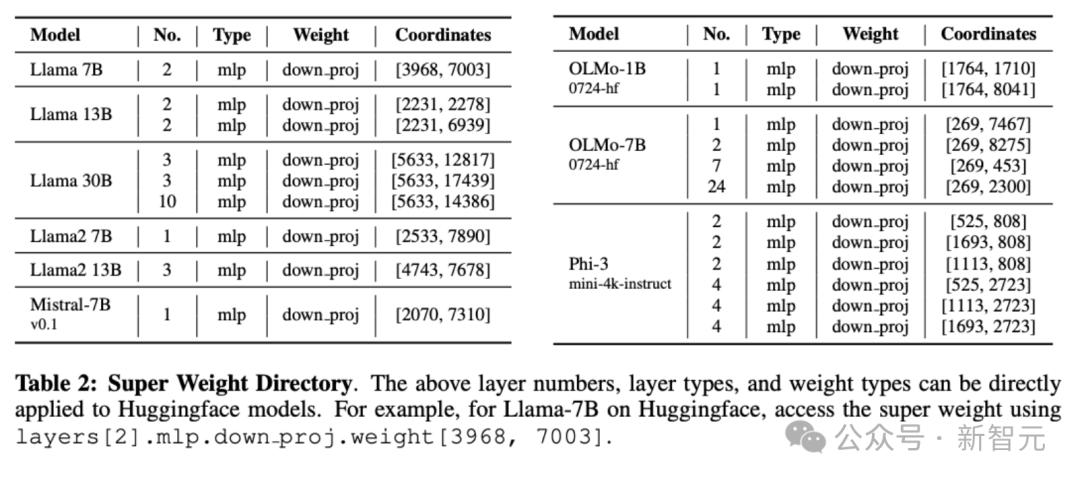

通过超级激活来定位超级权重:利用检测向下投影输入和输出分布跨层中的尖峰来定位超级权重 。

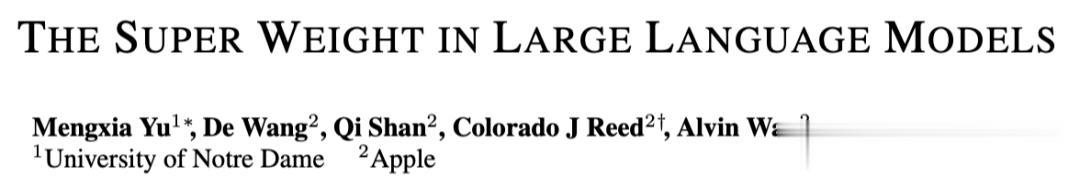

为了促进公开研究 , 研究人员还将一部分常见、公开可用的LLM超级权重标记了出来 , 如下表2:

研究人员发现 , 大多数模型每个张量中的超级权重不超过三个 。

即使超级权重数量最多的模型(例如Phi-3-mini-4k-instruct)也只包含六个 。

研究人员还通过图2 , 展示了超级权重触发超级激活 , 以及超级激活的传播机制 。

图2-I中蓝紫色方框中展示了超级权重的触发 , 它通常出现在较早层的down projection(降维投影) 。

这好比在一开始就有一个「功放器」 , 把某个信号突然放大到极高的音量 。

图2-Ⅱ中表示超级激活通过跳跃连接传播 , 用蓝紫色线表示 , 它表示激活不是一次性消失 , 而是层层跳跃传播下去 。

这好比扩音器的噪音通过音响的电路一路传到所有扬声器 , 无论后续放什么音乐 , 那个噪音始终存在 。

图2-Ⅲ中表示 , 在最终的输出logits(预测分布)里 , 超级激活会产生压制停用词(stopwords)的效果 。

而移除超级权重 , 会导致停用词可能性增加 , 用蓝紫色堆叠条表示 。

在图3中 , down_proj输入在层2中 , 仅有一个大幅度的激活值(super activation) , 这是超级激活首次出现的地方 。

图4表示 , 一旦在第2层被触发 , 超级激活会在随后的所有层中以相同的幅度、相同的位置持续存在 , 而不受输入的影响 。 如果把超级权重剪掉 , 超级激活的强度会下降75% 。

图5中显示了超级权重对停用词的抑制作用 。

研究人员发现 , 移除超级权重会导致停用词概率增加2-5倍 , 这在各种LLMs中都存在 。

同时 , 非停用词的概率急剧下降 , 减少2-3倍 , 低至0.1%的概率 。

整体上看 , 超权重会影响输出Token的概率分布 。

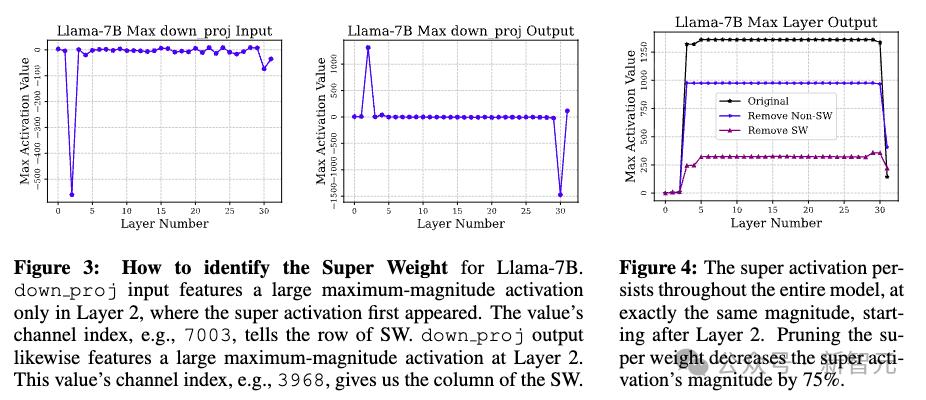

从图6可以看出 , 增强超权重 , 可以在一定程度上提高模型准确率 。

超级离群值

模型量化的「关键钥匙」

量化是压缩模型、降低模型内存需求的一种强有力技术 。

其中影响量化质量的 , 是一种重要的指标离群值(outliers) 。 研究人员将超级权重和超级激活统称为超级离群值 。

超级离群值 , 为人们认识大模型 , 改进大模型压缩技术 , 提供了一把重要的钥匙 。

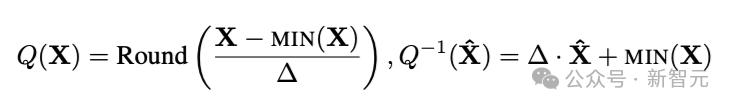

在该项研究中 , 研究人员考虑的是一种最简单的量化形式——即非对称的就近取重量化(asymmetric round-to-nearest quantization):

保留超级权重参数 , 是大模型「瘦身」的一个黄金原则 。

研究人员发现 , 只要以高精度保留超级激活 , 通过简单的就近取整(round-to-nearest)量化 , 也能将模型质量提升到与当前最先进方法相当的水平 。

如表3所示 , 在与FP16、Naive W8A8、SmoothQuant三种模型量化方法的比较中 , 就近取整量化虽然效果略次于SmoothQuant , 但优于Naive W8A8 , 尤其是在不需要校准数据的前提下 , 实用性更强 。

同样 , 如果在保留超权重的同时 , 对其他权重异常值进行裁剪 , 就近取整量化 , 也可以实现更好的压缩比 。

这意味着只需处理少量「超级离群值」 , 就能显著提升压缩质量 。

研究人员认为 , 与需要处理数十万离群权重的方法相比 , 这无疑是一种更友好的硬件方案 。

它可以在提升模型效率的同时 , 又能尽可能保留原有性能 。

这也使得强大的LLM应用 , 在资源受限的硬件上部署和高质量运行 , 成为可能 。

激活量化与权重量化

为了全面展示超级权重的影响 , 研究人员将研究范围扩大到更多大模型:OLMo(1B和7B版本)、Mistral-7B以及Llama-2-7B 。

表4显示 , 处理超级激活可以提升激活量化效果 。

研究人员遵循SmoothQuant的设置 , 用FP16算术模拟W8A8量化 。

研究结果凸显了超级激活 , 在量化期间维持模型性能的关键重要性 。

研究人员对Llama-7B的分析显示 , AWQ将超级权重放大了12倍 , 这印证了他们对超级权重重要性的判断 。

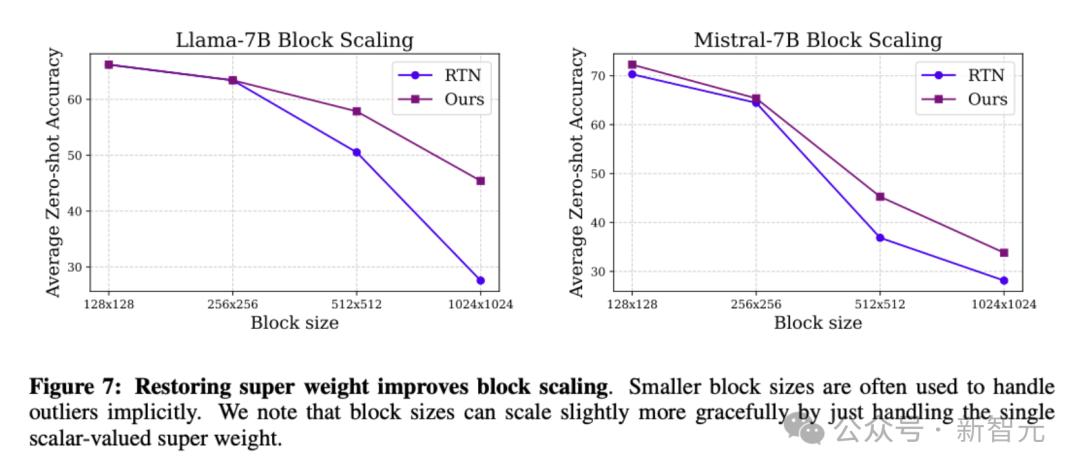

如图7 , 蓝线RTN显示 , 如果不处理超级权重 , 随着量化块变大 , 模型性能急剧下降;紫线Ours表示 , 如果恢复超级权重 , 模型准确率下降更平缓 , 即使大块量化也能维持较好性能 。

这说明 , 只要针对单个超级权重进行特殊处理 , 就能显著提高量化的稳定性和可扩展性 。

探索超级离群值的版图

苹果研究人员的发现 , 为未来研究打开了多条道路 。

毫无疑问 , 进一步探索超级权重与超级激活的起源及其精确机制 , 将对LLM的运行动态 , 带来更深入的洞见 。

同样的 , 理解这些超级权重参数 , 如何在训练过程中获得如此「超级」的影响力 , 也可以为未来的模型设计、训练策略提供更有针对性的指导 。

从另一个角度看 , 在更广泛的模型架构和训练范式中 , 展开对超级权重的研究 , 也有助于揭示它们的角色和形成机制 。

这些都将帮助我们解锁 , 构建更高效、更稳健、更可解释大模型的创新方法 , 让大模型告别「炼丹玄学」 。

作者简介

Mengxia Yu

Mengxia Yu是圣母大学计算机专业博士生 , 此前在北京大学获得计算语言学学士学位 , 本论文是她在苹果公司实习期间完成的 。

推荐阅读

- 刚刚,阿里首个超万亿参数新王登基!Qwen3-Max屠榜全SOTA

- 7000mAh顶配小屏!小米这新机,预定年度最强

- iPhone 17 Pro 限定款提前上架,这价格太离谱了

- 新形态 iPhone 定了,指纹回归!

- 智能体已重塑商业领导层决策制定过程

- 8.8英寸+SIM卡,华为新机定价3899元,你们要的通话平板终于来了

- 曝高通新旗舰Soc命名敲定:网友觉得太长了

- AI搜索引擎,苹果决定自研,代号WKA

- 真我15系列定档,定位“夜拍神器”

- 告别海量标注!浙大团队让GUI定位在无标签数据上自我进化