文章图片

【清华、上海AI Lab等团队发布推理模型RL综述,通往超级智能之路】

文章图片

文章图片

机器之心报道

编辑:冷猫

超高规格团队 , 重新审视RL推理领域发展策略 。

在人工智能的发展中 , 强化学习 (RL) 一直是一种非常重要的方法 。

自 1998 年 Sutton 提出强化学习概念以来 , 就明确了只要给出明确的奖励信号 , 智能体就能学会在复杂环境中超越人类 。

在 2013 年 , DeepMind 就展示过一个小实验:用 RL 训练的智能体 , 只凭屏幕上的像素和得分反馈 , 就能学会玩上世纪的街机游戏《打砖块》 。 几年后 , AlphaGo 和 AlphaZero 更是通过自我对弈和奖励信号 , 超越了世界顶尖棋手 , 在围棋、国际象棋和将棋上达到「人类难以企及」的水平 。

进入大模型时代后 , RL 又找到了新的舞台 。 它最初被用于让模型更符合人类偏好 , 比如通过人类反馈强化学习(RLHF) , 让模型的回答更有用、更诚实、更安全 。

最近几年 , 一个新的趋势正在出现:研究者们希望通过 RL 不仅让模型「更听话」 , 还真正学会「推理」 。

这类被称为大推理模型(LRM)的系统 , 会通过可验证的奖励来提升推理能力 , 例如数学题答对率或者代码能否通过测试 。 像 OpenAI 的 o1 和 DeepSeek-R1 就展示了这种方法的潜力:模型在经过 RL 训练后 , 能够更好地规划、反思 , 甚至在出错时自我纠正 。 这意味着 , 推理能力也许和参数规模、训练数据一样 , 可以通过「扩展」不断增强 。

然而 , 要让 RL 在大推理模型中真正实现大规模应用 , 还存在许多挑战:奖励设计是否合理 , 算法是否高效 , 数据和算力能否支撑等等 。

过去两个月里 , 来自清华大学和上海人工智能实验室等的研究者们组织并总结了推理模型的最新 RL 研究 , 形成了一份非常全面的调查综述 , 回顾最新进展 , 讨论面临的问题 , 并展望未来的发展方向 。

论文标题:A Survey of Reinforcement Learning for Large Reasoning Models 论文链接:https://arxiv.org/abs/2509.08827本文综述了近年来强化学习在大语言模型推理能力方面的最新进展 。

RL 在推动 LLM 能力边界上取得了显著成果 , 尤其在数学、编程等复杂逻辑任务中表现突出 。 因此 , RL 已逐渐成为将 LLM 演化为具备更强推理能力的大推理模型(LRM)的核心方法 。

随着该领域的快速发展 , 如何进一步扩展 RL 在 LRM 上的应用 , 已面临基础性挑战 —— 不仅涉及算力资源 , 也包括算法设计、训练数据与基础设施建设 。 为此 , 研究者们认为此时有必要回顾这一领域的发展历程 , 重新审视其未来方向 , 并探索提升 RL 可扩展性以迈向通用人工超级智能(Artificial SuperIntelligence ASI)的策略 。

本文重点梳理了自 DeepSeek-R1 发布以来 , RL 在 LLM 与 LRM 推理能力上的应用研究 , 涵盖其基础组件、核心问题、训练资源及下游应用 , 以此识别未来的研究机遇与发展路径 。 本文综述或许能够推动 RL 在更广泛推理模型中的研究与应用 。

综述概览

本文介绍了面向大推理模型的强化学习的基础组件 , 以及尚待解决的问题、训练资源和应用场景 。 本综述的核心重点在于:聚焦语言智能体(language agents)与环境之间的大规模交互 , 以及这一过程在长期演化中的关键作用 。

大模型发展时间线 。 展示了采用强化学习训练的具有代表性的推理模型的发展历程 , 其中包括开源和闭源的语言模型、多模态模型以及智能体模型 。

推理模型的两个重要里程碑(OpenAI o1 和 DeepSeek-R1 )表明 , 通过带有可验证奖励(RLVR)的训练 , 例如数学题答案正确率或代码单元测试通过率 , 可以让模型掌握长链推理能力 , 包括规划、反思和自我纠错 。

OpenAI 报告指出 , o1 的性能会随着额外的 RL 训练(训练时算力增加)以及推理阶段投入更多 “思考时间”(推理时算力增加)而持续提升, 揭示了除了预训练之外的一条全新扩展路径 。 DeepSeek-R1 则在数学任务中采用基于规则的显式准确率奖励 , 在编程任务中采用编译器 / 测试驱动的奖励 , 展示了大规模 RL(尤其是 Group Relative Policy Optimization GRPO)在基础模型上即可引导复杂推理能力的可能性 。

语言模型中 RL 方法的演变 , 展示了从 RLHF (2022) 到 DPO (2023) 再到 RLVR (2025) 以及未来开放式 RL 系统的进展 。 每个阶段都展示了任务解决能力和能力提升的增加 。

这种转变将推理重新定位为一种可以显式训练和扩展的能力 。 LRMs 在推理过程中会分配大量计算资源去生成、评估和修正中间推理链, 且其性能随着计算预算增加而提升 。 这种动态机制提供了一条与预训练时的数据规模和参数规模扩展互补的能力增长路径 , 同时利用奖励最大化目标 , 在存在可靠验证器的领域中实现自动可检验奖励 。 此外 , RL 还能通过生成自监督训练数据来克服数据限制 。 因此 , RL 越来越被视为在更广泛任务上实现通用人工超级智能(ASI)的潜在技术路径 。

然而 , 面向 LRMs 的 RL 扩展也带来了新的挑战 , 不仅限于计算资源 , 还涉及算法设计、训练数据和基础设施 。 如何以及在哪些方面扩展 RL 才能实现更高水平的智能并产生现实价值 , 仍是悬而未决的问题 。 因此 , 研究者们认为 , 现在正是重新审视这一领域发展、探索增强 RL 可扩展性策略的关键时机 。

本文的综述工作如下:

在 LRM 语境下引入 RL 建模的基本定义 , 并梳理自 OpenAI o1 发布以来的前沿推理模型发展 。 回顾 RL for LRM 的核心组成部分 , 包括奖励设计、策略优化和采样策略 , 并对不同研究方向和技术方案进行比较 。 讨论 LRM 强化学习中的基础性与争议性问题 , 例如 RL 的角色、RL vs. SFT、模型先验、训练方法以及奖励定义 , 并指出这些问题需要深入探索以推动 RL 的持续扩展 。 总结 RL 的训练资源 , 包括静态语料库、动态环境和训练基础设施 , 并指出这些资源尽管可复用 , 但仍需进一步标准化和发展 。 综述 RL 在广泛任务中的应用 , 涵盖编程任务、智能体任务、多模态任务、多智能体系统、机器人任务以及医学应用 。 最后 , 探讨未来 RL for LLM 的研究方向 , 包括新算法、新机制、新功能以及其他潜在研究路径 。

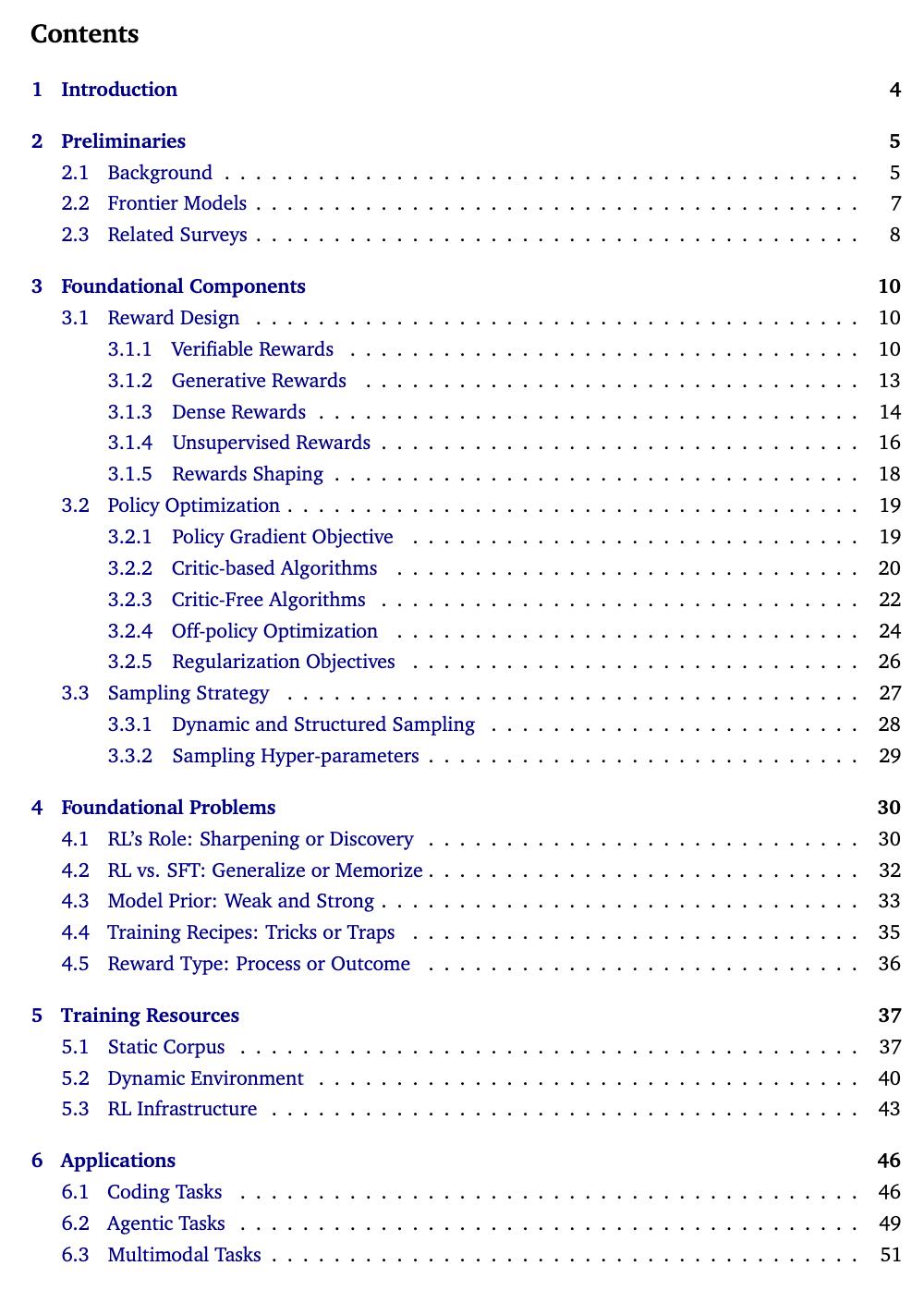

综述目录

强化学习在大推理模型上的应用 , 标志着人工智能发展的一次重要转折 。 它不仅仅是让语言模型「对齐」人类的偏好 , 更是在推动它们真正掌握推理和逻辑思考的能力 。 通过可验证的奖励机制、先进的优化算法以及大规模的训练基础设施 , 研究者们正在打造能够进行多步推理、跨领域解决问题的智能系统 。

当然 , 这一方向仍面临不少挑战:如何设计合适的奖励信号、如何在庞大的算力和数据需求下实现高效扩展、以及如何确保这些模型在实际应用中可靠 。 尽管如此 , 近年的快速进展已经证明了这一方法的潜力 。 可以预见 , 未来基于 强化学习的推理能力还将持续提升 , 并有望孕育出能够真正理解和解决复杂问题的智能系统 , 从而在科学研究、工程应用乃至日常生活的方方面面 , 带来深远的影响 。

更多详细信息请参阅原论文 。

推荐阅读

- 快手可灵团队MIDAS:压缩比64倍、延迟低于500ms,交互生成新突破

- 超过三星、LG之和,京东方成苹果电脑屏最大供应商

- 外滩大会看未来生活丨前沿科技照进现实,交流、餐饮、出行场景都将改变

- 魅族22今日发布:6.3英寸小屏影像旗舰、行业唯一白面板

- 苹果iPhone 17全系包装盒亮相:继续环保 无塑封、无充电头

- ipad平替电容笔哪个款式好用点?益博思、西圣、wiwu三大热门平替笔推荐!

- 王兴兴、朱啸虎们说了些AI创业真心话

- 魅族22发布前瞻:屏幕、性能、影像、价格,基本都清晰了

- 打印纸选购指南:克重、材质怎么挑才合适?

- 小米澎湃OS 3第二批Beta版开启招募:覆盖REDMI K80、小米M