文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

曾几何时 , 我们对大模型的需求是“智能涌现” , 是能够滔滔不绝为我们提供内容 , 什么问题都能给出令人眼花缭乱的回复 。 初见这种能力时的讶然与惊喜 , 在今天依旧令人难忘 。

但类似体验多了之后 , 我们开始发现好像有哪里不对 。 大模型确实对答如流 , 但准确性与实用性却不能够保证 , 经常出现答非所问 , 错误理解的问题 , 尤其还有广受诟病的大模型幻觉 。 记得有一次我想让AI帮我规划一天的Citywalk行程 , 某款颇具国民度的大模型为我规划了五个地点 。 结果在出门后才发现 , 五个地方有三个是它编造臆想出来的 , 还有一个已经倒闭多时了 。 这就是因为大模型最终的推理结果不够精准 , 不够实用 。 长此以往下去 , 大模型就很容易失去它最为关键的工具性价值 , 转而沦为一种极客玩具 。

北斗七星 , 是罗盘发明之前最重要的导航参照物 。 这七颗星有着辨识度极高的形状 , 并且永恒将勺柄指向正北方 。 有时候我会想 , 我们对大模型推理的需求不是它能给出漫天繁星般的答案 , 而是要给出北斗七星一样精准、有效、有用的反馈 。

【如果大模型是一片星空,谁是北斗?】

9月9日 , WAVE SUMMIT深度学习开发者大会2025在北京举行 。 会上 , 百度首席技术官、深度学习技术及应用国家工程研究中心主任王海峰发布了文心大模型X1.1深度思考模型 。 该模型在事实性、指令遵循、智能体等能力上均有显著提升 。

王海峰介绍 , 文心大模型X1是基于文心大模型4.5训练而来的深度思考模型 , 升级后的X1.1相比文心X1 , X1.1的事实性提升34.8% , 指令遵循提升12.5% , 智能体提升9.6% 。

经过实测之后我们发现 , 文心大模型X1.1确实带来了如齿轮咬合运转一般的精准推理效果 , 全面强化了大模型在调用工具与智能体等领域的实用性 。

大模型的未来不能仅仅是花团锦簇 , 而应该是训练稳如泰山 , 推理准如北斗 。 基于飞桨文心联合优化等优势 , 具有全栈AI布局的百度 , 正在让这一切成为可能 。

大模型依旧会面对诸多问题 , 这已经是全球AI行业的普遍认识 , 同时也是AI技术持续发展面对的最大瓶颈之一 。

前不久 , OpenAI在其发表的《Why Language Models Hallucinate》文章中就承认 , “ChatGPT也会产生幻觉 。 GPT-5的幻觉虽然明显更少 , 但在执行推理时幻觉仍然会发生 。 幻觉是所有大型语言模型面临的一大根本挑战” 。

而事实上 , 大模型幻觉只是模型表现不佳的一个缩影 。 在今天 , 绝大多数大模型都会面临着“虚实难题” 。 即大模型虽然能够生成诸多内容 , 但其依旧缺乏实用性 , 无法在真正的学习、工作场景中产生实际价值 。 总结起来 , 大模型无法走向实用化 , 问题有以下几种鲜明表现:

1.事实不清 。 大模型幻觉会导致模型推理出与事实不符的答案 。 我们甚至见到过大模型为了证明自身给出的结论 , 去编造新闻报道甚至历史文献 , 这种虚虚实实的推理结果 , 令人防不胜防 。

2.无法准确驱动智能体与垂直工具 。 模型推理需要与更多专业工具、垂类智能体进行紧密结合 , 但大多数大模型都还不具备在推理侧准确调用智能体的能力 , 导致整个推理体验非常割裂 。

3.对用户指令理解不明确 。 当我们下达一些感情化、情绪化 , 或者较为复杂的指令时 , 大模型往往会陷入无法应对的怪圈 , 最终只能强行给我们一些错误无效的反馈 。

文心大模型X1.1的出现 , 让我们有机会击破这些推理困境 , 走向真正的实用主义AI 。

2025年3月16日 , 百度发布了深度思考模型X1 , 随后在4月更新了X1 Turbo 。 XI系列模型的特点是强化深度思考能力 , 能够有效处理诸如逻辑分析、数学解答、专业知识调用等AI需求 。 而最新发布的文心大模型X1.1 , 则在智能体、工具调用、指令遵循、事实性等任务上有着出色的表现 , 较比此前版本与业界其他大模型 , 在问答、创作、逻辑推理等方面的综合能力明显提升 。

让我们来看看这款模型在推理任务中的表现究竟怎样 。

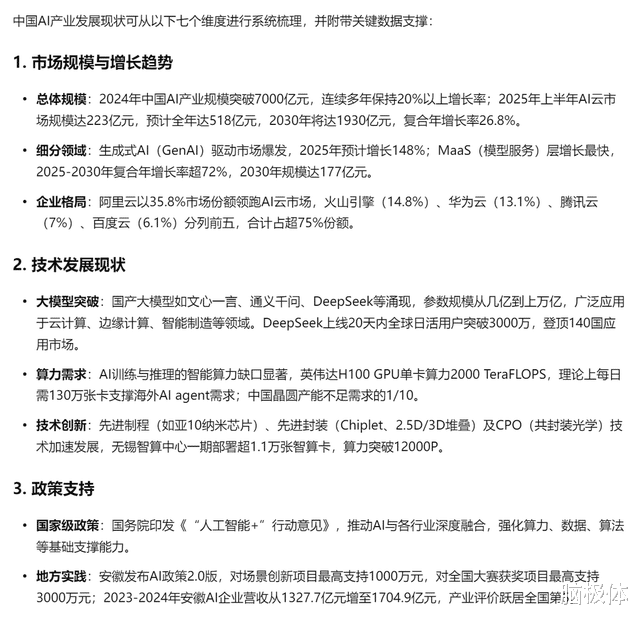

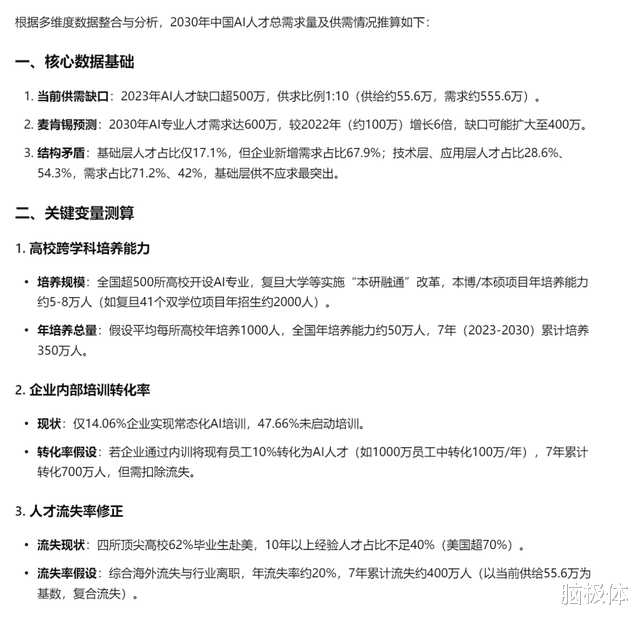

首先我提出了一个关于中国AI行业发展的问题 , 但不同之处在于我要求文心大模型X1.1通过七个维度进行分析 , 来考验一下大模型的事实性效果 。

这个问题对于大模型来说非常好回答 , 但想要列出七个维度 , 并且确保有数据 , 没有事实错误 , 那其实还是非常困难的 , 来看看文心大模型X1.1的表现如何 。

可以看到 , 文心X1.1确实找到了七个维度进行分析的方法 , 不同维度之间没有出现大部分模型都可能出现的意义重叠、指向不清等问题 , 并且每一个维度都列出了相关案例与数据 , 而且这些内容都没有与事实不相符的情况出现 。 可以看到文心大模型X1.1在事实性回答上的准确度已经显著提升 。 为了对比 , 我们也评测了其他几款主流大模型 , 回答效果较比文心X1.1都有着明显的差距 , 大家可以自行对比、感受一下 。

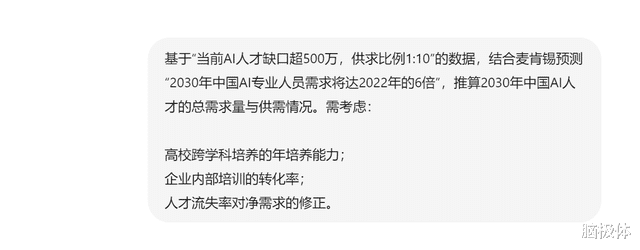

让我们来测试一个文心X1.1对复杂指令的理解与遵循能力 。 延续上一个关于中国AI产业分析的问题 , 我问文心X1.1这样一个关于中国AI人才的问题:

这个问题非常复杂 , 需要考虑的数据与影响要素很多 , 绝大多数大模型都会被这样的复杂指令绕晕 , 然后给出与问题无关的推理结果 。 当然 , 别说是AI了 , 相信绝大多数人类也无法完成如此复杂的问题 。 让我们来看看文心X1.1的答案 。

首先 , 它的计算过程就非常复杂严谨 。

接下来在最终的结果计算中 , 也给出了较为可信的供需计算过程与最终答案 。

我们可以再来看看文心X1.1在工具调用方面的效果 。 为此 , 我上传给文心X1.1一本超过12万字的《伽利略传》 , 让它来帮我进行内容梳理 。 由于这是布莱希特创作的一本戏剧剧本 , 因此理解难度和总结难度都比较大 。

而最终文心X1.1调用了文档问答这一工具 , 对长文本进行了快速理解 , 并高效率给出了答案 。

可以看到 , 文心X1.1不仅关注到了内容本身 , 还总结了作者、译者的相关内容 , 给出了文档内容之外的深度思考 。

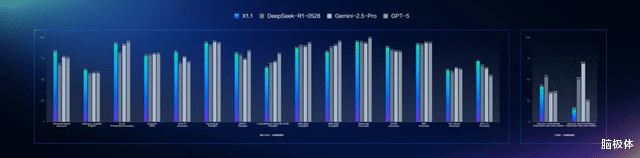

在这些推理能力的实际改善、增强下 , 能够看到在多个权威基准评测中 , 文心X1.1整体表现超越了DeepSeek R1-0528 , 在部分任务上展现出领先优势 , 并且与国际顶尖模型GPT-5和Gemini 2.5 Pro效果持平 。

目前 , 用户已经可以在文心一言官网、文小言APP使用文心大模型X1.1 。 并且其已正式上线百度智能云千帆平台 , 对企业客户及开发者全面开放使用 。

那么 , 究竟是什么支撑起了文心X1.1的能力全面升级?

这就要提到文心X1.1背后创新的模型训练方法 。 为了实现更好的强化学习模型训练目标 , 百度对文心X1.1采用了迭代式的混合强化学习训练框架 , 一方面通过混合强化学习同时融合提升通用任务和智能体任务的效果;另一方面通过自蒸馏数据的迭代式生产及训练不断提升模型整体效果 。 此外 , 通过多项技术创新让文心X1.1在智能体、指令遵循和事实性方面表现出更出色效果 。

并且 , 文心X1.1还采用了基础模型和策略模型知识一致性的强化学习训练 。 在训练过程中 , 不断校验后训练模型和预训练模型知识的一致性 , 从而让模型事实性得到了大幅提升 , 规避了大模型幻觉的滋生可能性 。

除此之外 , 文心X1.1还采用了基于检查清单和指令验证器的强化学习训练让模型在复杂指令遵循方面的效果明显提升;通过基于思维和行动链的多轮强化学习训练 , 让模型在思考过程中将思维链和行动链结合 , 从而提升了智能体和工具调用方面的能力 。

这一系列强化学习模型训练方式的更新迭代 , 都是基于百度对大模型推理瓶颈的核心洞察与解决方案思考 , 最终造就了文心X1.1的推理效果 。 而更进一步说 , 发现问题之后还要能够解决问题 。 文心X1.1能够以超高速完成大幅迭代 , 离不开其背后稳如泰山的训练推理综合能力 。

在当前产业环境下 , 我们可以发现AI大模型正发生着飞速的变化 , 让人有眼花缭乱的感觉 。 但如果仔细看这些升级 , 却会发现绝大多数大模型在核心技术能力上的提升都比较有限 , 彼此间的同质化严重 。 然而在这样的整体走势下 , 文心X1.1却展现出了另一种升级模式:以核心技术提升整体能力 , 做到短时间跨越式升级 。

而稍微放大视角就会发现 , 这不是只出现在文心X1.1上的孤例 。 从多粒度知识融合学习、知识和数据融合学习 , 到知识增强、知识点增强 , 从检索增强、逻辑推理增强 , 到慢思考、深度思考、多模态 , 百度始终保持着大模型的效果的高速升级 , 以及训推能力的全面迭代 。 能够实现这一目标的深层动力 , 是百度构筑了稳固、高效、可持续的大模型能力提升动力源泉——这就是文心飞桨联合优化 。

文心与飞桨的配合 , 既包括框架-模型的联合优化 , 也包括框架-算力的联合优化 , 既有提升训练性能的创新 , 也有提升推理吞吐的创新 。 在最新发布的飞桨框架v3.2中我们可以看到 , 其在?模型训练、大模型硬件适配、主流?模型及高性能加速库的支持上全面提升 , 这就将有助于进一步解决大模型的训练技术难题 , 提高训练效率 , 而这些价值也将被充沛释放到文心大模型当中 。

在训练层面 , 能够看到最新发布的飞桨框架v3.2在计算、并行策略、容错能力三方面进?步升级 。 极致计算优化方面 , 提出了存算重叠的稀疏掩码注意力计算FlashMask V3 , 同时实现了高效的FP8混合精度效果?损训练技术 。 高效并行策略方面 , 提出了动态?适应的显存卸载策略 , 以及创新设计的显存友好的流水线并行调度 , 进一步降低显存开销 。 框架原生容错能力方面 , 实现了大规模集群训练容错系统 , 在线监测静默数据损坏等难以察觉的故障 , 并实现了高可用的检查点容灾方法 , 降低中断恢复损失 。 经过上述优化 , ??X1.1及4.5系列模型均获得了优异的性能表现 , 并在文心最?规模的4.5?本模型ERNIE-4.5-300B-A47B的预训练上取得了47% MFU 。

而在推理层面通过卷积编2比特极致压缩 , 可插拔稀疏化轻量注意力 , 混合动态自适应多步投机解码 , 通信存储计算深度协同优化的大规模P/D分离部署等技术 , 提供大模型高效部署及高性能推理全栈能力 。 在文心4.5激活参数量47B、总参数量300B的模型ERNIE-4.5-300B-A47B上 , 通过上述系统性优化 , 在TPOT 50ms时延条件下 , 实现了输入吞吐高达57K、输出吞吐29K的卓越性能表现 。

模型要准 , 基座要稳 。 文心飞桨联合优化就提供了这样的AI发展基座 。 文心飞桨的联合优化与双层开源 , 构成了百度在大模型技术上的特色与优势 。 这样的优势将源源不断释放到大模型的最终表现与用户体验上来 , 文心X1.1就是最好的证明 。

文心X1.1的优秀表现最终证明了这样一件事:大模型不是孤立存在的 , 它必须要与整体性的AI基础设施进行紧密结合 , 是整个AI体系的一部分 。 而大模型的进化与成长 , 也与AI体系的完整性、成熟性紧密相关 。 或许在我们对标某项技术、某种技术特性时 , 可以通过集结人才、集中攻克等方式对这些技术进行模仿 。 但在此之后 , 当大模型要走上独立发展、持续迭代的道路 , 就必须依靠AI基座的支撑 。

在大模型喧哗初散 , 同质化竞争开始复现时 , 百度重底座 , 重视AI全栈布局的战略价值反而得到了证明与突显 。 AI从最底层的芯片到最上层的应用 , 总共分为芯片-框架-模型-应用四层架构 。 而百度是全球为数不多进行全栈布局的AI公司 。 从昆仑芯 , 到飞桨深度学习框架 , 再到文心大模型 , 以及多个领域中领先的AI应用产品 , 百度在每一层都有关键自研技术 , 并且能够有效获得层层之间的反馈 , 实现端到端优化 。 这种把群星连为星河的战略方向 , 让百度能够持续提供高性价比、拥有核心技术优势的AI产品与解决方案 。 对于AI行业来说 , 文心X1.1的价值或许是证明了这种重视基座 , 重视全栈布局战略的预见性与长期主义价值 。

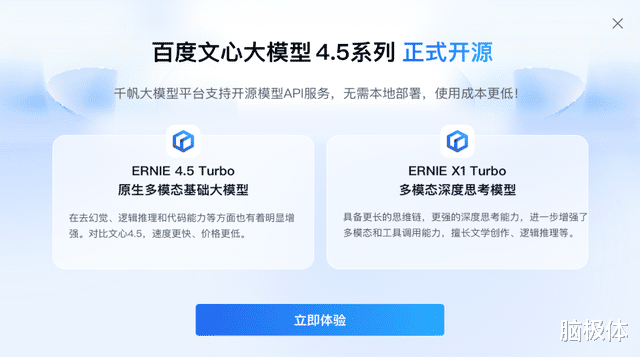

当前 , 百度的文心与飞桨双层开源格局不断强化 。 6月30日 , 百度正式开源文心大模型4.5系列模型 , 涵盖47B、3B激活参数的混合专家(MoE)模型 , 与0.3B参数的稠密型模型等10款模型 , 并实现预训练权重和推理代码的完全开源 。 目前 , 文心大模型4.5系列开源模型已经在行业得到了广泛的应用 , 实现了有效的开源生态构建 。

最新数据披露 , 飞桨文心生态开发者达到2333万 , 服务企业达到76万家 。 广生态、厚底座、快模型的AI战略 , 正在帮助百度探索AI时代更广阔的可能性 。

推荐阅读

- 安兔兔手机好评榜洗牌:iQOO Z10 Turbo+排名第七,第一名还是它

- AirPods Pro 3的到来,预示着它已不再只是一副“耳机”

- 直击IFA三星馆:AI Home是新瓶装旧酒,但生态协同是大势所趋

- 并非17 Air,而是iPhone Air 超薄iPhone登场

- 抖音鼓励长图文内容,是要搞“文艺复兴”?

- 1799元起!OPPO“耐用战神”再更新,抗摔防水只是基本?

- 还是LG和三星!iPhone 17 Pro屏幕爆料,网友:让子弹飞一会儿

- Altman亲自发博客点赞,这两大杰出人才是谁?

- 选本别跟风!Lunar Lake轻薄本领跑行业,持久好用才是王道

- 不只是智能清洁!追觅IFA2025秀出智能全家桶,狂揽9项官方大奖!