文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

作者|程茜

编辑|心缘

智东西2月25日报道 , 刚刚 , DeepSeek开源周第二弹发布 , 第一个用于MoE模型训练和推理的开源EP通信库 , 发布不到一小时 , GitHub Star数已上千 。

DeepEP是为混合专家(MoE)和专家并行(EP)量身定制的通信库 , 其提供高吞吐量且低延迟的全对全GPU内核 , 这些内核也被称为MoE调度与合并 。

高性能:支持用于节点内和节点间通信的NVLink和RDMA , 以及用于非对称域带宽转发的优化内核;

低精度运算:FP8支持;

延迟敏感推理:提供使用纯RDMA的低延迟内核 , 以最大限度地减少推理解码的延迟;

通信-计算重叠:引入基于钩子的方法 , 不会占用任何流式多处理器(SM)资源;

自适应路由和流量隔离:支持低延迟内核自适应路由 , 支持虚拟通道流量隔离 。

其中 , 为了与DeepSeek-V3论文中提出的组限制门控算法(group-limited gating algorithm)保持一致 , DeepEP提供了一组针对非对称域带宽转发进行优化的内核 , 例如将数据从NVLink域转发到RDMA域 。 这些内核能够实现高吞吐量 , 使其既适用于训练任务 , 也适用于推理预填充任务 。 此外 , 它们还支持流式多处理器(SM)数量控制 。

对于对延迟敏感的推理解码任务 , DeepEP包含了一组采用RDMA技术的低延迟内核 , 以最大程度地减少延迟 。 该库还引入了一种基于钩子的通信与计算重叠方法 , 这种方法不会占用任何流式多处理器(SM)资源 。

DeepSeek指出 , DeepEP的实现可能与DeepSeek-V3论文中略有不同 。

GitHub地址:https://github.com/deepseek-ai/DeepEP

具体性能方面:

在H800(NVLink的最大带宽约为160 GB/s)上测试常规内核 , 每台设备都连接到一块CX7 InfiniBand 400 Gb/s的RDMA网卡(最大带宽约为50 GB/s) , 并且遵循DeepSeek-V3/R1预训练设置(每批次4096个Tokens , 7168个隐藏层单元 , 前4个组 , 前8个专家(模型) , 使用FP8格式进行调度 , 使用BF16格式进行合并) 。

在H800上测试低延迟内核 , 每台H800都连接到一块CX7 InfiniBand 400 Gb/s的RDMA网卡(最大带宽约为50 GB/s) , 遵循DeepSeek-V3/R1的典型生产环境设置(每批次128个Tokens , 7168个隐藏层单元 , 前8个专家(模型) , 采用FP8格式进行调度 , 采用BF16格式进行合并) 。

快速启动要求:

下载并安装NVSHMEM依赖项:

开发:

安装:

网络配置:

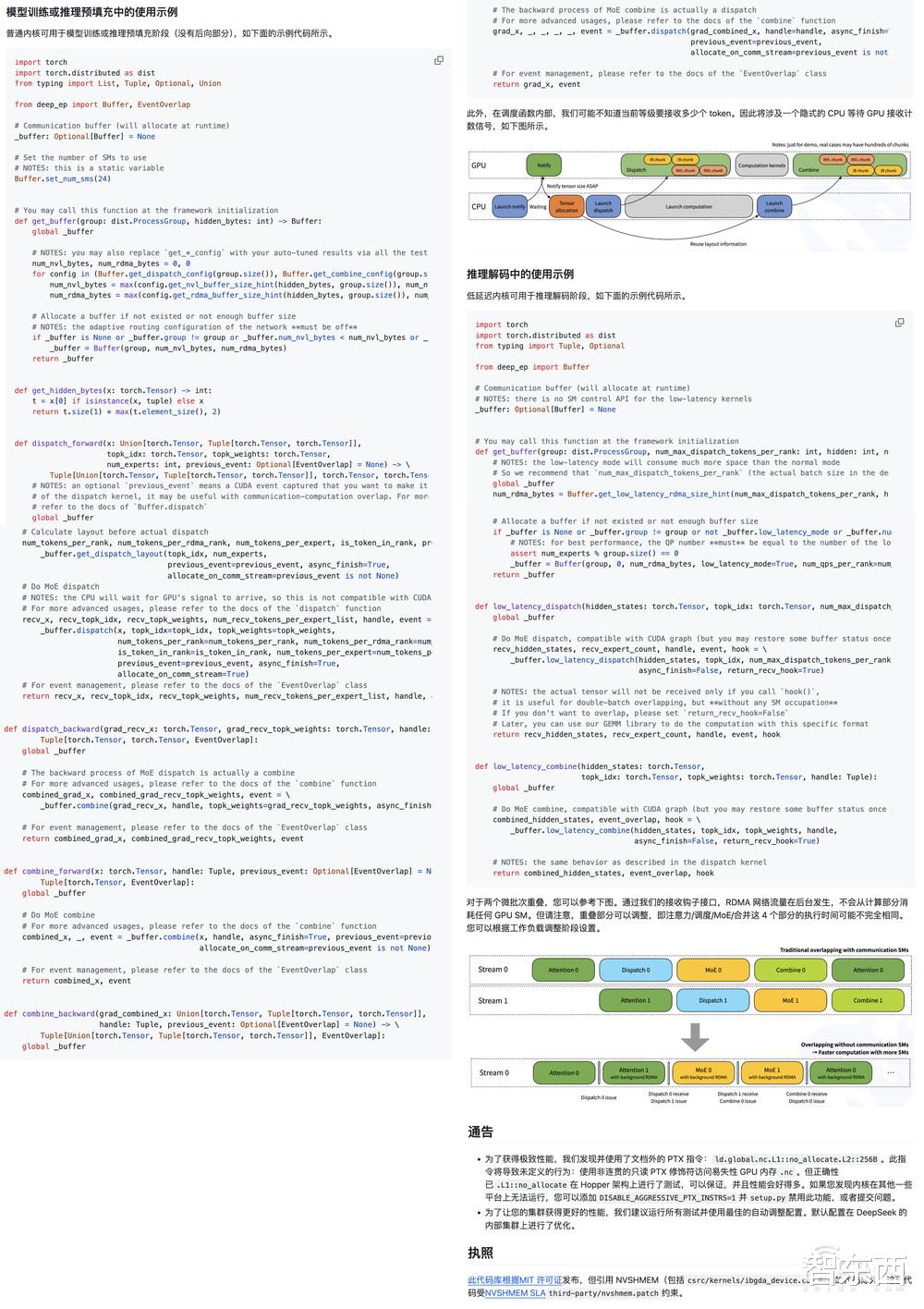

接口和示例:

DeepSeek发布的推文一小时浏览量高达12万 , 评论区下方开发者们直接进入夸夸夸模式:

“DeepSeek在MoE模型方面所实现的优化程度颇高 , 而MoE模型因其规模和复杂性而向来极具挑战性 。 DeepEP能够借助像NVLink和RDMA这类尖端硬件 , 如此精准地处理相关任务 , 并且还支持FP8格式 , 这着实令人惊叹 。 ”

“对NVLink和RDMA的支持 , 为大规模的MoE模型带来了变革性的影响 。 看来DeepSeek又一次突破了AI基础设施的极限 。 ”

还有人直接做了表情包:“跟着鲸鱼找到鱼 。 ”

结语:深度探索开源宇宙DeepSeek还有三弹重磅发布从带飞GPU推理速度的FlashMLA到开源EP通信库 , DeepSeek开源周第二大重磅发布再次点燃AI圈的热情 。 本周后续 , DeepSeek还将开源三个代码库 , 或许会与AI算法优化、模型轻量化、应用场景拓展等相关 , 涵盖多个关键领域 。

【DeepSeek又又开源了,这次拉爆GPU通信!】期待接下来的三场技术盛宴 , 向开源者们致敬 。

推荐阅读

- DeepSeek今日启动开源周:公布首个开源代码库Flash MLA

- 只有3000本金,摆地摊做什么最赚钱?DeepSeek的回答太有实操性

- 算力正宗第一龙头,与DeepSeek深度合作,机构加仓5亿,有望翻10倍

- 为啥DeepSeek官方总是“系统繁忙”,而满血版却很流畅?

- 极目新闻记者实测:“移动医生”快速问诊开药方,DeepSeek看病靠谱吗?

- DeepSeek警告:这9种“伪养生”行为,正在摧毁中年人健康

- 马斯克尴尬了,20万显卡堆的Grok3,1天就被Deepseek打败了?

- Deepseek,是福是祸,全由你操纵

- 马斯克发声:深度质疑中国AI初创公司DeepSeek的GPU使用情况

- Grok-3发布会翻车!同日DeepSeek甩出核弹级论文,国产AI再进化!